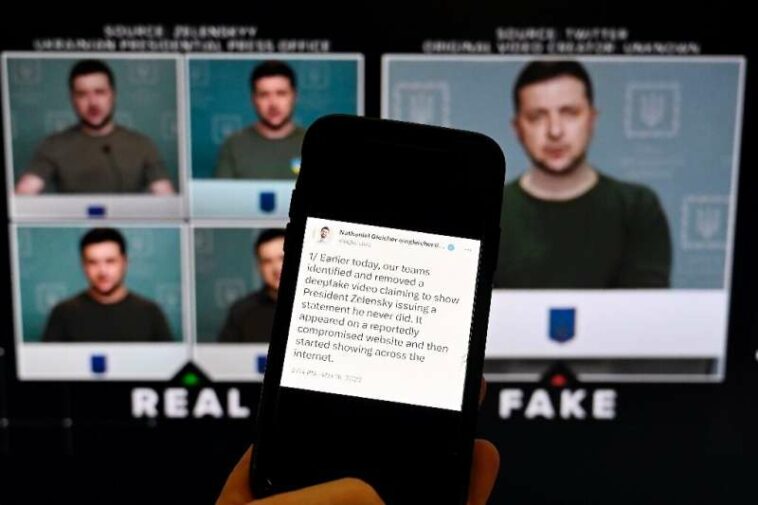

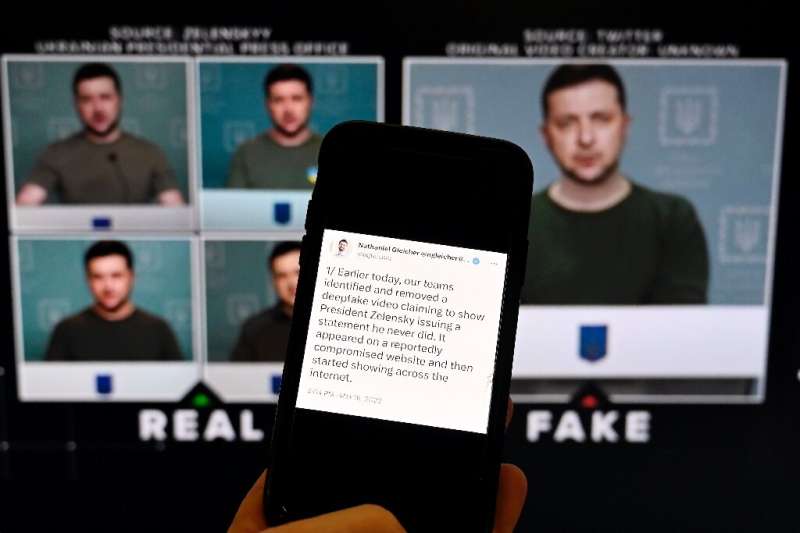

Un teléfono muestra una declaración del jefe de política de seguridad en Meta frente a un video falso del presidente ucraniano Volodymyr Zelensky llamando a sus soldados a deponer las armas.

Chatbots que escupen falsedades, aplicaciones de intercambio de caras que crean videos pornográficos y voces clonadas que defraudan a millones de empresas: la lucha está en marcha para frenar las falsificaciones profundas de IA que se han convertido en un súper propagador de desinformación.

La inteligencia artificial está redefiniendo el proverbio «ver para creer», con una avalancha de imágenes creadas de la nada y personas que se muestran pronunciando cosas que nunca dijeron en deepfakes de aspecto real que han erosionado la confianza en línea.

«Vaya. (Definitivamente) yo no», tuiteó el multimillonario Elon Musk el año pasado en un vívido ejemplo de un video falso que lo mostraba promocionando una estafa de criptomonedas.

China adoptó recientemente reglas expansivas para regular las falsificaciones profundas, pero la mayoría de los países parecen estar luchando para mantenerse al día con la tecnología de rápida evolución en medio de preocupaciones de que la regulación podría obstaculizar la innovación o ser mal utilizada para restringir la libertad de expresión.

Los expertos advierten que los creadores superan con creces a los detectores de falsificaciones profundas, ya que son difíciles de atrapar ya que operan de forma anónima utilizando un software basado en IA que alguna vez se promocionó como una habilidad especializada pero que ahora está ampliamente disponible a bajo costo.

El propietario de Facebook, Meta, dijo el año pasado que eliminó un video falso del presidente ucraniano Volodymyr Zelensky instando a los ciudadanos a deponer las armas y rendirse a Rusia.

Y la activista británica Kate Isaacs, de 30 años, dijo que su «corazón se hundió» cuando su rostro apareció en un video porno falso que desató un aluvión de abusos en línea luego de que un usuario desconocido lo publicara en Twitter.

«Recuerdo sentir que este video iba a ir a todas partes, era horrible», dijo Isaacs, quien hace campaña contra la pornografía no consentida, según la BBC en octubre.

El mes siguiente, el gobierno británico expresó su preocupación por las falsificaciones profundas y advirtió sobre un sitio web popular que «prácticamente desnuda a las mujeres».

‘Apocalipsis de la información’

Sin barreras para crear texto, audio y video sintetizados por IA, el potencial de uso indebido en el robo de identidad, el fraude financiero y el empañamiento de la reputación ha provocado una alarma mundial.

El grupo Eurasia llamó a las herramientas de IA «armas de disrupción masiva».

“Los avances tecnológicos en inteligencia artificial erosionarán la confianza social, empoderarán a los demagogos y autoritarios y perturbarán los negocios y los mercados”, advirtió el grupo en un informe.

«Los avances en deepfakes, reconocimiento facial y software de síntesis de voz harán que el control sobre la imagen de uno sea una reliquia del pasado».

Esta semana, la startup de inteligencia artificial ElevenLabs admitió que su herramienta de clonación de voz podría usarse indebidamente con «propósitos maliciosos» después de que los usuarios publicaran un audio falso que pretendía ser la actriz Emma Watson leyendo la biografía de Adolf Hitler «Mein Kampf».

Elon Musk tuiteó «Yikes. Def not me» sobre un video falso de él supuestamente promocionando una nueva estafa de criptomonedas.

El creciente volumen de deepfakes puede conducir a lo que la agencia europea de aplicación de la ley, Europol, describió como un «apocalipsis de la información», un escenario en el que muchas personas no pueden distinguir la realidad de la ficción.

«Los expertos temen que esto pueda conducir a una situación en la que los ciudadanos ya no tengan una realidad compartida o podría crear confusión social sobre qué fuentes de información son confiables», dijo Europol en un informe.

Eso quedó demostrado el fin de semana pasado cuando el jugador de la NFL Damar Hamlin habló con sus fanáticos en un video por primera vez desde que sufrió un paro cardíaco durante un partido.

Hamlin agradeció a los profesionales médicos responsables de su recuperación, pero muchos de los que creían en las teorías de conspiración de que la vacuna COVID-19 estaba detrás de su colapso en el campo sin fundamento calificaron su video como una falsificación profunda.

‘Súper esparcidor’

China impuso nuevas reglas el mes pasado que requerirán que las empresas que ofrecen servicios falsos obtengan las identidades reales de sus usuarios. También requieren que el contenido deepfake esté debidamente etiquetado para evitar «cualquier confusión».

Las reglas se produjeron después de que el gobierno chino advirtiera que las falsificaciones profundas presentan un «peligro para la seguridad nacional y la estabilidad social».

En los Estados Unidos, donde los legisladores han presionado por un grupo de trabajo para vigilar las falsificaciones profundas, los activistas de los derechos digitales advierten contra la extralimitación legislativa que podría acabar con la innovación o apuntar al contenido legítimo.

Mientras tanto, la Unión Europea está inmersa en acaloradas discusiones sobre su propuesta «Ley de IA».

La ley, que la UE se está apresurando a aprobar este año, requerirá que los usuarios divulguen las falsificaciones profundas, pero muchos temen que la legislación resulte inútil si no cubre el contenido creativo o satírico.

«¿Cómo restablecer la confianza digital con transparencia? Esa es la verdadera pregunta en este momento», dijo a la AFP Jason Davis, profesor de investigación en la Universidad de Syracuse.

«Las herramientas (de detección) están llegando y lo están haciendo con relativa rapidez. Pero la tecnología se está moviendo quizás incluso más rápido. Entonces, como en el caso de la seguridad cibernética, nunca resolveremos esto, solo esperamos mantenernos al día».

Muchos ya están luchando por comprender avances como ChatGPT, un chatbot creado por OpenAI con sede en EE. UU. que es capaz de generar textos sorprendentemente convincentes sobre casi cualquier tema.

En un estudio, el regulador de medios NewsGuard, que lo llamó el «próximo gran propagador de información errónea», dijo que la mayoría de las respuestas del chatbot a las indicaciones relacionadas con temas como COVID-19 y tiroteos en escuelas fueron «elocuentes, falsas y engañosas».

«Los resultados confirman los temores… sobre cómo la herramienta puede convertirse en un arma en las manos equivocadas», dijo NewsGuard.

© 2023 AFP

Citación: ¿Ver es creer? Lucha global para abordar los deepfakes (2 de febrero de 2023) recuperado el 2 de febrero de 2023 de https://techxplore.com/news/2023-02-believing-global-scramble-tackle-deepfakes.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.