La computación en la nube está impulsando una nueva era de datos e inteligencia artificial al democratizar el acceso a infraestructura y servicios escalables de cómputo, almacenamiento y redes. Gracias a la nube, las organizaciones ahora pueden recopilar datos a una escala sin precedentes y utilizarlos para entrenar modelos complejos y generar información.

Si bien esta creciente demanda de datos ha abierto nuevas posibilidades, también plantea preocupaciones sobre la privacidad y la seguridad, especialmente en industrias reguladas como el gobierno, las finanzas y la atención médica. Un área donde la privacidad de los datos es crucial son los registros de los pacientes, que se utilizan para entrenar modelos que ayuden a los médicos en el diagnóstico. Otro ejemplo es la banca, donde los modelos que evalúan la solvencia de los prestatarios se construyen a partir de conjuntos de datos cada vez más ricos, como extractos bancarios, declaraciones de impuestos e incluso perfiles de redes sociales. Estos datos contienen información muy personal y, para garantizar que se mantenga en privado, los gobiernos y los organismos reguladores están implementando leyes y regulaciones de privacidad sólidas para regir el uso y el intercambio de datos para la IA, como el Reglamento General de Protección de Datos (RGPD) y la propuesta Ley de IA de la UE. Puede obtener más información sobre algunas de las industrias en las que es imperativo proteger los datos confidenciales en este Publicación de blog de Microsoft Azure.

Compromiso con una nube confidencial

Microsoft reconoce que la IA confiable requiere una nube confiable, una en la que la seguridad, la privacidad y la transparencia estén integradas en su núcleo. Un componente clave de esta visión es informática confidencial—un conjunto de capacidades de hardware y software que brindan a los propietarios de datos un control técnico y verificable sobre cómo se comparten y utilizan sus datos. La computación confidencial se basa en una nueva abstracción de hardware llamada entornos de ejecución confiables (TEEs). En TEE, los datos permanecen encriptados no solo en reposo o durante el tránsito, sino también durante el uso. Los TEE también admiten la atestación remota, lo que permite a los propietarios de los datos verificar de forma remota la configuración del hardware y el firmware que admiten un TEE y otorgar acceso a algoritmos específicos a sus datos.

En Microsoft, nos comprometemos a proporcionar una nube confidencial, donde la computación confidencial es la opción predeterminada para todos los servicios en la nube. En la actualidad, Azure ofrece una rica plataforma informática confidencial que comprende diferentes tipos de hardware informático confidencial (Intel SGX, AMD SEV-SNP), servicios básicos de informática confidencial como Atestación azul y HSM administrado por Azure Key Vault, y servicios de nivel de aplicación tales como Azure SQL siempre cifrado, Libro mayor confidencial de Azurey contenedores confidenciales en Azure. Sin embargo, estas ofertas se limitan al uso de CPU. Esto plantea un desafío para las cargas de trabajo de IA, que dependen en gran medida de los aceleradores de IA como las GPU para proporcionar el rendimiento necesario para procesar grandes cantidades de datos y entrenar modelos complejos.

El grupo de Informática Confidencial de Microsoft Research identificó este problema y definió una visión para la IA confidencial impulsada por GPU confidenciales, propuesta en dos documentos, «Aprendizaje automático multipartito olvidado en procesadores confiables» y «Graviton: entornos de ejecución confiables en GPU». En este post, compartimos esta visión. También profundizamos en la tecnología NVIDIA GPU que nos está ayudando a hacer realidad esta visión, y analizamos la colaboración entre NVIDIA, Microsoft Research y Azure que permitió que las GPU NVIDIA se convirtieran en parte de la Informática confidencial de Azure ecosistema.

Visión para GPU confidenciales

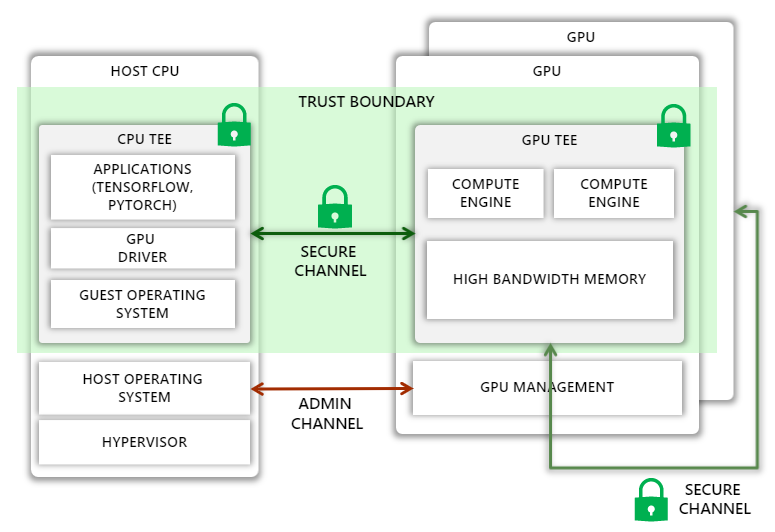

Hoy en día, las CPU de empresas como Intel y AMD permiten la creación de TEE, que pueden aislar un proceso o una máquina virtual invitada (VM) completa, eliminando efectivamente el sistema operativo host y el hipervisor del límite de confianza. Nuestra visión es extender este límite de confianza a las GPU, permitir que el código que se ejecuta en el TEE de la CPU descargue computación y datos de manera segura a las GPU.

Desafortunadamente, extender el límite de confianza no es sencillo. Por un lado, debemos protegernos contra una variedad de ataques, como los ataques man-in-the-middle en los que el atacante puede observar o alterar el tráfico en el bus PCIe o en un NVIDIA NVLink conectar múltiples GPU, así como ataques de suplantación, donde el host asigna una GPU configurada incorrectamente, una GPU que ejecuta versiones anteriores o firmware malicioso, o una sin soporte informático confidencial para la VM invitada. Al mismo tiempo, debemos asegurarnos de que el sistema operativo del host de Azure tenga suficiente control sobre la GPU para realizar tareas administrativas. Además, la protección adicional no debe generar grandes gastos generales de rendimiento, aumentar la potencia del diseño térmico ni requerir cambios significativos en la microarquitectura de la GPU.

Nuestra investigación muestra que esta visión se puede realizar ampliando la GPU con las siguientes capacidades:

- Un nuevo modo en el que todo el estado confidencial de la GPU, incluida la memoria de la GPU, está aislado del host

- Una raíz de confianza de hardware en el chip GPU que puede generar certificaciones verificables que capturan todos los estados sensibles a la seguridad de la GPU, incluido todo el firmware y el microcódigo.

- Extensiones al controlador de GPU para verificar las certificaciones de GPU, configurar un canal de comunicación seguro con la GPU y cifrar de forma transparente todas las comunicaciones entre la CPU y la GPU

- Soporte de hardware para cifrar de forma transparente todas las comunicaciones GPU-GPU a través de NVLink

- Compatibilidad en el sistema operativo invitado y el hipervisor para conectar GPU de forma segura a un TEE de CPU, incluso si el contenido del TEE de CPU está cifrado

Informática confidencial con GPU NVIDIA A100 Tensor Core

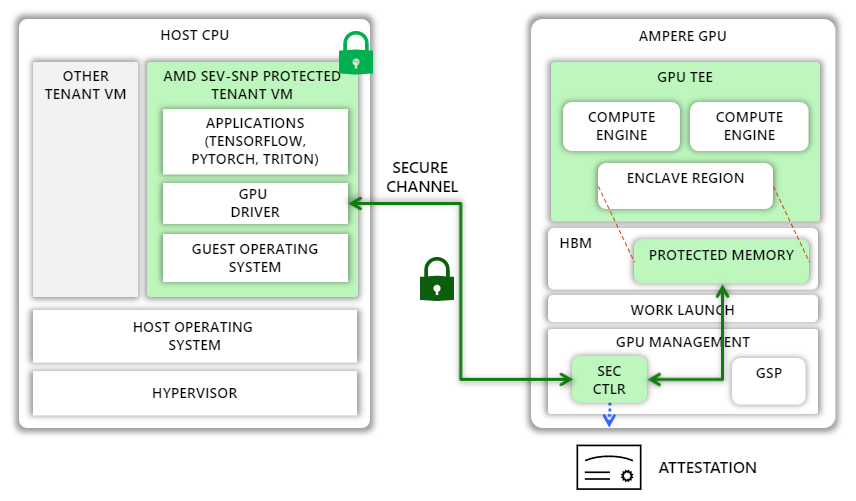

NVIDIA y Azure han dado un paso significativo hacia la realización de esta visión con una nueva función llamada Memoria protegida por amperios (APM) en las GPU NVIDIA A100 Tensor Core. En esta sección, describimos cómo APM admite la computación confidencial dentro de la GPU A100 para lograr la confidencialidad de los datos de un extremo a otro.

APM presenta un nuevo modo confidencial de ejecución en la GPU A100. Cuando la GPU se inicializa en este modo, la GPU designa una región en la memoria de alto ancho de banda (HBM) como protegida y ayuda a evitar fugas a través del acceso de E/S mapeada en memoria (MMIO) a esta región desde el host y las GPU del mismo nivel. Solo se permite el tráfico autenticado y encriptado hacia y desde la región.

En modo confidencial, la GPU se puede emparejar con cualquier entidad externa, como un TEE en la CPU anfitriona. Para habilitar este emparejamiento, la GPU incluye una raíz de confianza de hardware (HRoT). NVIDIA aprovisiona el HRoT con una identidad única y un certificado correspondiente creado durante la fabricación. El HRoT también implementa un arranque autenticado y medido al medir el firmware de la GPU, así como el de otros microcontroladores en la GPU, incluido un microcontrolador de seguridad llamado SEC2. SEC2, a su vez, puede generar informes de atestación que incluyen estas mediciones y que están firmados por una nueva clave de atestación, que está respaldada por la clave única del dispositivo. Estos informes pueden ser utilizados por cualquier entidad externa para verificar que la GPU esté en modo confidencial y esté ejecutando el último firmware bueno conocido.

Cuando se carga el controlador NVIDIA GPU en la CPU TEE, verifica si la GPU está en modo confidencial. Si es así, el controlador solicita un informe de certificación y verifica que la GPU sea una GPU NVIDIA genuina que ejecute un firmware bueno conocido. Una vez confirmado, el controlador establece un canal seguro con el microcontrolador SEC2 en la GPU mediante el protocolo de intercambio de claves basado en Diffie-Hellman respaldado por el modelo de datos y el protocolo de seguridad (SPDM) para establecer una nueva clave de sesión. Cuando se completa ese intercambio, tanto el controlador de GPU como SEC2 tienen la misma clave de sesión simétrica.

El controlador de GPU usa la clave de sesión compartida para cifrar todas las transferencias de datos posteriores hacia y desde la GPU. Debido a que las páginas asignadas a la CPU TEE están encriptadas en la memoria y no pueden ser leídas por los motores GPU DMA, el controlador GPU asigna páginas fuera de la CPU TEE y escribe datos encriptados en esas páginas. Del lado de la GPU, el microcontrolador SEC2 es responsable de descifrar los datos cifrados transferidos desde la CPU y copiarlos en la región protegida. Una vez que los datos están en la memoria de alto ancho de banda (HBM) en texto no cifrado, los núcleos de la GPU pueden usarlos libremente para el cálculo.

Acelerar la innovación con IA confidencial

La implementación de APM es un hito importante para lograr una adopción más amplia de la IA confidencial en la nube y más allá. APM es el bloque de construcción fundamental de Máquinas virtuales de GPU confidenciales de AzureAhora en vista previa privada. Estas máquinas virtuales, diseñadas en colaboración con NVIDIA, Azure y Microsoft Research, cuentan con hasta cuatro GPU A100 con 80 GB de tecnología HBM y APM y permiten a los usuarios alojar cargas de trabajo de IA en Azure con un nuevo nivel de seguridad.

Pero esto es solo el principio. Esperamos llevar nuestra colaboración con NVIDIA al siguiente nivel con la arquitectura Hopper de NVIDIA, que permitirá a los clientes proteger tanto la confidencialidad como la integridad de los datos y los modelos de IA en uso. Creemos que las GPU confidenciales pueden habilitar una plataforma de IA confidencial en la que varias organizaciones pueden colaborar para entrenar e implementar modelos de IA al agrupar conjuntos de datos confidenciales mientras mantienen el control total de sus datos y modelos. Una plataforma de este tipo puede desbloquear el valor de grandes cantidades de datos al tiempo que preserva la privacidad de los datos, lo que brinda a las organizaciones la oportunidad de impulsar la innovación.

Un ejemplo del mundo real implica Investigación de Boschla división de investigación e ingeniería avanzada de el bosco, que está desarrollando un proyecto de IA para entrenar modelos de conducción autónoma. Gran parte de los datos que utiliza incluyen información de identificación personal (PII), como números de placas y rostros de personas. Al mismo tiempo, debe cumplir con GDPR, que requiere una base legal para procesar PII, a saber, el consentimiento de los interesados o el interés legítimo. Lo primero es un desafío porque es prácticamente imposible obtener el consentimiento de los peatones y conductores registrados por los autos de prueba. Confiar en el interés legítimo también es un desafío porque, entre otras cosas, requiere demostrar que existe una forma no menos intrusiva de privacidad de lograr el mismo resultado. Aquí es donde brilla la IA confidencial: el uso de la informática confidencial puede ayudar a reducir los riesgos para los interesados y los controladores de datos al limitar la exposición de los datos (por ejemplo, a algoritmos específicos), al tiempo que permite a las organizaciones entrenar modelos más precisos.

En Microsoft Research, estamos comprometidos a trabajar con el ecosistema de computación confidencial, incluidos colaboradores como NVIDIA y Bosch Research, para fortalecer aún más la seguridad, permitir el entrenamiento y la implementación sin problemas de modelos confidenciales de IA y ayudar a impulsar la próxima generación de tecnología.

Acerca de la computación confidencial en Microsoft Research

El equipo de Confidential Computing de Microsoft Research Cambridge lleva a cabo una investigación pionera en el diseño de sistemas que tiene como objetivo garantizar sólidas propiedades de seguridad y privacidad a los usuarios de la nube. Abordamos los problemas relacionados con el diseño de hardware seguro, los protocolos criptográficos y de seguridad, la resiliencia del canal lateral y la seguridad de la memoria. También estamos interesados en las nuevas tecnologías y aplicaciones que pueden descubrir la seguridad y la privacidad, como las cadenas de bloques y el aprendizaje automático multipartito. Visite nuestra página de carreras para obtener información sobre oportunidades tanto para investigadores como para ingenieros. Estamos contratando.