Google hoy anunció varias actualizaciones a sus aplicaciones de búsqueda, traducción y mapas que utilizan inteligencia artificial (AI) y realidad aumentada (AR) para proporcionar respuestas ampliadas y funciones de búsqueda en vivo que pueden identificar instantáneamente objetos y ubicaciones alrededor de un usuario.

En un evento en París, la compañía demostró las actualizaciones de su tecnología Google Maps Immersive View y Live View, junto con nuevas funciones para conductores de vehículos eléctricos (EV) y personas que caminan, andan en bicicleta o viajan en transporte público que muestran rutas 3D en tiempo real. . Vista en vivo, anunciado en 2020permite a los usuarios obtener direcciones ubicadas en el mundo real y en un minimapa en la parte inferior de la pantalla del móvil.

Vista inmersiva de Google, vista previa por primera vez el año pasado, ahora está en vivo en cinco ciudades. Una actualización de la función de navegación de Google Maps, Immersive View utiliza AI y AR para combinar miles de millones de vistas de la calle e imágenes aéreas para crear un modelo digital del mundo real que se puede usar para guiar a los usuarios en una ruta. Esa función ya está disponible en Londres, Los Ángeles, San Francisco, Nueva York y Tokio.

Search with Live View y Immersive View están diseñados para ayudar a un usuario a encontrar cosas cercanas, como cajeros automáticos, restaurantes, parques y estaciones de tránsito, simplemente levantando un teléfono mientras está en la calle. Las funciones también ofrecen información útil, como cuándo un negocio está abierto, cuándo está ocupado en ese momento y qué tan alto está clasificado.

Google

GoogleUn ejemplo de búsqueda de Google con Live View.

La función Live View también permite vistas aéreas. Entonces, por ejemplo, los usuarios que visiten el Rijksmuseum en Amsterdam podrían usarlo para volar virtualmente sobre el edificio y ver las ubicaciones de entrada. Y un «control deslizante de tiempo» muestra un área en diferentes momentos del día y con pronósticos meteorológicos.

“También puede detectar dónde tiende a estar más concurrido para que pueda tener toda la información que necesita para decidir dónde y cuándo ir”, dijo Google. “Si tiene hambre, deslícese hasta el nivel de la calle para explorar los restaurantes cercanos. — e incluso eche un vistazo al interior para comprender rápidamente el ambiente de un lugar antes de hacer su reservación».

Google dijo que la tecnología AR utilizada para crear los mapas 3D superpuestos puede ser especialmente útil cuando se navega por lugares complicados, como un aeropuerto desconocido. En 2021, la empresa presentó Live View en interiores para ubicaciones seleccionadas en los EE. UU., Zúrich y Tokio solo para ese propósito. Utiliza flechas generadas por AR para señalar al usuario ubicaciones como baños, salones, paradas de taxis y alquiler de automóviles.

En los próximos meses, Google planea expandir Live View en interiores a más de 1,000 nuevos aeropuertos, estaciones de tren y centros comerciales en Barcelona, Berlín, Frankfurt, Londres, Madrid, Melbourne, París, Praga, São Paulo, Singapur, Sydney y Taipéi.

Para crear escenas realistas en Live View, Google utiliza campos de radiación neuronal (NeRF), una tecnología de IA avanzada que transforma fotos en representaciones 3D.

“Con NeRF, podemos recrear con precisión el contexto completo de un lugar, incluida su iluminación, la textura de los materiales y lo que hay en el fondo. Todo esto te permite ver si la iluminación cambiante de un bar es el ambiente adecuado para una cita nocturna o si las vistas en un café lo convierten en el lugar ideal para almorzar con amigos”, dijo Google.

La vista inmersiva con la tecnología Live View de Google también permite que un usuario use la cámara de su dispositivo móvil para experimentar un vecindario, punto de referencia, restaurante o lugar popular antes de entrar. Entonces, por ejemplo, apuntarlo a una tienda le permite a una persona «entrar» en la tienda y caminar sin siquiera entrar. La función también identifica puntos de referencia, no solo en tiempo real, sino también en videos guardados.

Google

GoogleLive View de Google permite que la cámara del dispositivo móvil de un usuario descubra información sobre puntos de referencia, como edificios, no solo en video en tiempo real sino también en clips guardados.

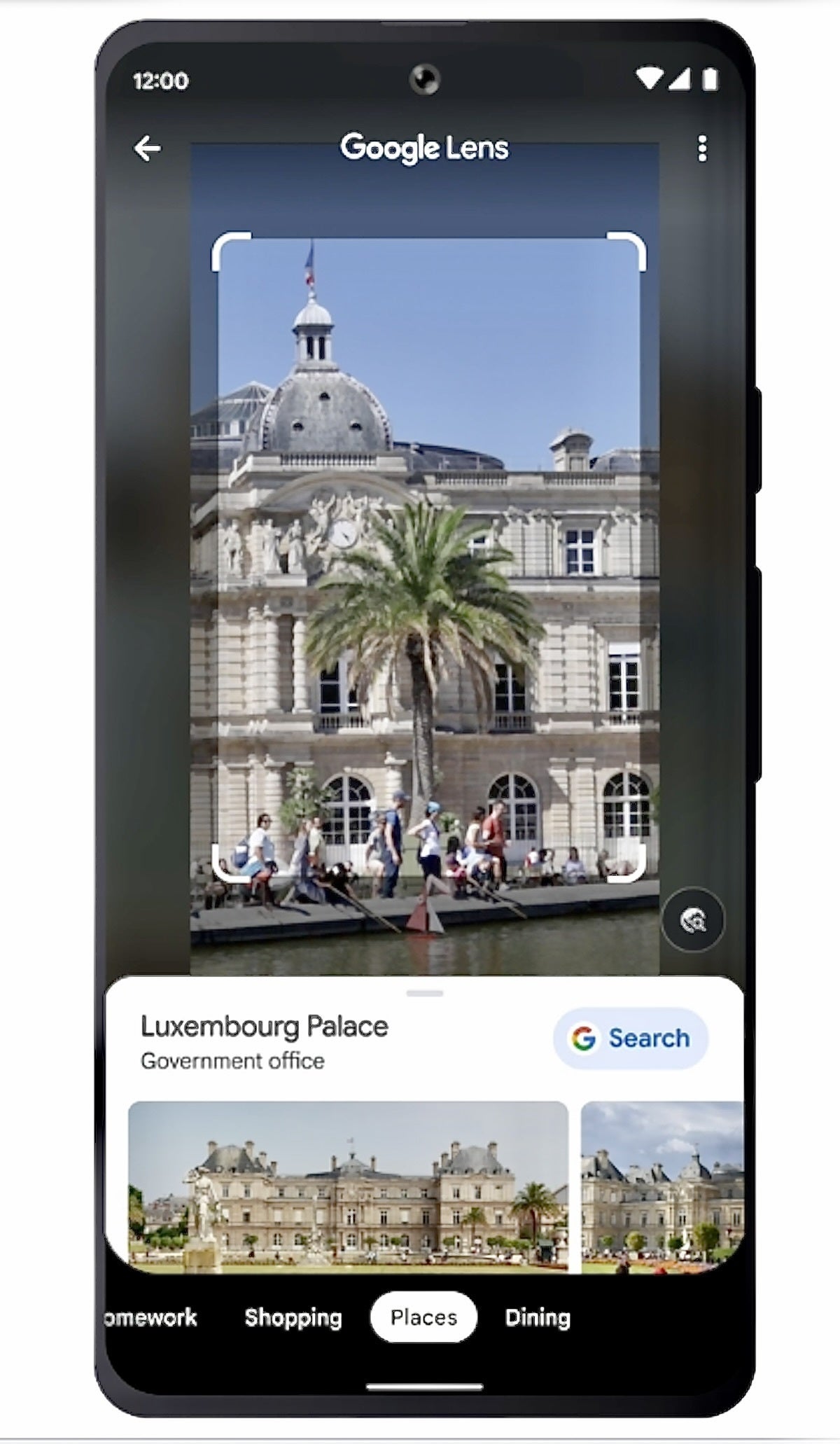

El año pasado Google lanzó una función llamada búsqueda múltiple en los EE.UU. Permite realizar búsquedas utilizando texto e imágenes al mismo tiempo.

Google

GoogleGoogle lanzó la búsqueda múltiple en los EE. UU. en 2022 y dijo que ahora está disponible en todo el mundo.

Hoy, Google anunció que Multisearch está disponible globalmente en dispositivos móviles, en todos los idiomas y países donde Google Lens está disponible. También anunció “búsqueda múltiple cerca de mí”, que permite a los usuarios tomar una foto o una captura de pantalla de un objeto, como un sofá o un horno, y luego encontrar la mercancía cerca. La compañía planea lanzar «multisearch cerca de mí» durante los próximos meses en todos los idiomas y países donde Lens está disponible.

Las actualizaciones de la aplicación de Google se programaron para competir con los anuncios de Microsoft el martes sobre las mejoras en su motor de búsqueda Bing. Microsoft, a través de su asociación con OpenAI, lanzó actualizaciones tanto para Bing como para el navegador Edge, lo que permite a los usuarios chatear o enviar mensajes de texto con el motor de búsqueda y recibir respuestas tipo ensayo similares a las que produce ChatGPT.

«Si bien Google habló sobre la promesa de la IA y mostró partes de ella (no necesariamente en la búsqueda principal), y las capacidades están en ‘vista previa limitada’, Microsoft anunció y mostró una integración más profunda de las funciones de IA en la búsqueda de Bing y Edge. nos hizo jugar con él y habló en detalle sobre los pasos de IA responsable que han tomado hasta ahora y planean tomar de manera continua», dijo Ritu Jyoti, vicepresidente de Automatización e Inteligencia Artificial Mundial del grupo IDC. Investigación.

“El evento de Microsoft que anunció el nuevo navegador Bing on the Edge fue sobre una cosa: obtener más usuarios de búsqueda”, dijo Jason Wong, un distinguido vicepresidente y analista de diseño y desarrollo de software de Gartner Research. «La presentación para inversores de Microsoft que siguió indicó que un aumento del 1% en la búsqueda podría generar $2 mil millones en ingresos para su negocio de publicidad».

Lo que Google anunció hoy fue mostrar que una mera interfaz de chatbot en la parte superior de un motor de búsqueda será lo que está en juego, dijo Wong.

“La búsqueda es más que escribir frases o preguntas en un navegador. La necesidad de respuestas e información contextuales en tiempo real abarca nuestras actividades diarias. Apenas estamos comenzando a reimaginar los últimos 25 años de la web a través de la IA generativa”, dijo Wong.

Google también anunció actualizaciones a su aplicación Translate, brindando a los usuarios más contexto. Por ejemplo, si un usuario preguntara cuáles son las mejores constelaciones para observar las estrellas, después de recibir una lista, el usuario podría preguntar sobre la mejor época del año para verlas.

Google Translate también brinda la opción de ver múltiples significados para las preguntas y ayudar al usuario a encontrar la mejor traducción. La actualización comenzará a implementarse en inglés, francés, alemán, japonés y español en las próximas semanas.

“La búsqueda nunca será un problema resuelto. La búsqueda es nuestro mayor logro”, dijo Prabhakar Raghavan, vicepresidente sénior de Google a cargo de la búsqueda, el asistente y la ubicación geográfica.

Google

GooglePrabhakar Raghavan, vicepresidente sénior a cargo de búsqueda, asistente y geolocalización de Google, hablando en el evento de la empresa en París.

Anunciado en 2016, Google Translate utiliza una tecnología patentada llamada Traducción automática neuronal de Google (GNMT) y Zero-Shot Translation para proporcionar conversión palabra por palabra entre pares de idiomas nunca vistos explícitamente por el sistema de IA. Entonces, si alguien dice una oración en inglés, la aplicación puede transponerla a cualquiera de los 133 idiomas.

Google también anunció una asociación y una participación estratégica en un competidor de OpenAIy lanzó su propio chatbot llamado Bard. Bard es un servicio experimental de inteligencia artificial conversacional que, según Google, funciona con una tecnología llamada Language Model for Dialogue Applications (o LaMDA para abreviar).

Google abrió Bard a los probadores beta esta semana antes de que pronto esté más disponible.

Wong dijo que Google fue tomado por sorpresa por el éxito de ChatGPT, que llegó a un millón de usuarios en solo cinco días.

“Es probable que muchas personas comparen las respuestas de ChatGPT de Bing con las respuestas de Google Bard solo para ver cuáles son las diferencias. Sin una presencia móvil para esta nueva interfaz de chatbot de Bing, probablemente será difícil para Microsoft hacer incursiones serias en el negocio de búsqueda de consumidores”, dijo Wong.

Derechos de autor © 2023 IDG Communications, Inc.