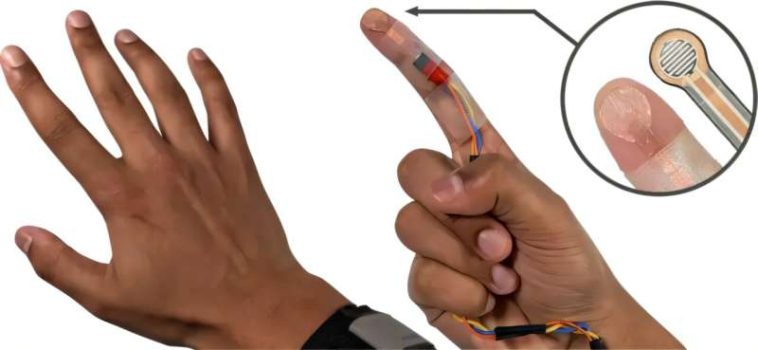

Los investigadores utilizaron un sensor táctil personalizado que recorría la parte inferior del dedo índice y la palma para recopilar datos sobre diferentes tipos de tacto con diferentes fuerzas mientras permanecían invisibles para la cámara. Crédito: Universidad Carnegie Mellon

Un artículo publicado en Actas del 37º Simposio anual de ACM sobre software y tecnología de interfaz de usuariorealizado por investigadores del Instituto de Interacción Humano-Computadora de la Universidad Carnegie Mellon, presenta egotoqueuna herramienta que utiliza inteligencia artificial para controlar interfaces AR/VR tocando la piel con un dedo.

En última instancia, el equipo quería diseñar un control que proporcionara retroalimentación táctil utilizando solo los sensores que vienen con un casco AR/VR estándar.

OmniTouch, un método previo desarrollado por Chris Harrison, profesor asociado en el HCII y director del Future Interfaces Group, se acercó. Pero ese método requería una cámara especial y tosca con sensor de profundidad. Vimal Mollyn, Ph.D. Un estudiante asesorado por Harrison tuvo la idea de utilizar un algoritmo de aprendizaje automático para entrenar cámaras normales para que reconocieran el contacto.

«Intente tomar su dedo y vea qué sucede cuando toca su piel con él. Notará que existen estas sombras y deformaciones locales de la piel que solo ocurren cuando toca la piel», dijo Mollyn. «Si podemos verlos, entonces podemos entrenar un modelo de aprendizaje automático para que haga lo mismo, y eso es esencialmente lo que hicimos».

Mollyn recopiló los datos para EgoTouch mediante el uso de un sensor táctil personalizado que recorría la parte inferior del dedo índice y la palma. El sensor recopiló datos sobre diferentes tipos de contacto con diferentes fuerzas mientras permanecía invisible para la cámara. Luego, el modelo aprendió a correlacionar las características visuales de las sombras y las deformidades de la piel con el tacto y la fuerza sin anotaciones humanas.

El equipo amplió su recopilación de datos de entrenamiento para incluir a 15 usuarios con diferentes tonos de piel y densidades de cabello y recopiló horas de datos en muchas situaciones, actividades y condiciones de iluminación.

EgoTouch puede detectar el tacto con más del 96% de precisión y tiene una tasa de falsos positivos de alrededor del 5%. Reconoce presionar hacia abajo, levantar y arrastrar. El modelo también puede clasificar si un toque fue ligero o fuerte con un 98% de precisión.

«Eso puede ser realmente útil para tener una función de clic derecho en la piel», dijo Mollyn.

Detectar variaciones en el tacto podría permitir a los desarrolladores imitar los gestos de la pantalla táctil en la piel. Por ejemplo, un teléfono inteligente puede reconocer desplazarse hacia arriba o hacia abajo en una página, hacer zoom, deslizarse hacia la derecha o mantener presionado un ícono. Para traducir esto a una interfaz basada en la piel, la cámara necesita reconocer las diferencias sutiles entre el tipo de toque y la fuerza del tacto.

Las precisiones fueron aproximadamente las mismas en diversos tonos de piel y densidades de cabello, y en diferentes áreas de la mano y el antebrazo, como la parte delantera y trasera del brazo, la palma y el dorso de la mano. El sistema no funcionó bien en zonas óseas como los nudillos.

«Probablemente se deba a que no había tanta deformación de la piel en esas áreas», dijo Mollyn. «Como diseñador de interfaz de usuario, lo que puedes hacer es evitar colocar elementos en esas regiones».

Mollyn está explorando formas de utilizar cámaras de visión nocturna e iluminación nocturna para permitir que el sistema EgoTouch funcione en la oscuridad. También está colaborando con investigadores para extender este método de detección táctil a superficies distintas a la piel.

«Por primera vez, tenemos un sistema que simplemente utiliza una cámara que ya está en todos los auriculares. Nuestros modelos no requieren calibración y funcionan desde el primer momento», afirmó Mollyn. «Ahora podemos aprovechar el trabajo previo sobre interfaces en la piel y hacerlos reales».

Más información:

Vimal Mollyn et al, EgoTouch: entrada táctil en el cuerpo mediante cámaras con auriculares AR/VR, Actas del 37º Simposio anual de ACM sobre software y tecnología de interfaz de usuario (2024). DOI: 10.1145/3654777.3676455

Citación: La herramienta basada en IA crea interfaces simples para la realidad virtual y aumentada (2024, 13 de noviembre) recuperado el 13 de noviembre de 2024 de https://techxplore.com/news/2024-11-ai-based-tool-simple-interfaces.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.

GIPHY App Key not set. Please check settings