Crédito: Diemert y Weber.

Los sistemas robóticos están configurados para ser introducidos en una amplia gama de entornos del mundo real, desde carreteras hasta centros comerciales, oficinas, aeropuertos e instalaciones de atención médica. Sin embargo, para desempeñarse bien de manera constante en estos entornos, los robots deben ser capaces de hacer frente a la incertidumbre, adaptándose a los cambios inesperados en su entorno circundante y garantizando la seguridad de los humanos cercanos.

Los sistemas robóticos que pueden adaptarse de forma autónoma a la incertidumbre en situaciones en las que los humanos podrían estar en peligro se denominan sistemas «autoadaptativos críticos para la seguridad». Si bien muchos especialistas en robótica han estado tratando de desarrollar estos sistemas y mejorar su rendimiento, todavía falta un marco teórico claro y general que los defina.

Investigadores de la Universidad de Victoria en Canadá han llevado a cabo recientemente un estudio destinado a delinear claramente la noción de «sistema autoadaptativo crítico para la seguridad». Su artículo, publicado previamente en arXiv, proporciona un marco valioso que podría usarse para clasificar estos sistemas y diferenciarlos de otras soluciones robóticas.

«Los sistemas autoadaptativos se han estudiado ampliamente», escribieron Simon Diemert y Jens Weber en su artículo. “Este trabajo propone una definición de sistema autoadaptativo crítico para la seguridad y luego describe una taxonomía para clasificar las adaptaciones en diferentes tipos según su impacto en la seguridad del sistema y el caso de seguridad del sistema».

El objetivo clave del trabajo de Diemert y Weber fue formalizar la idea de «sistemas autoadaptativos críticos para la seguridad», para que los especialistas en robótica puedan comprenderla mejor. Para hacer esto, los investigadores primero propusieron algunas definiciones claras para dos términos, a saber, «sistema autoadaptativo crítico para la seguridad» y «adaptación segura».

Según su definición, para ser un sistema autoadaptativo crítico para la seguridad, un robot debe cumplir con tres criterios clave. En primer lugar, debe satisfacer el principio externo de adaptación de Weyns, lo que básicamente significa que debe ser capaz de manejar de forma autónoma los cambios y la incertidumbre en su entorno, así como el propio sistema y sus objetivos.

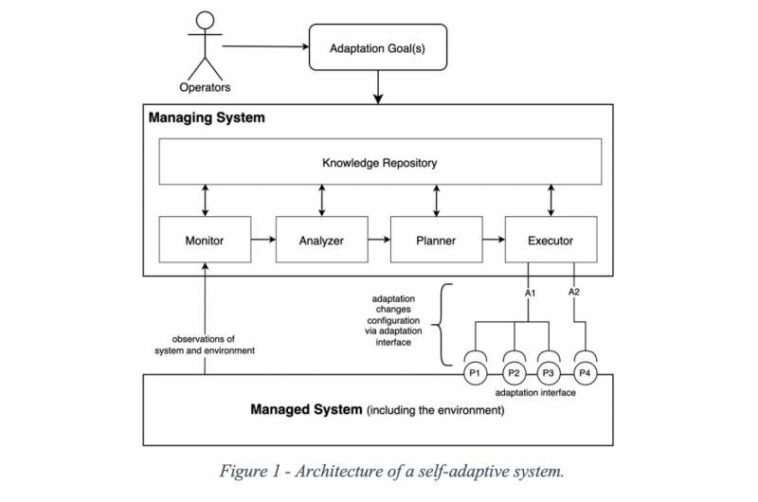

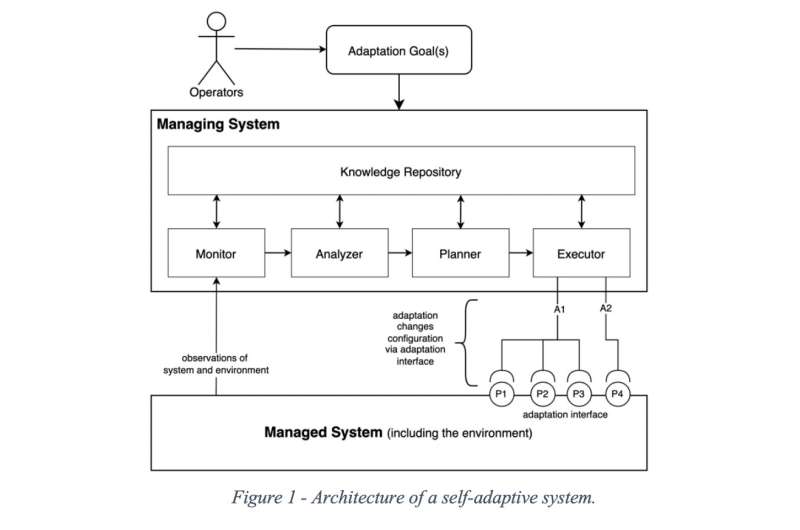

Para ser crítico para la seguridad y autoadaptativo, el sistema también debe satisfacer el principio interno de adaptación de Weyns, que sugiere que debe evolucionar internamente y ajustar su comportamiento de acuerdo con los cambios que experimenta. Para ello, debe estar compuesto por un sistema gestionado y un sistema de gestión.

En este marco, el sistema gestionado realiza funciones primarias del sistema, mientras que el sistema de gestión adapta el sistema gestionado con el tiempo. Finalmente, el sistema administrado debe ser capaz de abordar de manera efectiva las funciones críticas para la seguridad (es decir, completar acciones que, si se realizan de manera deficiente, podrían provocar incidentes y eventos adversos).

La definición de los investigadores de «adaptación segura», por otro lado, se basa en dos ideas clave. Estos son que el componente gestionado de un sistema robótico es responsable de cualquier accidente en el medio ambiente, mientras que el componente de gestión es responsable de cualquier cambio en la configuración del sistema gestionado. Con base en estas dos nociones, Diemert y Weber definen la «adaptación segura» de la siguiente manera:

«Una opción de adaptación segura es una opción de adaptación que, cuando se aplica al sistema administrado, no da como resultado ni contribuye a que el sistema administrado alcance un estado peligroso», escribieron los investigadores en su artículo. «Una acción de adaptación segura es una acción de adaptación que, mientras se ejecuta, no da como resultado ni contribuye a la ocurrencia de un peligro. De ello se deduce que una adaptación segura es aquella en la que todas las opciones de adaptación y las acciones de adaptación son seguras».

Para delinear mejor el significado de «adaptación segura» y lo que la distingue de cualquier otra forma de «adaptación», Diemert y Weber también idearon una nueva taxonomía que podría usarse para clasificar diferentes adaptaciones realizadas por sistemas autoadaptativos. Esta taxonomía se centra específicamente en la seguridad o los peligros asociados con diferentes adaptaciones.

«La taxonomía expresa los criterios de clasificación y luego describe los criterios específicos que debe satisfacer el caso de seguridad de un sistema autoadaptativo, según el tipo de adaptaciones realizadas», escribieron Diemert y Weber en su artículo. «Cada tipo en la taxonomía se ilustra utilizando el ejemplo de un sistema de calentamiento de agua autoadaptativo crítico para la seguridad».

La taxonomía delineada por Diemert y Weber clasifica las adaptaciones realizadas por sistemas computacionales o robóticos autoadaptativos en cuatro amplias categorías, denominadas tipo 0 (sin inferencia), tipo I (seguridad estática), tipo II (seguridad restringida) y tipo III (seguro dinámico). Cada una de estas categorías de adaptación está asociada con reglas y características específicas.

El trabajo reciente de este equipo de investigadores podría guiar futuros estudios centrados en el desarrollo de sistemas autoadaptativos diseñados para operar en condiciones críticas de seguridad. En última instancia, podría usarse para obtener una mejor comprensión del potencial de estos sistemas para diferentes implementaciones en el mundo real.

«El siguiente paso de esta línea de investigación es validar la taxonomía propuesta, para demostrar que es capaz de clasificar todo tipo de sistemas autoadaptativos críticos para la seguridad y que las obligaciones impuestas por la taxonomía son apropiadas utilizando una combinación de literatura sistemática revisiones y estudios de casos», concluyen Diemert y Weber en su artículo.

Simon Diemert, Jens H. Weber, Adaptación crítica para la seguridad en sistemas autoadaptativos. arXiv:2210.00095v1 [cs.SE], arxiv.org/abs/2210.00095

© 2022 Ciencia X Red

Citación: Una definición clara y taxonomía de clasificación para sistemas robóticos autoadaptativos críticos para la seguridad (21 de octubre de 2022) consultado el 21 de octubre de 2022 en https://techxplore.com/news/2022-10-definition-classification-taxonomy-safety-critical -autoadaptable.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.