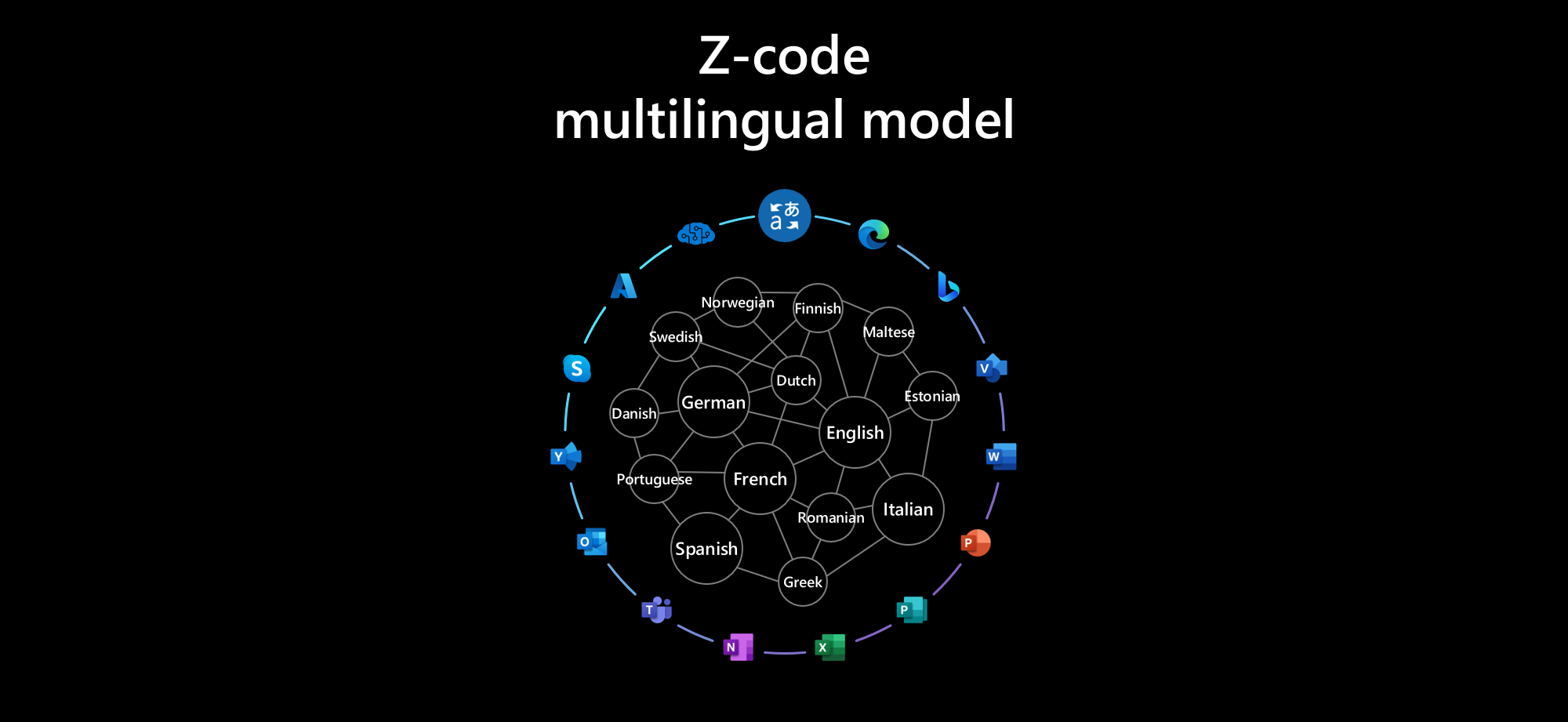

Microsoft busca IA a escala con gran ambición para permitir la próxima generación de experiencias de IA. El equipo de Microsoft Translator ZCode está trabajando junto con Microsoft Project Turing y Microsoft Research Asia para promover el soporte lingüístico y multilingüe en el núcleo de esta iniciativa. Seguimos ampliando las fronteras con los modelos multilingües para admitir varios escenarios de idiomas en Microsoft. El verano pasado, anunciamos nuestro modelo de mezcla multilingüe de expertos a gran escala con DeepSpeed que pueden superar a los modelos bilingües individuales a gran escala. Recientemente, el último modelo de representación del lenguaje universal de Turing (T-ULRv5), un modelo creado por Microsoft, está una vez más a la vanguardia y en la cima de Google. Tabla de clasificación pública XTREME En ese tiempo. Más recientemente, Microsoft anunció el modelo de parámetros más grande de Megatron-Turing NLG 530B.

La Conferencia anual sobre traducción automática (también conocida como WMT 2021) concluyó la semana pasada en la hermosa Punta Cana, República Dominicana. WMT reúne a investigadores de todo el campo de la traducción automática, tanto de la industria como del mundo académico, para participar en una serie de tareas compartidas, cada una de las cuales define un punto de referencia en un área importante de la traducción automática para impulsar el campo hacia nuevas fronteras.

El equipo de Microsoft Translator ZCode, en colaboración con el equipo de Turing y Microsoft Research Asia, compitió en la sección «Traducción multilingüe a gran escala», que consistía en una tarea completa de traducción entre las 10.000 direcciones en 101 idiomas y dos pequeñas tareas: una se centró en cinco idiomas de Europa central y meridional, y uno en cinco idiomas del sudeste asiático. El modelo Microsoft ZCode-DeltaLM ganó las tres tareas por enormes márgenes, incluida una increíble ganancia de más de 10 puntos sobre el modelo M2M100 en la gran tarea evaluada en una enorme cantidad de 10,000 pares de idiomas. (Resultados de la tarea compartida WMT 2021 sobre traducción automática multilingüe a gran escala, Wenzek y col., WMT 2021).

Figura 1: Resultados oficiales (puntajes BLEU) en la tarea completa y la tarea pequeña1 en la tarea compartida de traducción multilingüe a gran escala de WMT 2021

El enfoque ZCode-DeltaLM

En esta publicación de blog, echemos un vistazo bajo el capó al modelo ganador de Microsoft ZCode-DeltaLM. Nuestro punto de partida fue DeltaLM (DeltaLM: formación previa de codificador-decodificador para la generación y traducción de idiomas mediante el aumento de codificadores multilingües previamente entrenados), el último de la cada vez más poderosa serie de modelos lingüísticos preentrenados masivamente multilingües de Microsoft.

DeltaLM es un modelo de codificador-decodificador, pero en lugar de entrenar desde cero, se inicializa a partir de un modelo de codificador de última generación previamente entrenado, específicamente (TULRv3). Si bien la inicialización del codificador es sencilla, el decodificador no lo es tanto, ya que agrega atención cruzada a la atención propia del codificador. DeltaLM resuelve este problema con una novedosa arquitectura intercalada, donde la auto-atención y la atención cruzada se alternan entre capas, con la auto-atención usada en las capas impares y la atención cruzada usada en las capas pares. Con este entrelazado, la estructura del decodificador coincide con el codificador, por lo que también se puede inicializar de la misma manera desde TULRv3.

DeltaLM se ve reforzado por el potente aprendizaje multitarea de ZCode: Aprendizaje multitarea para traducción automática neuronal multilingüe. Nuestros modelos muestran que la combinación del aprendizaje multitarea y multilingüe puede mejorar significativamente la formación para modelos lingüísticos preentrenados a gran escala. Este paradigma de aprendizaje multilingüe multitarea está aprovechando el sesgo inductivo y la regularización de varias tareas e idiomas simultáneamente para desempeñarse mejor en varias tareas posteriores. Estamos utilizando la tarea de traducción, la tarea de eliminación de ruido del codificador automático y la tarea de corrupción del intervalo de traducción como se muestra en la siguiente figura.

Ganar la pista de traducción masivamente multilingüe

Para construir nuestro sistema ganador de traducción masiva multilingüe (Sistemas de traducción automática multilingües de Microsoft para tareas compartidas WMT21), comenzamos con zCode-DeltaLM y agregamos algunos trucos.

Aplicamos el aprendizaje progresivo, primero entrenamos un modelo con 24 capas de codificador y 12 capas de decodificador, luego continuamos entrenando con 12 capas de codificador añadidas, lo que da como resultado un codificador de 36 capas de profundidad. Para cubrir todos los pares de idiomas, generamos datos pseudo-paralelos duales donde ambos lados de los datos paralelos son sintéticos, traducidos por el modelo del inglés. También aplicamos la retrotraducción iterativa para generar datos sintéticos. Aplicamos el aprendizaje del plan de estudios, comenzando con todos los datos de entrenamiento ruidosos y luego reduciéndolos a un subconjunto limpio. Volvemos a ponderar el objetivo de traducción para favorecer los datos paralelos sobre la retrotraducción y los datos pseudo-paralelos duales. Aplicamos muestreo de temperatura para equilibrar los pares de idiomas. Para cada par de idiomas, elegimos, según el conjunto de desarrollo, si preferir la traducción directa o la traducción dinámica a través del inglés.

Poniéndolo todo junto, sabíamos que teníamos un sistema increíblemente multilingüe masivo, pero los resultados oficiales en el conjunto de pruebas ciegas superaron nuestras expectativas. Obtuvimos una puntuación de 2,5 a 9 BLEU por delante del siguiente competidor y de 10 a 21 puntos BLEU por delante del modelo M2M-175 de referencia. En la prueba de desarrollo, comparamos con el modelo M2M-615 más grande, que también superamos por 10 a 18 puntos.

Más allá de la traducción: generación universal de idiomas

Si bien estamos entusiasmados con la gran victoria en WMT 2021, lo que es aún más emocionante es que, a diferencia de los otros competidores, nuestro modelo ZCode-DeltaLM no es solo un modelo de traducción, sino un modelo general de lenguaje codificador-decodificador previamente entrenado, utilizable para todo tipo de tareas de generación más allá de la traducción. Esto realmente permite que nuestros modelos funcionen bastante bien en varias tareas de generación de lenguaje natural multilingües.

Alcanzamos un nuevo SOTA en muchas tareas de generación populares de Benchmark de GEM, incluyendo Wikilingua (resumen), simplificación de texto (WikiAuto) y estructura a texto (WebNLG). El modelo DeltaLM-ZCode supera ampliamente a modelos mucho más grandes, como mT5 XL (3.7B), que también se entrena con datos mucho más grandes. Esto demostró la eficiencia y versatilidad de los modelos que conducen a un desempeño sólido en muchas tareas.

Figura 2. Rendimiento (puntuaciones RL) de ZCode-DeltaLM en las tareas de resumen y simplificación de texto en el punto de referencia GEM

Mirando hacia el futuro

La traducción automática multilingüe ha llegado a un punto en el que funciona muy bien, superando los sistemas bilingües, tanto en idiomas de bajos como de altos recursos. Se ha demostrado que los modelos de mezcla de expertos (MoE) se ajustan muy bien a la escala de tales modelos, como se ha demostrado en GShard. Exploramos cómo escalar de manera eficiente dichos modelos con Mixture of Experts: Entrenamiento MoE escalable y eficiente para modelos multilingües multitarea. Los modelos de MoE con datos multilingües masivos y capacitación multitarea sin supervisión presentan una oportunidad sin precedentes para que dichos modelos proporcionen sistemas verdaderamente universales que puedan permitir que el equipo de Microsoft Translator elimine las barreras del idioma en todo el mundo, además de admitir una variedad de tareas de generación de lenguaje natural.

Agradecimientos

Nos gustaría reconocer y agradecer a Francisco Guzman y su equipo que recopilaron el conjunto de pruebas FLORES masivamente multilingües y organizaron esta pista de WMT con una evaluación a tan gran escala.