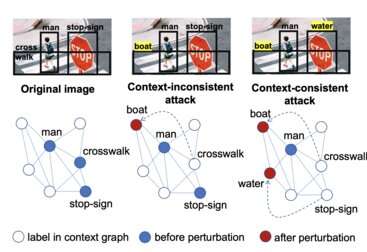

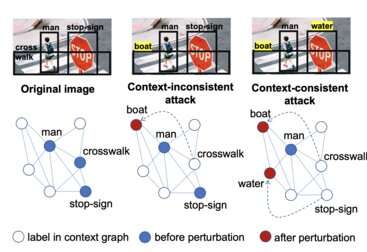

Ilustración que muestra cómo un atacante podría hacer que un sistema de visión artificial clasifique erróneamente los objetos que ve a través de la cámara. Etiquetar incorrectamente un objeto puede no ser suficiente para tomar una mala decisión, pero etiquetar incorrectamente varios objetos relacionados sí lo hará. Crédito: Cai et.al. 2022

Los avances en la visión por computadora y el aprendizaje automático han hecho posible que una amplia gama de tecnologías realicen tareas sofisticadas con poca o ninguna supervisión humana. Desde drones autónomos y automóviles autónomos hasta imágenes médicas y fabricación de productos, muchas aplicaciones informáticas y robots utilizan información visual para tomar decisiones críticas. Las ciudades confían cada vez más en estas tecnologías automatizadas para la seguridad pública y el mantenimiento de la infraestructura.

Sin embargo, en comparación con los humanos, las computadoras ven con una especie de visión de túnel que las hace vulnerables a ataques con resultados potencialmente catastróficos. Por ejemplo, un conductor humano, al ver un grafiti que cubre una señal de alto, aún lo reconocerá y detendrá el automóvil en una intersección. El grafiti podría hacer que un automóvil autónomo, por otro lado, pierda la señal de alto y se abra paso a través de la intersección. Y, mientras que la mente humana puede filtrar todo tipo de información visual extraña o extraña al tomar una decisión, las computadoras se obsesionan con las pequeñas desviaciones de los datos esperados.

Esto se debe a que el cerebro es infinitamente complejo y puede procesar multitud de datos y experiencias pasadas simultáneamente para llegar a decisiones casi instantáneas apropiadas para la situación. Las computadoras se basan en algoritmos matemáticos entrenados en conjuntos de datos. Su creatividad y cognición están restringidas por los límites de la tecnología, las matemáticas y la previsión humana.

Los actores maliciosos pueden explotar esta vulnerabilidad cambiando la forma en que una computadora ve un objeto, ya sea alterando el objeto mismo o algún aspecto del software involucrado en la tecnología de visión. Otros ataques pueden manipular las decisiones que toma la computadora sobre lo que ve. Cualquiera de los dos enfoques podría significar una calamidad para las personas, las ciudades o las empresas.

Un equipo de investigadores de la Facultad de Ingeniería Bourns de UC Riverside está trabajando en formas de frustrar los ataques a los sistemas de visión por computadora. Para hacer eso, Salman Asif, Srikanth Krishnamurthy, Amit Roy-Chowdhury y Chengyu Song primero están averiguando qué ataques funcionan.

«La gente querría hacer estos ataques porque hay muchos lugares donde las máquinas interpretan los datos para tomar decisiones», dijo Roy-Chowdhury, investigador principal de un programa de exploración de inteligencia artificial de DARPA recientemente concluido llamado Técnicas para la interrupción de la visión artificial. «Podría interesar a un adversario manipular los datos sobre los que la máquina está tomando una decisión. ¿Cómo ataca un adversario un flujo de datos para que las decisiones sean incorrectas?»

Un adversario inyectaría algo de malware en el software de un vehículo autónomo, por ejemplo, de modo que cuando los datos ingresan desde la cámara se perturben levemente. Como resultado, los modelos instalados para reconocer a un peatón fallan y el sistema estaría alucinando un objeto o no viendo uno que sí existe. Comprender cómo generar ataques efectivos ayuda a los investigadores a diseñar mejores mecanismos de defensa.

«Estamos buscando cómo perturbar una imagen para que, si es analizada por un sistema de aprendizaje automático, se clasifique erróneamente», dijo Roy-Chowdhury. «Hay dos formas principales de hacer esto: Deepfakes, donde la cara o las expresiones faciales de alguien en un video se han alterado para engañar a un humano, y los ataques adversarios en los que un atacante manipula la forma en que la máquina toma una decisión, pero un humano es generalmente no se confunde. La idea es que haga un cambio muy pequeño en una imagen que un humano no puede percibir, pero que un sistema automatizado lo hará y cometerá un error».

Roy-Chowdhury, sus colaboradores y sus estudiantes han descubierto que la mayoría de los mecanismos de ataque existentes están dirigidos a clasificar erróneamente objetos y actividades específicos. Sin embargo, la mayoría de las escenas contienen varios objetos y, por lo general, existe alguna relación entre los objetos de la escena, lo que significa que ciertos objetos coexisten con más frecuencia que otros.

Las personas que estudian la visión por computadora llaman a esta co-ocurrencia «contexto». Los miembros del grupo han mostrado cómo diseñar ataques conscientes del contexto que alteran las relaciones entre los objetos en la escena.

«Por ejemplo, una mesa y una silla a menudo se ven juntas. Pero un tigre y una silla rara vez se ven juntos. Queremos manipularlos todos juntos», dijo Roy-Chowdhury. «Podría cambiar la señal de alto por una señal de límite de velocidad y quitar el cruce de peatones. Si reemplazó la señal de alto con una señal de límite de velocidad pero dejó el cruce de peatones, la computadora en un automóvil autónomo aún podría reconocerlo como una situación en la que tiene que parar».

A principios de este año, en la conferencia de la Asociación para el Avance de la Inteligencia Artificial, los investigadores demostraron que para que una máquina tome una decisión equivocada no basta con manipular un solo objeto. El grupo desarrolló una estrategia para diseñar ataques adversarios que cambian múltiples objetos simultáneamente de manera consistente.

«Nuestra idea principal fue que los ataques de transferencia exitosos requieren una manipulación holística de la escena. Aprendemos un gráfico de contexto para guiar nuestro algoritmo sobre qué objetos deben ser atacados para engañar al modelo de la víctima, mientras mantenemos el contexto general de la escena», dijo Salman Asif.

En un artículo presentado esta semana en la Conferencia sobre visión por computadora y reconocimiento de patrones, los investigadores, junto con sus colaboradores en PARC, una división de investigación de la empresa Xerox, profundizan en este concepto y proponen un método donde el atacante no tenía acceso. al sistema informático de la víctima. Esto es importante porque con cada intrusión el atacante corre el riesgo de ser detectado por la víctima y una defensa contra el ataque. Por lo tanto, es probable que los ataques más exitosos sean aquellos que no prueban en absoluto el sistema de la víctima, y es crucial anticipar y diseñar defensas contra estos ataques de «consulta cero».

El año pasado, el mismo grupo de investigadores explotó las relaciones contextuales en el tiempo para diseñar ataques contra secuencias de video. Usaron transformaciones geométricas para diseñar ataques muy eficientes en los sistemas de clasificación de video. El algoritmo conduce a perturbaciones exitosas en sorprendentemente pocos intentos. Por ejemplo, los ejemplos de confrontación generados a partir de esta técnica tienen mejores tasas de éxito de ataque con un 73 % menos de intentos en comparación con los métodos más avanzados para ataques de confrontación por video. Esto permite ataques más rápidos con muchas menos sondas en el sistema de la víctima. Este documento se presentó en la principal conferencia sobre aprendizaje automático, Neural Information Processing Systems 2021.

El hecho de que los ataques adversarios conscientes del contexto sean mucho más potentes en imágenes naturales con múltiples objetos que los existentes que se enfocan principalmente en imágenes con un solo objeto dominante abre el camino hacia defensas más efectivas. Estas defensas pueden considerar las relaciones contextuales entre objetos en una imagen, o incluso entre objetos en una escena en imágenes de múltiples cámaras. Esto tiene el potencial para el desarrollo de sistemas significativamente más seguros en el futuro.

Zikui Cai et al, Ataques de transferencia conscientes del contexto para la detección de objetos. arXiv:2112.03223v1 [cs.CV], arxiv.org/pdf/2112.03223.pdf

Zikui Cai et al, Ataques de transferencia de consulta cero en detectores de objetos sensibles al contexto. arXiv:2203.15230v1 [cs.CV], arxiv.org/pdf/2203.15230.pdf

Shasha Li et al, Ataques adversarios a los clasificadores de video de caja negra: aprovechar el poder de las transformaciones geométricas. arXiv:2110.01823v2 [cs.CV], arxiv.org/pdf/2110.01823.pdf

Citación: Protección de la visión por computadora de ataques adversarios (2022, 17 de junio) recuperado el 14 de julio de 2022 de https://techxplore.com/news/2022-06-vision-adversarial.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.