El NIST también ha tomado otras medidas, incluida la formación de un grupo asesor de seguridad de IA en febrero de este año, que incluía a creadores, usuarios y académicos de IA, para poner algunas barreras al uso y desarrollo de IA.

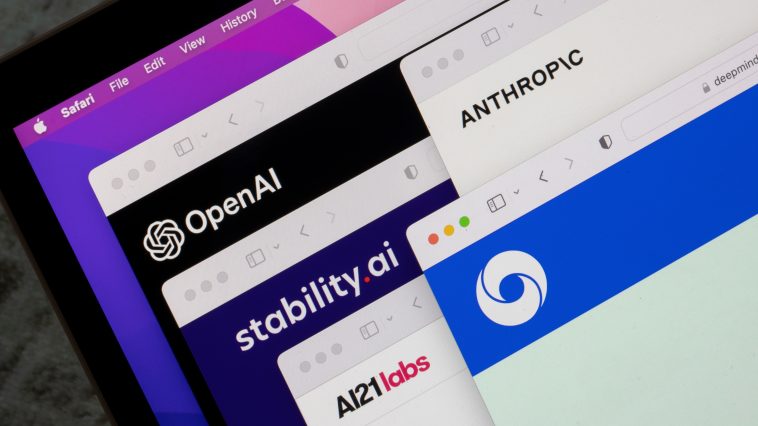

El grupo asesor, denominado Consorcio del Instituto de Seguridad de la IA de Estados Unidos (AISIC), ha recibido el encargo de elaborar directrices para la creación de equipos de trabajo en sistemas de IA, la evaluación de la capacidad de la IA, la gestión de riesgos, la garantía de la seguridad y la protección, y la colocación de marcas de agua en el contenido generado por la IA. Varias importantes empresas tecnológicas, entre ellas OpenAI, Meta, Google, Microsoft, Amazon, Intel y Nvidia, se han unido al consorcio para garantizar el desarrollo seguro de la IA.

GIPHY App Key not set. Please check settings