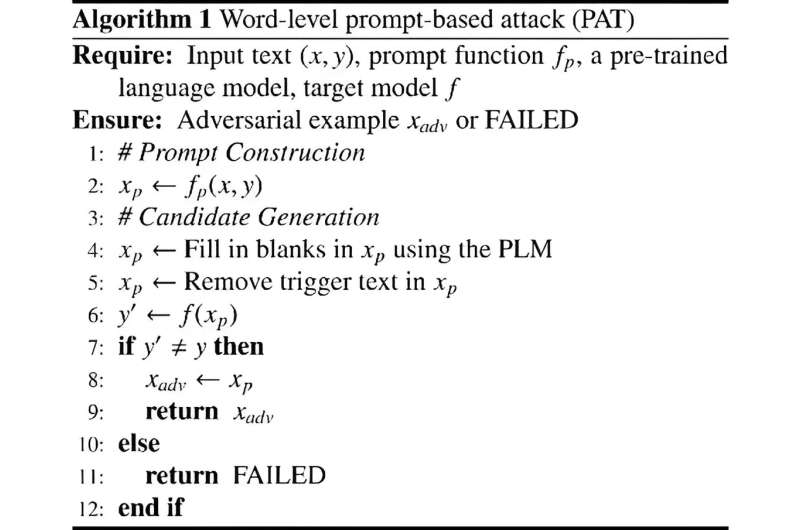

Diagrama del enfoque de ataque basado en indicaciones (PAT) del estudio. Crédito: Fronteras de la informática (2023). Documento de la investigación: 10.1007/s11704-023-2639-2

Los investigadores han desarrollado un nuevo enfoque para la seguridad de la IA que emplea mensajes de texto para proteger mejor a los sistemas de IA de las amenazas cibernéticas. Este método se centra en la creación de ejemplos adversarios para evitar que la IA se deje engañar por entradas que normalmente son indetectables para los humanos.

La técnica basada en indicaciones simplifica la generación de estas entradas adversarias, lo que permite una respuesta más rápida a las amenazas potenciales sin necesidad de realizar cálculos extensos. Las pruebas preliminares han demostrado que este método puede proteger eficazmente las respuestas de la IA con una interacción directa mínima con los sistemas de IA.

El Dr. Feifei Ma, el investigador principal, describe el proceso: «Nuestro enfoque implicó inicialmente la creación de mensajes maliciosos para identificar vulnerabilidades en los modelos de IA. Después de esta identificación, estos mensajes se utilizaron como datos de entrenamiento, ayudando a la IA a resistir ataques similares en el futuro».

Experimentos posteriores indicaron que este método de entrenamiento mejoraba la solidez de los sistemas de IA. Los modelos entrenados con indicaciones adversarias tenían menos probabilidades de sucumbir a ataques similares, lo que demuestra una mejora en sus capacidades defensivas.

«Este método nos permite exponer y luego mitigar vulnerabilidades en los modelos de IA, lo que es especialmente crítico en sectores como las finanzas y la atención médica», señaló el Dr. Ma.

El investigaciónpublicado en Fronteras de la informáticaindica que los sistemas de IA entrenados con estos mensajes adversarios son más capaces de resistir tácticas de manipulación similares en el futuro, mejorando potencialmente su robustez general contra las amenazas cibernéticas.

Es un trabajo colaborativo entre la Academia China de Ciencias, la Universidad de la Academia China de Ciencias, la Universidad de Stanford y la Universidad Nacional de Singapur.

Más información:

Yuting Yang et al, Un enfoque basado en indicaciones para la generación de ejemplos adversarios y la mejora de la robustez, Fronteras de la informática (2023). Documento de la investigación: 10.1007/s11704-023-2639-2

Proporcionado por Higher Education Press

Citación:Nueva técnica basada en indicaciones para mejorar la seguridad de la IA (24 de junio de 2024) recuperado el 12 de julio de 2024 de https://techxplore.com/news/2024-06-prompt-based-technique-ai.html

Este documento está sujeto a derechos de autor. Salvo que se haga un uso legítimo con fines de estudio o investigación privados, no se podrá reproducir ninguna parte del mismo sin autorización por escrito. El contenido se ofrece únicamente con fines informativos.

GIPHY App Key not set. Please check settings