|

|

AWS se compromete a traerle los modelos de base más avanzados (FMS) en la industria, ampliando continuamente nuestra selección para incluir modelos innovadores de los innovadores de IA líderes para que siempre tenga acceso a los últimos avances para impulsar su negocio hacia adelante.

Hoy me complace anunciar la disponibilidad de dos nuevos modelos Operai con pesas abiertas en Amazon Bedrock y Amazon Sagemaker JumpStart. Opadai GPT-OSS-120B y GPT-OSS-20B Los modelos están diseñados para tareas de generación de texto y razonamiento, ofreciendo a los desarrolladores y organizaciones nuevas opciones para crear aplicaciones de IA con control completo sobre su infraestructura y datos.

Estos modelos de peso abierto se destacan en la codificación, el análisis científico y el razonamiento matemático, con un rendimiento comparable a las alternativas principales. Ambos modelos admiten una ventana de contexto de 128k y proporcionan niveles de razonamiento ajustables (bajo/medio/alto) para que coincida con los requisitos de su caso de uso específicos. Los modelos admiten herramientas externas para mejorar sus capacidades y pueden usarse en un flujo de trabajo de agente, por ejemplo, utilizando un marco como Agentes de hilos.

Con Amazon Bedrock y Amazon Sagemaker JumpStart, AWS le brinda la libertad de innovar con el acceso a cientos de FMS de las principales compañías de IA, incluidos los modelos de peso abierto de OpenAI. Con nuestra selección completa de modelos, puede hacer coincidir sus cargas de trabajo de IA con el modelo perfecto cada vez.

A través de Amazon Bedrock, puede experimentar sin problemas con diferentes modelos, capacidades de mezcla y coincidencia, y cambiar entre proveedores sin reescribir el código, convirtiendo la elección del modelo en una ventaja estratégica que le ayuda a evolucionar continuamente su estrategia de IA como nuevas innovaciones. En el lanzamiento, estos nuevos modelos están disponibles en Bedrock a través de un punto final compatible de OpenAI. Puede apuntar el SDK de OpenAI a este punto final o usar el Bedrock Invokemodel y Converse API.

Con Sagemaker JumpStart, puede evaluar, comparar y personalizar rápidamente los modelos para su caso de uso. Luego puede implementar el modelo original o personalizado en producción con la consola Sagemaker AI o usar el Sagemaker Python SDK.

Veamos cómo funcionan en la práctica.

Comenzando con los modelos de peso abierto de Operai en Amazon Bedrock

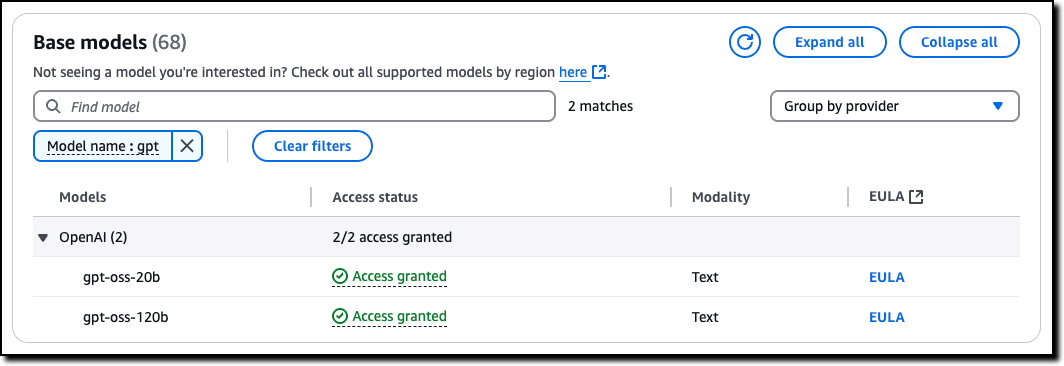

En la consola de rock de Amazon, elijo Acceso modelo desde Configurar y aprender Sección del panel de navegación. Luego, navego a los dos modelos OpenAI enumerados en esta página y solicito acceso.

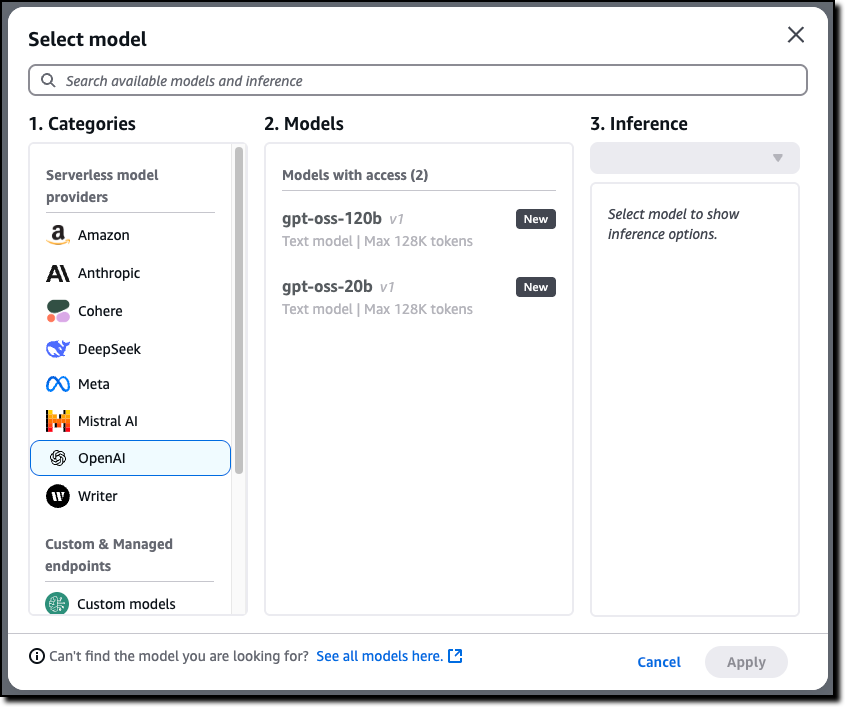

Ahora que tengo acceso, uso el Chat/prueba patio de recreo para probar y evaluar los modelos. Yo selecciono Opadai como la categoría y luego el GPT-OSS-120B modelo.

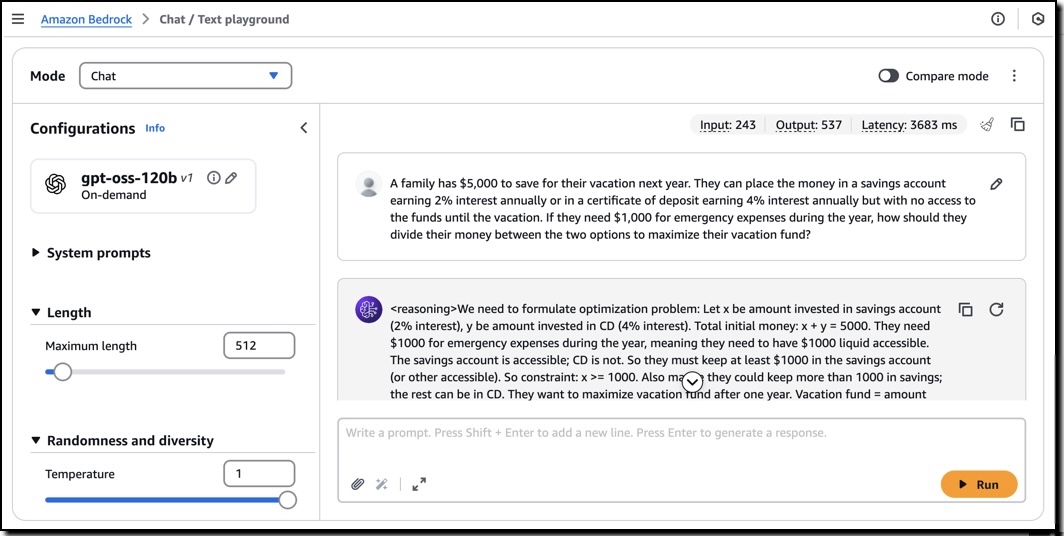

Usando este modelo, ejecuto el siguiente mensaje de muestra:

Una familia tiene $ 5,000 para ahorrar para sus vacaciones el próximo año. Pueden colocar el dinero en una cuenta de ahorros que gane un 2% de interés anualmente o en un certificado de depósito que gane un 4% de interés anualmente pero sin acceso a los fondos hasta las vacaciones. Si necesitan $ 1,000 para gastos de emergencia durante el año, ¿cómo deberían dividir su dinero entre las dos opciones para maximizar su fondo de vacaciones?

Este aviso genera una salida que incluye la cadena de pensamiento utilizada para producir el resultado.

Puedo usar estos modelos con el SDK de Operai configurando el punto final API (URL base) y utilizando una tecla API de roca madre de Amazon para la autenticación. Por ejemplo, configuré estas variables de entorno para usar el punto final de la región de AWS de EE. UU. West (Oregon) (us-west-2) y mi llave de la API de roca madre de Amazon:

export OPENAI_API_KEY=""

export OPENAI_BASE_URL="https://bedrock-runtime.us-west-2.amazonaws.com/openai/v1" Ahora invoco el modelo usando el SDK Operai Python.

client = OpenAI()

response = client.chat.completion.create(

messages=[{

"role": "user",

"content": "Hello, how are you?"

}],

model="openai.gpt-oss-120b-1:0",

stream=True

)

for item in response:

print(item)Para construir un agente de IA, puedo elegir cualquier marco que admita la API de rock de Amazon o la API de OpenAI. Por ejemplo, aquí está el código de inicio para los agentes de hilos que usan la API de rock de Amazon:

from strands import Agent

from strands.models import BedrockModel

from strands_tools import calculator

model = BedrockModel(

model_id="openai.gpt-oss-120b-1:0"

)

agent = Agent(

model=model,

tools=[calculator]

)

agent("Tell me the square root of 42 ^ 3")Guardo el código (app.py archivo), instalar las dependencias y ejecutar el agente localmente:

pip install strands-agents strands-agents-tools

python app.pyCuando estoy satisfecho con el agente, puedo implementar en producción utilizando las capacidades ofrecidas por Amazon Bedrock AgentCore, incluido un tiempo de ejecución y administración de identidad e identidad totalmente administrados.

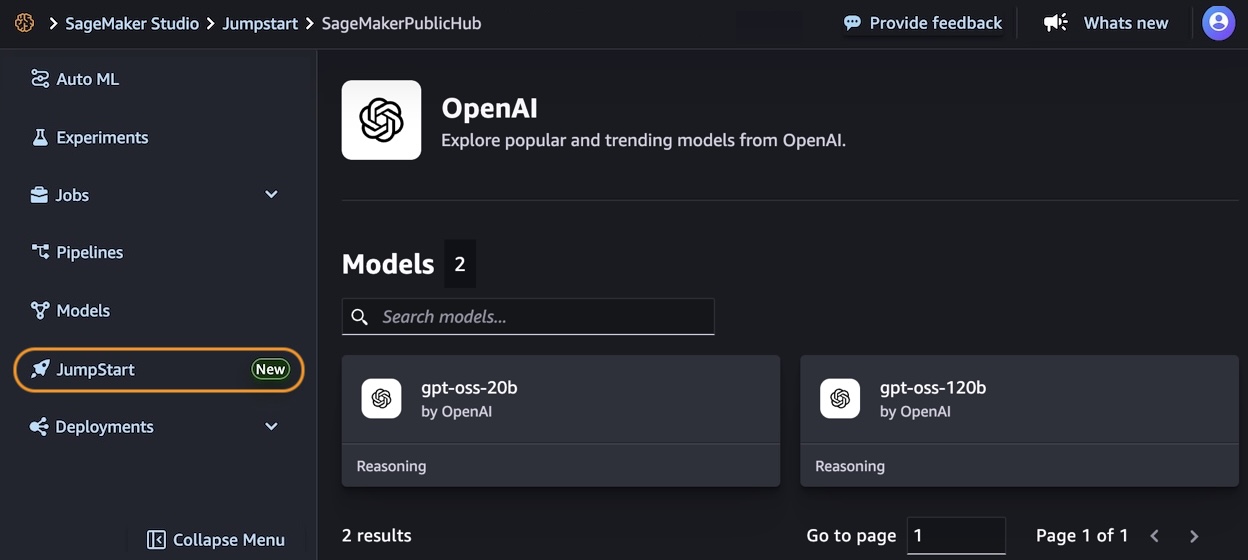

Comenzando con los modelos de peso abierto de Operai en Amazon Sagemaker Jumpstart

En la consola AI de Amazon Sagemaker, puede usar modelos OpenAI Open Weight en Sagemaker Studio. La primera vez que hago esto, necesito configurar un dominio de Sagemaker. Hay opciones para configurarlo para un solo usuario (más simple) o una organización. Para estas pruebas, uso una sola configuración del usuario.

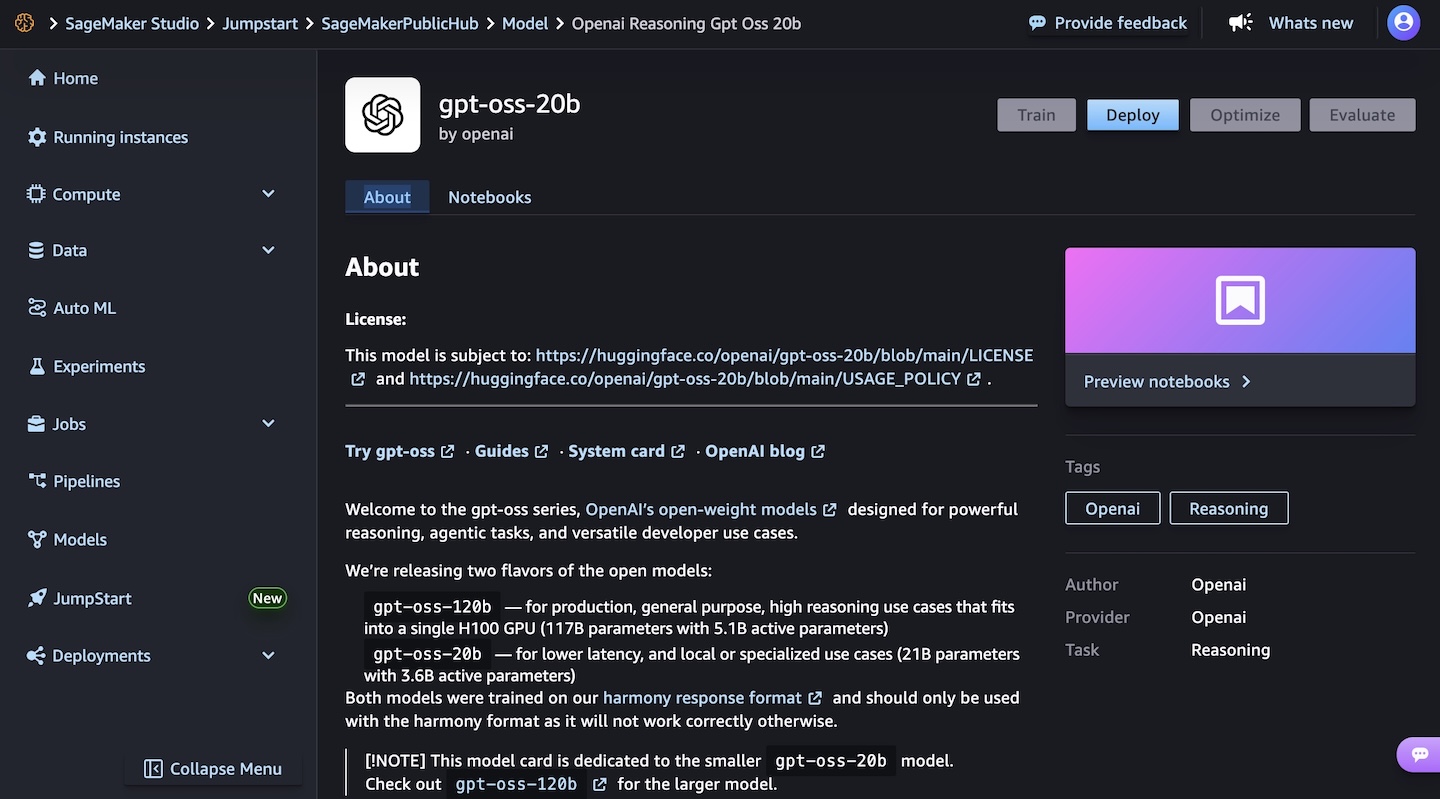

En el Sagemaker Jumpstart Vista del modelo, tengo acceso a una descripción detallada del GPT-OSS-120B o GPT-OSS-20B modelo.

Elijo el modelo GPT-OSS-20B y luego implementa el modelo. En los siguientes pasos, selecciono el tipo de instancia y el recuento de instancias inicial. Después de unos minutos, la implementación crea un punto final que puedo invocar en Sagemaker Studio y usando cualquier SDK de AWS.

Para obtener más información, visite los modelos GPT OSS de OpenAI ahora están disponibles en Sagemaker JumpStart en el Blog de Inteligencia Artificial de AWS.

Cosas que saber

Los nuevos modelos de peso abierto Operai ahora están disponibles en Amazon Bedrock en la región de AWS de los Estados Unidos al oeste (Oregon), mientras que Amazon Sagemaker Jumpstart admite estos modelos en US East (Ohio, N. Virginia) y Asia Pacific (Mumbai, Tokio).

Cada modelo viene equipado con capacidades completas de salida de la cadena de pensamiento, proporcionando una visibilidad detallada en el proceso de razonamiento del modelo. Esta transparencia es particularmente valiosa para las aplicaciones que requieren altos niveles de interpretabilidad y validación. Estos modelos le dan la libertad de modificarlos, adaptarlos y personalizarlos a sus necesidades específicas. Esta flexibilidad le permite ajustar los modelos para sus casos de uso únicos, integrarlos en sus flujos de trabajo existentes e incluso construir sobre ellos para crear nuevos modelos especializados adaptados a su industria o aplicación.

La seguridad y la seguridad están integradas en el núcleo de estos modelos, con procesos de evaluación integrales y medidas de seguridad. Los modelos mantienen la compatibilidad con el tokenizador GPT-4 estándar.

Ambos modelos se pueden usar en su entorno preferido, ya sea a través de la experiencia sin servidor de Amazon Bedrock o las extensas capacidades de desarrollo de aprendizaje automático (ML) de Sagemaker JumpStart. Para obtener información sobre los costos asociados con el uso de estos modelos y servicios, visite las páginas de precios de Amazon Bedrock y Amazon SageMaker AI.

Para obtener más información, consulte los parámetros para los modelos y la API de finalización de chat en la documentación de Amazon Bedrock.

Comience hoy con los modelos de peso abierto de OpenAI en AWS en la consola Bedrock de Amazon o en la consola AI de Amazon Sagemaker.

– Danilo