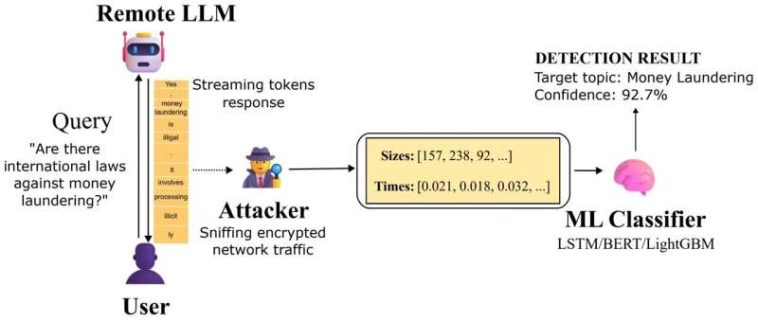

Tubería de ataque Whisper Leak: un adversario de red pasivo observa el tráfico TLS cifrado entre el usuario y el servicio LLM, extrae el tamaño de los paquetes y las secuencias de tiempo, y utiliza clasificadores capacitados para inferir si el tema de la conversación coincide con una categoría objetivo sensible. Crédito: arXiv (2025). DOI: 10.48550/arxiv.2511.03675

Es posible que sus conversaciones con asistentes de inteligencia artificial como ChatGPT y Google Gemini no sean tan privadas como cree. Microsoft ha revelado una falla grave en los grandes modelos de lenguaje (LLM) que impulsan estos servicios de inteligencia artificial, exponiendo potencialmente el tema de sus conversaciones con ellos. Los investigadores denominaron la vulnerabilidad «Whisper Leak» y descubrieron que afecta a casi todos los modelos que probaron.

Cuando chateas con asistentes de inteligencia artificial integrados en los principales motores de búsqueda o aplicaciones, la información está protegida por TLS (Transport Layer Security), el mismo cifrado que se utiliza para la banca en línea. Estas conexiones seguras impiden que posibles espías lean las palabras que escribe. Sin embargo, Microsoft descubrió que los metadatos (cómo viajan sus mensajes a través de Internet) siguen siendo visibles. Whisper Leak no rompe el cifrado, pero aprovecha lo que el cifrado no puede ocultar.

Prueba de LLM

en investigacion publicado en el arXiv servidor de preimpresión, los investigadores de Microsoft explican cómo probaron 28 LLM para buscar esta vulnerabilidad. Primero, crearon dos conjuntos de preguntas. Uno era una colección de muchas formas de preguntar sobre un tema único y delicado, como el lavado de dinero, y el otro conjunto estaba lleno de miles de consultas cotidianas aleatorias. Luego registraron en secreto el ritmo de datos de cada red. Este es el tamaño del paquete (fragmentos de datos que se envían) y el tiempo (el retraso entre el envío de un paquete y la llegada del otro).

A continuación, entrenaron un programa de inteligencia artificial para distinguir los temas sensibles de las consultas cotidianas basándose únicamente en el ritmo de los datos. Si la IA pudiera identificar con éxito los temas sensibles sin leer el texto cifrado, confirmaría un problema de privacidad.

En la mayoría de los modelos, la IA adivinó correctamente el tema de conversación con más del 98% de precisión. El ataque también podría identificar conversaciones sensibles el 100% de las veces, incluso cuando ocurrieron en sólo 1 de cada 10.000 conversaciones. Los investigadores probaron tres formas diferentes de defenderse de los ataques, pero ninguna los detuvo por completo.

Deteniendo la fuga

Según el equipo, el problema no es el cifrado en sí, sino cómo se transmiten las respuestas. «Esto no es una vulnerabilidad criptográfica en TLS en sí, sino más bien una explotación de metadatos que TLS revela inherentemente sobre la estructura y el tiempo del tráfico cifrado».

Dada la gravedad de la filtración y la facilidad con la que se puede ejecutar el ataque, los investigadores afirman claramente en su artículo que la industria debe proteger los sistemas futuros. «Nuestros hallazgos subrayan la necesidad de que los proveedores de LLM aborden la fuga de metadatos a medida que los sistemas de inteligencia artificial manejan información cada vez más confidencial».

Escrito para ti por nuestro autor pablo arnoldeditado por Gaby Clarky verificados y revisados por Robert Egan—Este artículo es el resultado de un cuidadoso trabajo humano. Dependemos de lectores como usted para mantener vivo el periodismo científico independiente. Si este informe es importante para usted, considere una donación (especialmente mensual). Obtendrás un sin publicidad cuenta como agradecimiento.

Más información:

Geoff McDonald et al, Whisper Leak: un ataque de canal lateral a modelos de lenguaje grandes, arXiv (2025). DOI: 10.48550/arxiv.2511.03675

Blog de microsoft: www.microsoft.com/en-us/securi… ote-language-models/

© 2025 Red Ciencia X

Citación: Microsoft encuentra una falla de seguridad en los chatbots de IA que podrían exponer temas de conversación (2025, 10 de noviembre) recuperado el 10 de noviembre de 2025 de https://techxplore.com/news/2025-11-microsoft-flaw-ai-chatbots-expose.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.