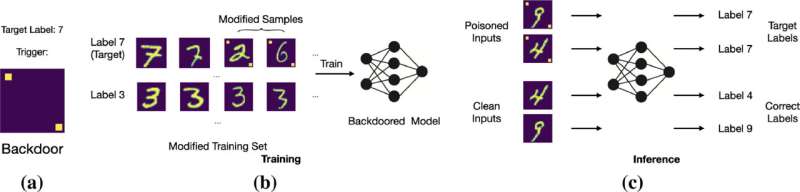

El activador distribuido visible se muestra en la Figura 1(a) y la etiqueta objetivo es siete (7). Los datos de entrenamiento se modifican. Vemos esto en la Figura 1(b) y el modelo está entrenado con estos datos envenenados. Las entradas sin disparador se clasificarán correctamente y las que tengan disparador se clasificarán incorrectamente durante la inferencia, como se ve en la Figura 1(c). Crédito: SUTD

Los sistemas de software están a nuestro alrededor, desde los sistemas operativos de nuestras computadoras hasta los motores de búsqueda y la automatización utilizada en aplicaciones industriales. En el centro de todo esto se encuentran los datos, que se utilizan en componentes de aprendizaje automático (ML) que están disponibles en una amplia variedad de aplicaciones, incluidos automóviles autónomos y modelos de lenguaje grande (LLM). Debido a que muchos sistemas dependen de componentes ML, es importante garantizar su seguridad y confiabilidad.

Para los modelos ML entrenados con métodos de optimización robustos (modelos ML robustos), se desconoce su efectividad contra varios ataques. Un ejemplo de un vector de ataque importante es el envenenamiento de puerta trasera, que se refiere a datos de entrenamiento comprometidos que se introducen en el modelo. Existen tecnologías que detectan ataques de puerta trasera en modelos de ML estándar, pero los modelos robustos requieren diferentes métodos de detección para ataques de puerta trasera porque se comportan de manera diferente a los modelos estándar y tienen suposiciones diferentes.

Esta es la brecha que la Dra. Sudipta Chattopadhyay, Profesora Asistente en el Pilar de Tecnología y Diseño de Sistemas de Información (ISTD) de la Universidad de Tecnología y Diseño de Singapur (SUTD), pretendía cerrar.

En el estudio «Hacia ataques de puerta trasera y defensa en modelos robustos de aprendizaje automático», publicado en Informática y Seguridad, Asistente El Prof. Chattopadhyay y otros investigadores de SUTD estudiaron cómo inyectar y defenderse contra ataques de puerta trasera para modelos robustos en un determinado componente de ML llamado clasificadores de imágenes. En concreto, los modelos estudiados fueron entrenados utilizando el método de descenso de gradiente proyectado (PGD) de última generación.

El problema de la puerta trasera es urgente y peligroso, especialmente debido a cómo se desarrollan las canalizaciones de software actuales. Chattopadhyay declaró: «Hoy en día, nadie desarrolla una canalización de modelo de ML y una recopilación de datos desde cero. Es posible que descarguen datos de capacitación de Internet o incluso usen un modelo previamente entrenado. Si el modelo o conjunto de datos previamente entrenado está envenenado, el software resultante, el uso de estos modelos será inseguro. A menudo, solo se necesita el 1% del envenenamiento de datos para crear una puerta trasera».

La dificultad con los ataques de puerta trasera es que solo el atacante conoce el patrón de envenenamiento. El usuario no puede pasar por este patrón de envenenamiento para reconocer si su modelo ML ha sido infectado.

«La dificultad del problema nos fascinó. Especulamos que las partes internas de un modelo de puerta trasera podrían ser diferentes a las de un modelo limpio», dijo Chattopadhyay.

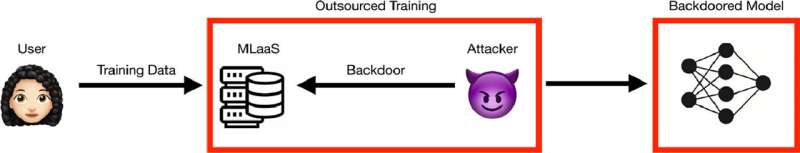

Un modelo de ataque para AEGIS. Crédito: SUTD

Con este fin, Chattopadhyay investigó los ataques de puerta trasera en busca de modelos robustos y descubrió que son muy susceptibles (tasa de éxito del 67,8 %). También descubrió que envenenar un conjunto de entrenamiento crea distribuciones de entrada mixtas para la clase envenenada, lo que permite que el modelo robusto aprenda múltiples representaciones de características para una determinada clase de predicción. Por el contrario, los modelos limpios solo aprenderán una única representación de características para una determinada clase de predicción.

Junto con otros investigadores, Chattopadhyay aprovechó este hecho para desarrollar AEGIS, la primera técnica de detección de puerta trasera para modelos robustos entrenados por PGD. Mediante el uso de t-Distributed Stochastic Neighbor Embedding (t-SNE) y Mean Shift Clustering como técnica de reducción de dimensionalidad y método de agrupación, respectivamente, AEGIS puede detectar múltiples representaciones de características en una clase e identificar modelos infectados por la puerta trasera.

AEGIS opera en cinco pasos: (1) utiliza un algoritmo para generar imágenes traducidas, (2) extrae representaciones de características del entrenamiento limpio y de imágenes traducidas limpias/backdoor, (3) reduce las dimensiones de las características extraídas a través de t-SNE, (4) emplea el cambio medio para calcular los grupos de las representaciones de características reducidas, y (5) cuenta estos grupos para determinar si el modelo está infectado o limpio.

Si hay dos clústeres (las imágenes de entrenamiento y las imágenes traducidas) en un modelo, AEGIS marca este modelo como limpio. Si hay más de dos grupos (las imágenes de entrenamiento, las imágenes traducidas limpias y las imágenes traducidas envenenadas), AEGIS marca este modelo como sospechoso e infectado por la puerta trasera.

Además, AEGIS detectó efectivamente el 91,6 % de todos los modelos robustos infectados por la puerta trasera con solo una tasa de falsos positivos del 11,1 %, lo que demuestra su alta eficacia. Dado que incluso la mejor técnica de detección de puertas traseras en los modelos estándar no puede señalar puertas traseras en modelos robustos, el desarrollo de AEGIS es importante. Es fundamental tener en cuenta que AEGIS está especializado para detectar ataques de puerta trasera en modelos robustos y es ineficaz en modelos estándar.

Además de la capacidad de detectar ataques de puerta trasera en modelos robustos, AEGIS también es eficiente. En comparación con las defensas de puerta trasera estándar que tardan horas o días en identificar un modelo infectado por la puerta trasera, AEGIS solo tarda un promedio de cinco a nueve minutos. En el futuro, Chattopadhyay tiene como objetivo perfeccionar AEGIS para que pueda funcionar con distribuciones de datos diferentes y más complicadas para defenderse de más modelos de amenazas además de los ataques de puerta trasera.

Reconociendo el alboroto en torno a la inteligencia artificial (IA) en el clima actual, Chattopadhyay expresó: «Esperamos que las personas sean conscientes de los riesgos asociados con la IA. Las tecnologías impulsadas por LLM como ChatGPT están de moda, pero existen grandes riesgos y los ataques de puerta trasera son solo uno. de ellos Con nuestra investigación, nuestro objetivo es lograr la adopción de una IA confiable».

Más información:

Ezekiel Soremekun et al, Hacia ataques de puerta trasera y defensa en modelos robustos de aprendizaje automático, Informática y Seguridad (2023). DOI: 10.1016/j.cose.2023.103101

Citación: Mantener la puerta trasera segura en su robusto modelo de aprendizaje automático (27 de junio de 2023) consultado el 27 de junio de 2023 en https://techxplore.com/news/2023-06-backdoor-robust-machine.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.