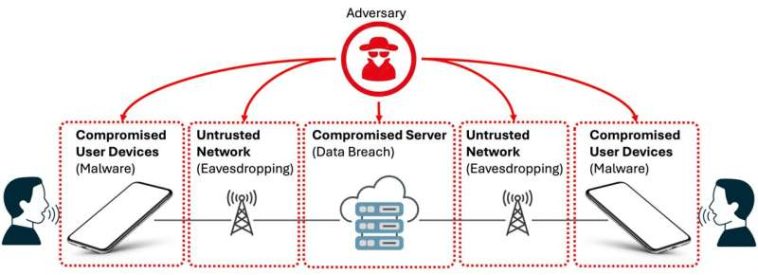

Modelo de amenazas de VoiceSecure. Crédito: Nirupam Roy, Universidad de Maryland.

Cuando realizas una llamada de voz a través de Zoom, FaceTime o WhatsApp, no solo estás compartiendo lo que dices. Estás revelando tu edad, sexo, estado emocional, origen social y personalidad: una huella biométrica tan única como tu rostro. Y cada vez más, la inteligencia artificial escucha.

«Ya vemos phishing basado en nuestras actividades en línea y en lo que escribimos en los correos electrónicos», afirmó Nirupam Roy, profesor asociado de ciencias de la computación en la Universidad de Maryland.

«Ahora, una cantidad significativa de nuestras comunicaciones de voz fluyen a través de plataformas digitales, por lo que existe una vulnerabilidad sin precedentes en la privacidad cuando se trata de nuestro propio discurso. Anticipamos que las amenazas se volverán muy reales con la voz y los datos del habla, especialmente a medida que la inteligencia artificial se agregue a la mezcla».

Si bien nos preocupamos por lo que escribimos en los correos electrónicos o publicamos en las redes sociales, nuestras voces transmiten inadvertidamente información profundamente personal cada vez que nos comunicamos en línea. Los datos de voz pueden ser peligrosos en las manos equivocadas, lo que permite ataques de phishing dirigidos, generación de deepfake, robo biométrico e incluso ingeniería social sofisticada.

Roy está trabajando para abordar esta creciente amenaza a nuestra seguridad personal. Para proteger los datos de voz humana contra el robo y el uso por parte de terceros malintencionados, él y su grupo de investigación en la UMD diseñaron Voz seguraun sistema innovador que oscurece el habla de la inteligencia artificial y al mismo tiempo mantiene las conversaciones muy claras para los oídos humanos.

Cuando cada llamada se convierte en una mina de datos

No es sólo el contenido de una conversación lo que puede ser valioso para los actores maliciosos. Según Roy, el mayor desafío al abordar las preocupaciones sobre la privacidad es la información «metalingüística» que contienen las voces humanas: emociones, características biológicas, patrones de estrés y marcadores de identidad.

«Las conversaciones gubernamentales y militares a menudo requieren una fuerte protección contra las escuchas de voz, pero incluso las conversaciones de bajo riesgo pueden revelar una gran cantidad de información», dijo Roy. «La conversación FaceTime de una madre con su hijo puede revelar detalles personales cruciales que pueden usarse para crear cualquier cosa, desde anuncios dirigidos hasta clonación de voz para su uso en fraude».

Grupo de investigación de Nirupam Roy en la Universidad de Maryland. Crédito: John T. Consoli, Universidad de Maryland.

Los estafadores y creadores de deepfake utilizan Voces generadas por IA para que sus planes sean más convincentes. El robo biométrico permite el acceso no autorizado a sistemas autenticados por voz, como cuentas bancarias o registros médicos de pacientes. Y los ataques sofisticados de ingeniería social se vuelven mucho más efectivos cuando los atacantes utilizan perfiles detallados creados a partir de patrones de habla humana genuinos y detalles biométricos.

Roy señaló que las empresas y plataformas ya cuentan con procedimientos para mantener seguros los datos de los usuarios, pero estas estrategias a menudo resultan insuficientes en la práctica.

Algunas soluciones implican agregar ruido que oscurece las conversaciones de audio, lo que puede degradar la calidad de las llamadas para los usuarios. El cifrado tradicional, la técnica más utilizada, también enfrenta desafíos importantes, incluida la necesidad de que ambos extremos cifren y descifren contenido en tiempo real, lo que consume grandes cantidades de potencia informática que no todos los dispositivos pueden soportar cómodamente.

Esta incompatibilidad de los dispositivos de los usuarios, como una computadora de escritorio versus un dispositivo móvil, puede crear puntos débiles de seguridad que los adversarios pueden explotar.

«Cuando los sistemas de comunicación se vuelven más complicados, los usuarios finales pierden el control sobre sus propios datos», afirmó Roy. «Incluso cuando tenemos cifrado de extremo a extremo en muchas plataformas, estas protecciones a menudo son opcionales, difíciles de implementar o simplemente no se siguen. Y resulta más fácil para los malos actores con herramientas como la IA explotar estas debilidades».

El sistema VoiceSecure de Roy tiene como objetivo abordar esas limitaciones y combatir ataques maliciosos aprovechando una diferencia clave entre humanos y máquinas: cómo ambos procesan el sonido.

«La audición humana tiene limitaciones inherentes. Las personas no son igualmente sensibles a todas las frecuencias de sonido. Por ejemplo, dos sonidos muy juntos en frecuencias más altas a menudo no pueden descifrarse como diferentes. Los efectos psicoacústicos moldean la forma en que nuestro cerebro entiende el sonido; no se trata solo de la frecuencia, sino también de la sensibilidad y el contexto», explicó Roy.

«Por el contrario, las máquinas tratan todas las frecuencias como puntos de datos individuales con precisión matemática. Analizan cada característica acústica para identificar a los hablantes y extraer información».

Utilizando el aprendizaje por refuerzo impulsado por IA, el sistema VoiceSecure optimiza las señales de voz para suprimir las funciones de las que dependen las máquinas para el reconocimiento y la elaboración de perfiles, al tiempo que conserva las características que los humanos utilizan para comprender el habla y reconocerse entre sí.

VoiceSecure, que funciona como un módulo de micrófono que opera a nivel de firmware o controlador, captura y transforma datos de voz en el punto más temprano posible en el proceso de comunicación, incluso antes de que lleguen al sistema operativo de un dispositivo. Ese delicado equilibrio entre la escucha humana y la máquina podría interponerse entre una conversación privada y una IA no deseada que escucha a escondidas, señaló Roy.

Prototipo de VoiceSecure. Crédito: Nirupam Roy, Universidad de Maryland.

«La comunicación por voz es muy personal, por lo que queríamos mantener esa calidad humana en nuestro sistema. Una madre aún debería poder reconocer la voz de su hijo durante una llamada, pero los sistemas automatizados de vigilancia de IA no deberían identificar al hablante ni extraer datos biométricos confidenciales», dijo Roy.

«La clave de este trabajo es jugar con la brecha entre lo que los humanos pueden oír y lo que las máquinas pueden oír».

Roy y su equipo ya han probado con éxito el audio alterado de VoiceSecure en usuarios reales, confirmando que las conversaciones siguen siendo inteligibles para los humanos e impenetrables para las máquinas.

Los usuarios también pueden personalizar sus niveles de privacidad preferidos y mantener el control de sus voces sin depender de las acciones o la tecnología de otras partes, incluidos sus interlocutores y la plataforma de comunicación.

El equipo espera trabajar con ingenieros y socios de la industria para empaquetar el sistema como un software instalable que pueda aplicarse a todas las computadoras y dispositivos inteligentes.

Mientras tanto, Roy señala que la vigilancia humana es tan vital como la defensa tecnológica para proteger los sistemas digitales y nuestra privacidad.

«La conciencia es la clave para garantizar la seguridad cuando los humanos están al tanto», dijo.

En colaboración con Mega Subramaniam, profesora de ciencias de la información de la UMD, y Sanorita Dey, profesora asistente de ciencias informáticas del condado de Baltimore de la Universidad de Maryland, Roy lanzó Cyber-Ninja, una plataforma impulsada por inteligencia artificial que transforma la capacitación en ciberseguridad en una experiencia interactiva similar a un juego.

Diseñado para adolescentes y adultos mayores, Cyber-Ninja ayuda a los usuarios a detectar y evitar ataques de phishing mientras desarrolla habilidades de pensamiento crítico y confianza digital. El equipo ya ha realizado talleres exitosos en bibliotecas de Maryland, demostrando cómo la educación impulsada por la IA puede fortalecer la resiliencia de la comunidad contra las amenazas digitales en evolución.

«Desde los chatbots de servicio al cliente hasta las aspiradoras robóticas y los dispositivos incorporados como Alexa, la inteligencia artificial realmente se ha arraigado en nuestras vidas. Y a medida que la IA se vuelve más físicamente presente, la necesidad de protecciones sólidas de la privacidad se vuelve aún más urgente», dijo Roy.

«Queremos que la IA evolucione, ya que hace mucho bien, pero es importante abordar las amenazas en evolución desarrollando también nuestros propios mecanismos de defensa».

Citación: Fighting AI with AI: System protege los datos de voz personales de la vigilancia automatizada (2025, 28 de octubre) recuperado el 28 de octubre de 2025 de https://techxplore.com/news/2025-10-ai-personal-voice-automated-surveillance.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.