|

|

Hoy, Amazon Bedrock presenta nuevos niveles de servicio que le brindan más control sobre los costos de su carga de trabajo de IA y al mismo tiempo mantienen los niveles de rendimiento que sus aplicaciones necesitan.

Estoy trabajando con clientes que crean aplicaciones de IA. He visto de primera mano cómo diferentes cargas de trabajo requieren diferentes compensaciones en términos de rendimiento y costos. Muchas organizaciones que ejecutan cargas de trabajo de IA enfrentan desafíos para equilibrar los requisitos de rendimiento con la optimización de costos. Algunas aplicaciones necesitan tiempos de respuesta rápidos para interacciones en tiempo real, mientras que otras pueden procesar datos de forma más gradual. Con estos desafíos en mente, hoy anunciamos precios de opciones adicionales que le brindan más flexibilidad para satisfacer los requisitos de su carga de trabajo con la optimización de costos.

Amazon Bedrock ahora ofrece tres niveles de servicio para cargas de trabajo: Prioridad, Estándar y Flex. Cada nivel está diseñado para cumplir con los requisitos de carga de trabajo específicos. Las aplicaciones tienen diferentes requisitos de tiempo de respuesta según el caso de uso. Algunas aplicaciones, como los sistemas de comercio financiero, exigen tiempos de respuesta más rápidos, otras necesitan tiempos de respuesta rápidos para respaldar procesos comerciales como la generación de contenido, y aplicaciones como el resumen de contenido pueden procesar datos de manera más gradual.

El Prioridad El nivel procesa sus solicitudes antes que otros niveles, proporcionando una asignación informática preferencial para aplicaciones de misión crítica, como asistentes basados en chat de cara al cliente y servicios de traducción de idiomas en tiempo real, aunque a un precio superior. El Estándar El nivel proporciona un rendimiento constante a velocidades regulares para las tareas diarias de IA, ideal para la generación de contenido, análisis de texto y procesamiento de documentos de rutina. Para cargas de trabajo que pueden soportar una latencia más larga, el Doblar El nivel ofrece una opción más rentable con precios más bajos, que es muy adecuado para evaluaciones de modelos, resúmenes de contenido, análisis de varios pasos y flujos de trabajo agentes.

Ahora puede optimizar sus gastos haciendo coincidir cada carga de trabajo con el nivel más adecuado. Por ejemplo, si está ejecutando un asistente basado en chat de servicio al cliente que necesita respuestas rápidas, puede usar el nivel de Prioridad para obtener los tiempos de procesamiento más rápidos. Para tareas de resumen de contenido que pueden tolerar tiempos de procesamiento más prolongados, puede utilizar el nivel Flex para reducir costos y al mismo tiempo mantener un rendimiento confiable. Para la mayoría de los modelos que admiten Priority Tier, los clientes pueden obtener una latencia de tokens de salida por segundo (OTPS) hasta un 25 % mejor en comparación con el nivel estándar.

Consulte la documentación de Amazon Bedrock para obtener una lista actualizada de los modelos admitidos para cada nivel de servicio.

Elegir el nivel adecuado para su carga de trabajo

A continuación se incluye un modelo mental que le ayudará a elegir el nivel adecuado para su carga de trabajo.

| Categoría | Nivel de servicio recomendado | Descripción |

|---|---|---|

| Misión crítica | Prioridad | Las solicitudes se manejan por delante de otros niveles. Respuestas de menor latencia para aplicaciones orientadas al usuario (por ejemplo, asistentes de chat de servicio al cliente, traducción de idiomas en tiempo real, asistentes interactivos de IA) |

| Estándar empresarial | Estándar | Rendimiento responsivo para cargas de trabajo importantes (por ejemplo, generación de contenido, análisis de texto, procesamiento de documentos de rutina) |

| No crítico para el negocio | Doblar | Rentable para cargas de trabajo menos urgentes (por ejemplo, evaluaciones de modelos, resúmenes de contenido, flujos de trabajo agentes de varios pasos) |

Comience revisando con los propietarios de las aplicaciones sus patrones de uso actuales. A continuación, identifique qué cargas de trabajo necesitan respuestas inmediatas y cuáles pueden procesar datos de manera más gradual. Luego puede comenzar a enrutar una pequeña parte de su tráfico a través de diferentes niveles para probar el rendimiento y los beneficios de costos.

El Calculadora de precios de AWS le ayuda a estimar los costos de diferentes niveles de servicio ingresando la carga de trabajo esperada para cada nivel. Puede estimar su presupuesto en función de sus patrones de uso específicos.

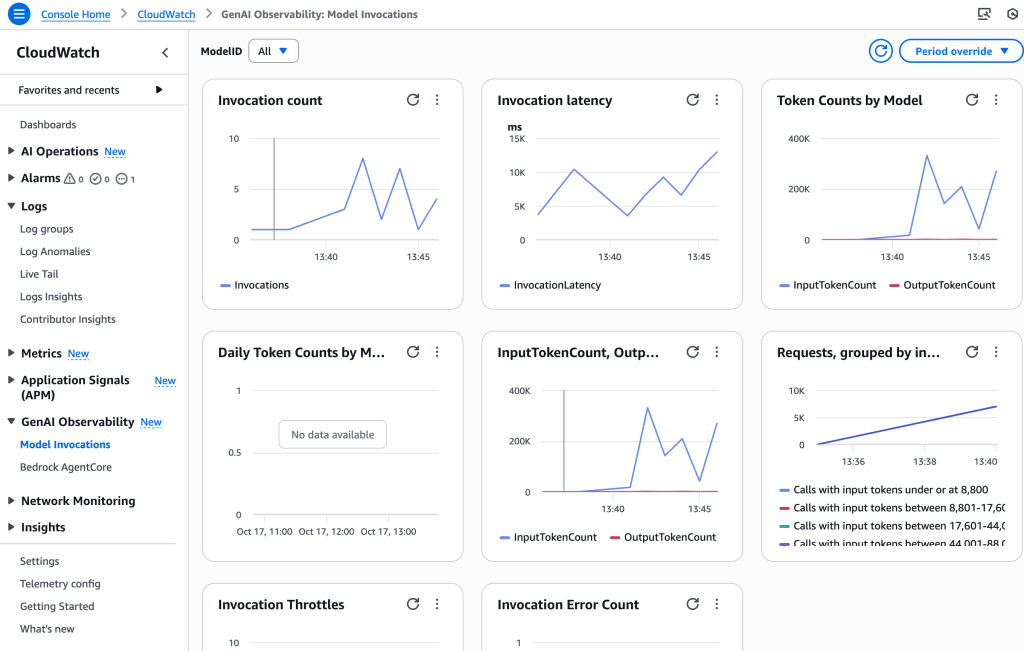

Para monitorear su uso y costos, puede utilizar la consola de cuotas de servicio de AWS o activar el registro de invocación de modelo en Amazon Bedrock y observar las métricas con Amazon CloudWatch. Estas herramientas brindan visibilidad de su uso de tokens y lo ayudan a realizar un seguimiento del rendimiento en diferentes niveles.

Puede comenzar a utilizar los nuevos niveles de servicio hoy. Usted elige el nivel por llamada API. A continuación se muestra un ejemplo utilizando el ChatCompletions API OpenAI, pero puedes pasar lo mismo service_tier parámetro en el cuerpo de InvokeModel, InvokeModelWithResponseStream, ConverseyConverseStream API (para modelos compatibles):

from openai import OpenAI

client = OpenAI(

base_url="https://bedrock-runtime.us-west-2.amazonaws.com/openai/v1",

api_key="$AWS_BEARER_TOKEN_BEDROCK" # Replace with actual API key

)

completion = client.chat.completions.create(

model= "openai.gpt-oss-20b-1:0",

messages=[

{

"role": "developer",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello!"

}

]

service_tier= "priority" # options: "priority | default | flex"

)

print(completion.choices[0].message)Para obtener más información, consulte la Guía del usuario de Amazon Bedrock o comuníquese con el equipo de su cuenta de AWS para obtener asistencia detallada con la planificación.

Espero saber cómo utiliza estas nuevas opciones de precios para optimizar sus cargas de trabajo de IA. Comparte tu experiencia conmigo en línea en las redes sociales o conéctate conmigo en eventos de AWS.