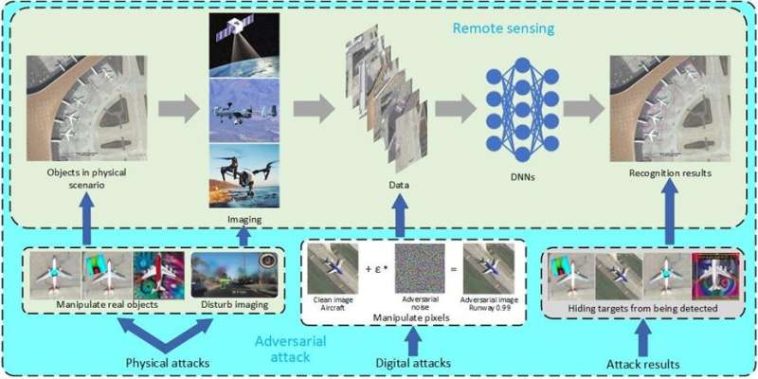

Esta figura ilustra la diferencia entre ataques digitales y físicos en el contexto de la teledetección. Se observa que: En el caso de ataques físicos, el atacante manipula los objetivos reales o el proceso de obtención de imágenes para inducir intencionalmente predicciones incorrectas; Para los ataques digitales, el atacante modifica directamente los valores de píxeles de los datos de la imagen capturados por el dispositivo de imágenes para implementar un ataque. Crédito: Jiawei Lian, Universidad Politécnica del Noroeste

Hoy en día, nuestra comprensión y evaluación de las características físicas del mundo que nos rodea depende cada vez menos de la inteligencia humana y cada vez más de la inteligencia artificial.

Las tecnologías de teledetección (RS) se han convertido en herramientas críticas para la inteligencia gubernamental, el monitoreo ambiental, el transporte autónomo, la planificación urbana y la gestión de desastres. Pero la gran cantidad de imágenes producidas por cámaras remotas debe procesarse e interpretarse, y estas tareas se delegan cada vez más a modelos de aprendizaje profundo (DL).

Los modelos DL pueden procesar e interpretar imágenes mucho más rápido que los humanos, y los avances recientes en IA no han hecho más que mejorar esta capacidad con el tiempo. A pesar de este aumento en la eficiencia, ningún estudio ha intentado evaluar la solidez general y las posibles vulnerabilidades de los modelos basados en redes neuronales profundas (DNN) utilizados para la detección de objetos y la clasificación de imágenes en imágenes RS.

Para abordar este problema, un equipo de científicos de la Universidad Politécnica Northwestern y la Universidad Politécnica de Hong Kong realizó una revisión de todos los estudios de investigación existentes sobre la solidez de los modelos DL utilizados para la detección y clasificación de objetos utilizando imágenes RS y desarrolló un punto de referencia para evaluar la rendimiento de varios detectores de modelos DL (por ejemplo, versiones YOLO, RetinaNet, FreeAnchor). Fundamentalmente, su análisis reveló varias vulnerabilidades de los algoritmos DL para la detección de objetos, que los atacantes podrían aprovechar.

el equipo publicó su reseña en el Revista de teledetección.

«Buscamos abordar la falta de estudios exhaustivos sobre la solidez de los modelos de aprendizaje profundo utilizados en tareas de detección remota, centrándonos particularmente en la clasificación de imágenes y la detección de objetos. Nuestro objetivo era comprender las vulnerabilidades de estos modelos a varios tipos de ruido, especialmente el adversario. ruido y evaluar sistemáticamente su robustez natural y adversaria», afirmó Shaohui Mei, profesor de la Escuela de Información Electrónica de la Universidad Politécnica Northwestern en Xi’an, China y autor principal del artículo de revisión.

Más concretamente, el equipo investigó los efectos del ruido natural y diversos ataques al rendimiento del modelo. Los científicos utilizaron fuentes de ruido naturales, incluidos ruidos de sal, pimienta y aleatorios, lluvia, nieve y niebla, en diferentes intensidades para probar la solidez de la detección e identificación de objetos utilizando modelos DL.

Para los ataques físicos, las perturbaciones físicas elaboradas tienen que sufrir transformaciones entre dominios, es decir, de digital a físico y de físico a digital, para realizar ataques en el mundo físico, mientras que esto es innecesario para los ataques digitales. Crédito: Jiawei Lian, Universidad Politécnica del Noroeste

El equipo también probó el rendimiento del modelo utilizando varios ataques digitales para explotar vulnerabilidades en los modelos, incluido el método de signo de gradiente rápido (FGSM), AutoAttack, descenso de gradiente proyectado, Carlini & Wagner y Momentum Iterative FGSM. También determinaron los efectos de posibles ataques físicos, en los que un parche podría pintarse físicamente o adherirse a un objeto o al fondo de un objeto para perjudicar el modelo DL.

Los investigadores encontraron muchas vulnerabilidades en los modelos DL que podrían ser explotadas por adversarios potenciales. «Los modelos de aprendizaje profundo, a pesar de sus poderosas capacidades en aplicaciones de detección remota, son susceptibles a diferentes tipos de perturbaciones, incluidos ataques adversarios. Es crucial que los desarrolladores y usuarios de estas tecnologías sean conscientes de estas vulnerabilidades y trabajen para mejorar la solidez del modelo para garantizar un rendimiento confiable en condiciones del mundo real», dijo Jiawei Lian, estudiante de posgrado en la Escuela de Información Electrónica de la Universidad Politécnica Northwestern y autor del artículo.

Para ayudar a otros investigadores a mejorar la solidez del modelo DL en estas aplicaciones, los autores resumieron los resultados de su análisis en varios modelos, tipos de ruido y ataques:

- El entrenamiento de un ataque adversario comparte muchas similitudes con el entrenamiento de una red neuronal y se ve afectado por los mismos factores que el entrenamiento de modelos, incluidos los datos de entrenamiento, los modelos de víctimas (modelos de aprendizaje profundo utilizados para generar ataques adversarios) y las estrategias de optimización.

- Es posible que los detectores débiles, como YOLOv2, solo requieran el aprendizaje de información limitada para atacar con éxito un modelo DL, pero el ataque generalmente no tendrá éxito con detectores más robustos.

- Técnicas como «impulso» y «abandono» pueden aumentar la eficacia de un ataque. La investigación de estrategias de capacitación y aumentos de pruebas podría mejorar la seguridad del modelo DNN.

- Los ataques físicos pueden ser igualmente efectivos que los ataques digitales. Las vulnerabilidades en los modelos DL deben traducirse en posibles aplicaciones del mundo real, como la adición de un parche físico para comprometer los algoritmos DL, que podrían explotar estas debilidades.

- Los investigadores pueden descubrir los mecanismos de extracción de características de los modelos DL para comprender cómo los adversarios podrían manipular e interrumpir el proceso.

- El fondo de un objeto se puede manipular para perjudicar la capacidad de un modelo DL para detectar e identificar correctamente un objeto.

- Los ataques adversarios que utilizan parches físicos en el fondo de un objetivo pueden ser más prácticos que colocar parches en los propios objetivos.

El equipo de investigación reconoce que su análisis proporciona sólo un modelo para mejorar la solidez del modelo RS DL.

«[Our] siguiente paso[s] Implica perfeccionar aún más nuestro marco de evaluación comparativa y realizar pruebas más exhaustivas con una gama más amplia de modelos y tipos de ruido. Nuestro objetivo final es contribuir al desarrollo de modelos DL más robustos y seguros para RS, mejorando así la confiabilidad y efectividad de estas tecnologías en aplicaciones críticas como monitoreo ambiental, respuesta a desastres y planificación urbana», dijo Mei.

Xiaofei Wang, Yuru Su y Mingyang Ma de la Escuela de Información Electrónica de la Universidad Politécnica del Noroeste en Xi’an, China y Lap-Pui Chau del Departamento de Ingeniería Eléctrica y Electrónica de la Universidad Politécnica de Hong Kong también contribuyeron a esta investigación.

Más información:

Shaohui Mei et al, Un estudio integral sobre la solidez de la clasificación de imágenes y la detección de objetos basadas en el aprendizaje profundo en teledetección: topografía y evaluación comparativa, Revista de teledetección (2024). DOI: 10.34133/detección remota.0219

Proporcionado por Journal of Remote Sensing

Citación: Los modelos de IA para la detección remota de objetos son vulnerables a ataques tanto físicos como digitales, según una investigación (2024, 17 de octubre) recuperado el 17 de octubre de 2024 de https://techxplore.com/news/2024-10-ai-remote-vulnerable-physical -digital.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.

GIPHY App Key not set. Please check settings