|

|

A principios de este año, nosotros previamente anunciado que los modelos de comprensión de video de Twelvelabs llegarían a Amazon Bedrock. Hoy, estamos anunciando que los modelos ahora están disponibles para buscar videos, clasificar escenas, resumir y extraer información con precisión y confiabilidad.

Twelvelabs ha introducido Marengo, un modelo de inserción de video competente para realizar tareas como la búsqueda y la clasificación, y Pegasus, un modelo de lenguaje de video que puede generar texto basado en datos de video. Estos modelos son Entrenado en Amazon Sagemaker Hyperpod Para entregar un análisis de video innovador que proporcione resúmenes de texto, generación de metadatos y optimización creativa.

Con los modelos de Twelvelabs en Amazon Bedrock, puedes encontrar momentos específicos que usan capacidades de búsqueda de video de lenguaje natural como «Muéstrame el primer touchdown del juego» o «Encuentra la escena donde los personajes principales se encuentran por primera vez» e instantáneamente saltar a esos momentos exactos. También puede crear aplicaciones para comprender el contenido de video generando texto descriptivo como títulos, temas, hashtags, resúmenes, capítulos o aspectos destacados para descubrir ideas y conexiones sin requerir etiquetas o categorías predefinidas.

Por ejemplo, puede encontrar temas recurrentes en los comentarios de los clientes o los patrones de uso del producto spot que antes no eran obvios. Ya sea que tenga cientos o miles de horas de contenido de video, ahora puede transformar toda esa biblioteca en un recurso de conocimiento de búsqueda mientras mantiene la seguridad y el rendimiento de grado empresarial.

Echemos un vistazo al Marengo y Pegaso Videos que Twelvelabs ha publicado.

Puede transformar los flujos de trabajo de video con estos modelos en todas las industrias. Los productores y editores de los medios pueden localizar instantáneamente escenas o diálogo específicos, lo que significa que puede concentrarse en la narración de cuentos en lugar de examinar horas de metraje. Los equipos de marketing están racionalizando sus flujos de trabajo publicitarios al personalizar rápidamente el contenido para resonar con varios audiencias, mientras que los equipos de seguridad están utilizando la tecnología para identificar de manera proactiva los riesgos potenciales al detectar patrones en múltiples videos.

Comenzando con modelos de Twelvelabs en Amazon Bedrock

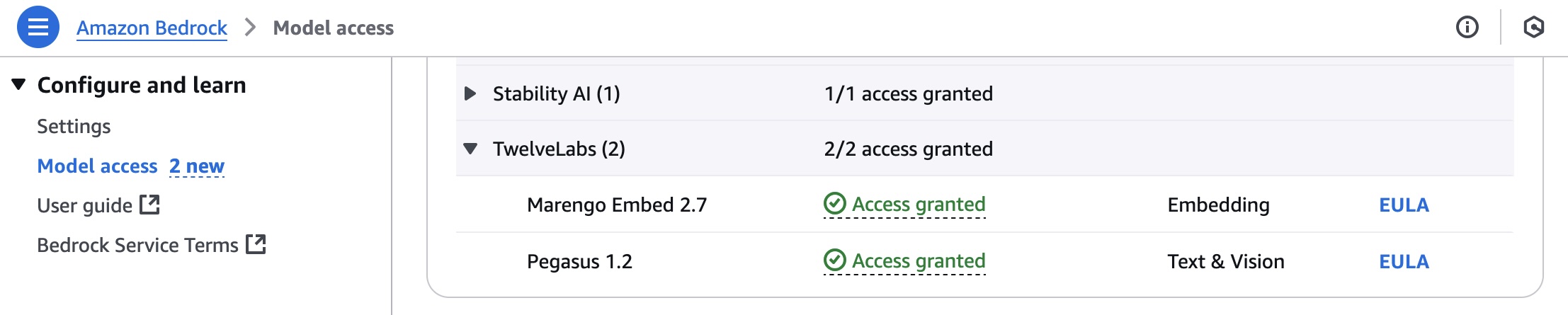

Antes de comenzar, si eres nuevo en usar modelos de Twelvelabs, vaya a la consola de rock de Amazon y elija Acceso modelo En el panel de navegación inferior izquierdo. Para acceder a los últimos modelos de Twelvelabs, solicite acceso a Marengo incrustar 2.7 o Pegaso 1.2 en Twelvelabs por regiones disponibles.

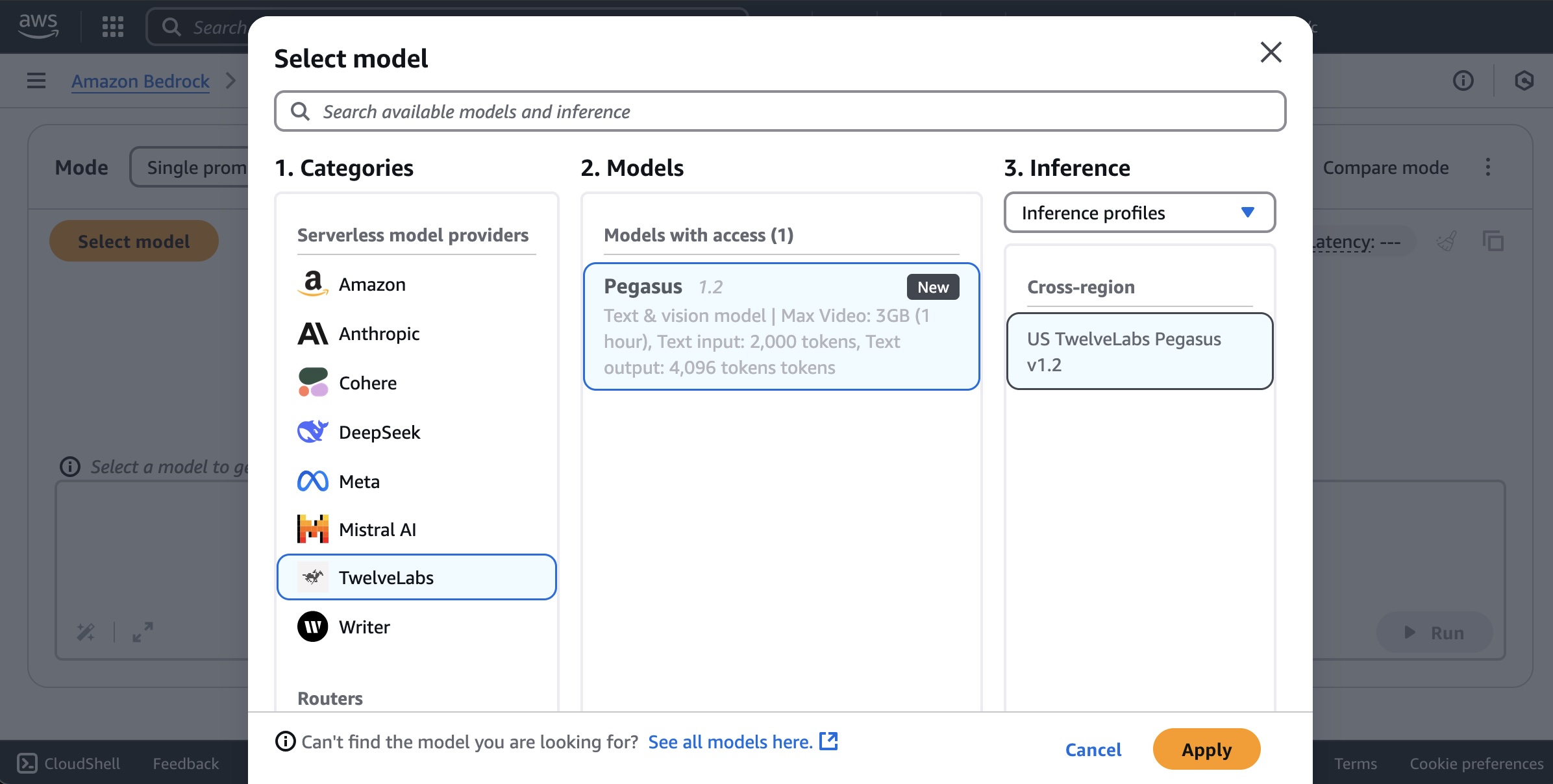

Para usar modelos Twelvelabs en Amazon Bedrock, elija Patio de recreo de chat/texto bajo Prueba En el panel de navegación izquierda. Elegir Modelo seleccionadoseleccionar Twelvelabs como la categoría y Pegaso Como modelo, y luego elige Aplicar.

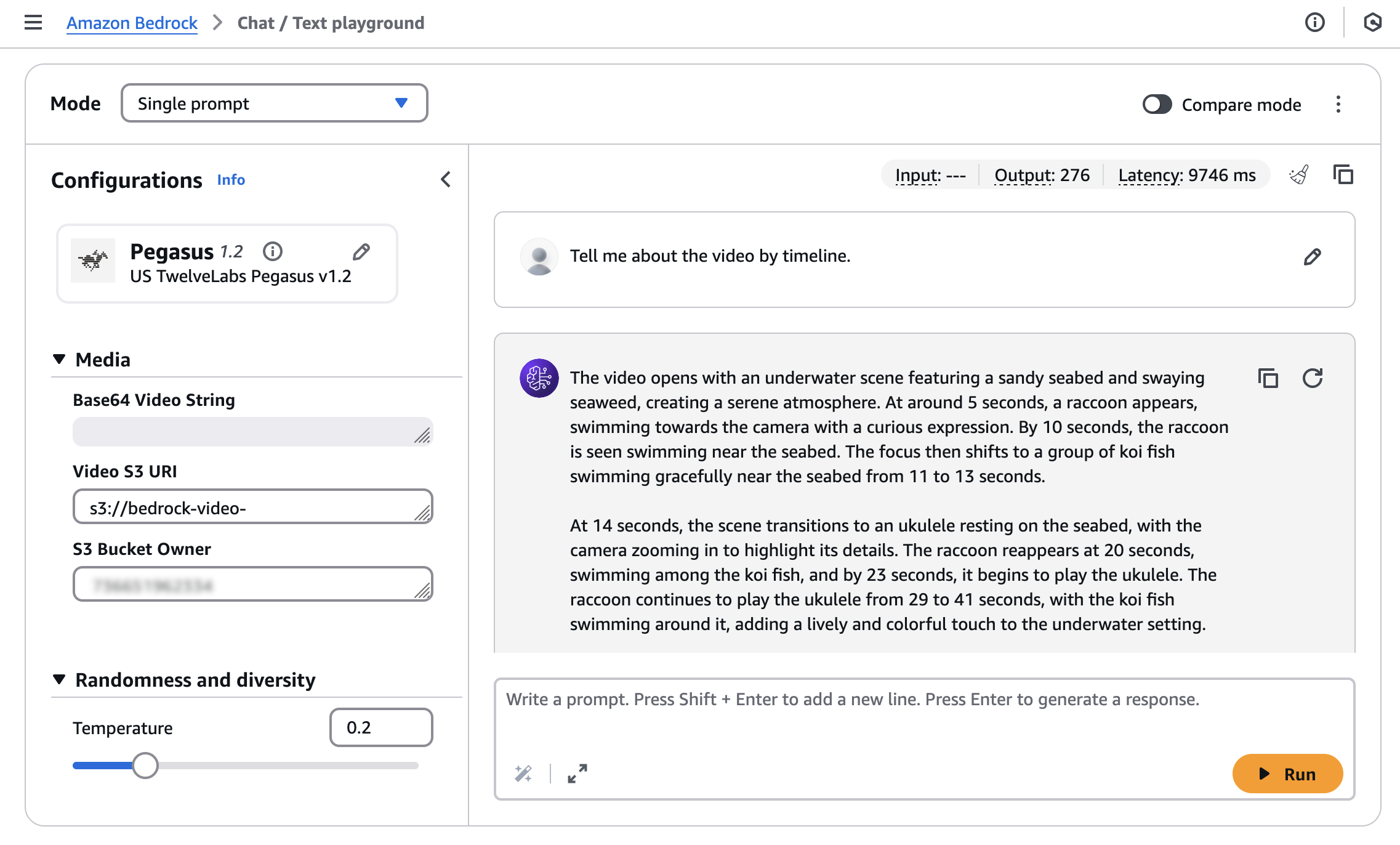

Para buscar o generar texto desde su video, debe cargar su video en un cubo de Amazon Simple Storage Service (Amazon S3) o una cadena de video de entrada en formato Base64.

Usaré un Video de muestra Generado con Amazon Nova Reel con un aviso: «Un lindo mapache tocando la guitarra bajo el agua».

Ingrese el S3 uri de su video cargado y el Propietario de S3 Buckety luego ejecute su aviso: «Cuéntame sobre el video de Timeline».

Puede obtener la siguiente respuesta al modelo:

The video opens with an underwater scene featuring a sandy seabed and swaying seaweed, creating a serene atmosphere. At around 5 seconds, a raccoon appears, swimming towards the camera with a curious expression. By 10 seconds, the raccoon is seen swimming near the seabed. The focus then shifts to a group of koi fish swimming gracefully near the seabed from 11 to 13 seconds.

At 14 seconds, the scene transitions to an ukulele resting on the seabed, with the camera zooming in to highlight its details. The raccoon reappears at 20 seconds, swimming among the koi fish, and by 23 seconds, it begins to play the ukulele. The raccoon continues to play the ukulele from 29 to 41 seconds, with the koi fish swimming around it, adding a lively and colorful touch to the underwater setting.

From 42 to 49 seconds, the raccoon is shown playing the ukulele with the koi fish swimming around it. The video concludes with a screen displaying "Video generated with Amazon Novo Reel 1.1" and "Available in Amazon Bedrock" from 50 to 54 seconds, followed by the AWS logo from 55 to 57 seconds.

Los modelos Twelvelabs se pueden integrar fácilmente en sus aplicaciones utilizando la API de Amazon Bedrock Invoke, que proporciona una interfaz unificada para interacciones de IA conversacionales.

Aquí hay un ejemplo de cómo usar el AWS SDK para Python (Boto3) con el modelo Pegasus de Twelvelabs:

import boto3

import json

import base64

AWS_REGION = "us-west-2"

MODEL_ID = "us.twelvelabs.pegasus-1-2-v1:0" # OR "eu.twelvelabs.pegasus-1-2-v1:0" if it is doing cross region inference in europe

VIDEO_PATH = "sample.mp4"

def read_file(file_path: str) -> str:

"""Read a file and return as base64 encoded string."""

try:

with open(file_path, 'rb') as file:

file_content = file.read()

return base64.b64encode(file_content).decode('utf-8')

except Exception as e:

raise Exception(f"Error reading file {file_path}: {str(e)}")

bedrock_runtime = boto3.client(

service_name="bedrock-runtime",

region_name=AWS_REGION

)

request_body = {

"inputPrompt": "tell me about the video",

"mediaSource": {

"base64String": read_file(VIDEO_PATH)

}

}

response = bedrock_runtime.invoke_model(

modelId=MODEL_ID,

body=json.dumps(request_body),

contentType="application/json",

accept="application/json"

)

response_body = json.loads(response['body'].read())

print(json.dumps(response_body, indent=2))El modelo Twelvelabs Marengo Incorpor 2.7 genera incrustaciones vectoriales a partir de entradas de video, texto, audio o imagen. Estos incrustaciones se pueden utilizar para la búsqueda de similitud, la agrupación y otras tareas de aprendizaje automático (ML). El modelo admite una inferencia asíncrona a través de la base de startasyncinvoke de roca madre.

Para la fuente de video, puede solicitar el formato JSON para el modelo Twelvelabs Marengo Inbred 2.7 usando el StartAsyncInvoke API.

{

"modelId": "twelvelabs.marengo-embed-2-7-v1:0",

"modelInput": {

"inputType": "video",

"mediaSource": {

"s3Location": {

"uri": "s3://your-video-object-s3-path",

"bucketOwner": "your-video-object-s3-bucket-owner-account"

}

}

},

"outputDataConfig": {

"s3OutputDataConfig": {

"s3Uri": "s3://your-bucket-name"

}

}

}Puede obtener una respuesta entregada a la ubicación S3 especificada.

{

"embedding": [0.345, -0.678, 0.901, ...],

"embeddingOption": "visual-text",

"startSec": 0.0,

"endSec": 5.0

}Para ayudarlo a comenzar, consulte una amplia gama de ejemplos de código para múltiples casos de uso y una variedad de lenguajes de programación. Para obtener más información, visite Twelvelabs Pegasus 1.2 y Twelvelabs Marengo incrustan 2.7 en la documentación de AWS.

Ahora disponible

Los modelos de Twelvelabs generalmente están disponibles hoy en Amazon Bedrock: el modelo Marengo en el este de los EE. UU. (N. Virginia), Europa (Irlanda) y la región de Asia Pacífico (Seúl), y el modelo Pegaso en el Oeste de los Estados Unidos (Oregón) y la región de Europa (Irlanda) accesible con la inferencia de la región cruzada de las regiones de EE. UU. Y Europa. Consulte la lista de región completa para obtener actualizaciones futuras. Para obtener más información, visite la página de productos Twelvelabs en Amazon Bedrock y la página de precios de Amazon Bedrock.

Pruebe los modelos de Twelvelabs en la consola Bedrock de Amazon hoy y envíe comentarios a AWS Re: Publicación para Amazon Bedrock o a través de sus contactos habituales de soporte de AWS.

– Canal

Actualizado el 16 de julio de 2025: revisó las capturas de pantalla y la parte del código.