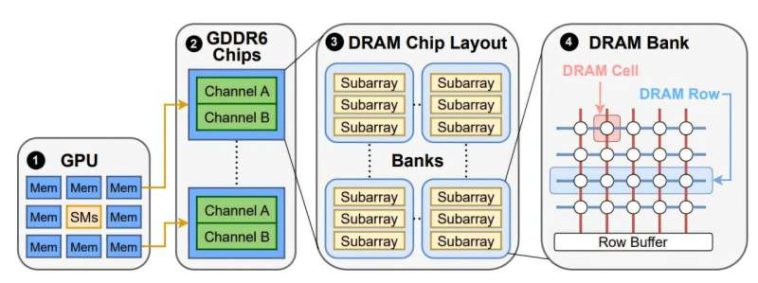

Organización GDDR6 DRAM. Crédito: https://gururaj-s.github.io/assets/pdf/sec25_gpuhammer.pdf

Un equipo de informáticos de la Universidad de Toronto descubrió recientemente que un cierto tipo de ataque de hardware es efectivo contra las unidades de procesamiento de gráficos (GPU), los motores informáticos centrales que alimentan los modelos de inteligencia artificial de hoy y los servicios de aprendizaje automático basados en la nube.

Los investigadores encontraron que un ataque de Rowhammer, previamente conocido por afectar la memoria en las unidades de procesamiento central (CPU), también es efectivo con las GPU equipadas con la memoria de la velocidad de datos dobles gráficos (GDDR). GDDR está diseñado para la transferencia de datos de alta velocidad y se encuentra comúnmente en tarjetas gráficas.

Un ataque exitoso a los modelos de IA que ejecutan GPUS podría resultar en un «daño cerebral catastrófico» con una precisión del modelo que se desploma del 80% al 0.1%, dice Gururaj Saileshwar, profesor asistente en el Departamento de Ciencias de la Computación en la Facultad de Artes y Ciencias.

Tal degradación podría tener graves consecuencias para las aplicaciones de IA que dependen de esos modelos, desde el análisis de imágenes médicas en hospitales hasta sistemas de detección de fraude en los bancos.

En un ataque de Rowhammer, las células de la memoria se manipulan en brocas de volteo (piezas de datos) al acceder rápidamente a filas adyacentes de células una y otra vez. Esto causa interferencia eléctrica que conduce a errores en las regiones de memoria al que el atacante no ha accedido directamente, lo que potencialmente les permite evitar la seguridad o tomar el control de un sistema.

«Tradicionalmente, se ha pensado en la seguridad en la capa de software, pero estamos viendo cada vez más efectos físicos en la capa de hardware que se pueden aprovechar como vulnerabilidades», dice Saileshwar, quien está decendido al Departamento de Ingeniería Eléctrica e Informática de Edward S. Rogers.

Trabajando con Ph.D. Estudiante Chris (Shaopeng) Lin y estudiante universitario de informática de cuarto año Joyce Qu, Saireshwar desarrolló una prueba de concepto Ataque de gpuhammer Dirigido a la memoria GDDR6 en un NVIDIA RTX A6000, una GPU ampliamente utilizada para la computación de alto rendimiento. Descubrieron que un solo volteo para alterar el exponente del peso de un modelo de IA podría causar una reducción masiva en la precisión del modelo.

«Esto presenta una nueva forma en que los modelos de IA pueden fallar en el nivel de hardware», dijo Saqueshwar, quien es coautor un papel con Lin y Qu que fue aceptado para Simposio de seguridad de USENIX 2025celebrado del 13 al 15 de agosto en Seattle.

Los usuarios de GPU más en riesgo son aquellos que administran entornos de computación en la nube, no a los usuarios de hogares u oficina individuales. En la configuración de la nube, varios usuarios pueden acceder a la misma GPU simultáneamente, lo que permite que un atacante manipule el procesamiento de datos de otro usuario.

Saileshwar señala que los investigadores tuvieron que explicar las diferencias clave entre la CPU y la memoria de GPU. Las GPU son más difíciles de orientar debido a sus tasas de actualización de memoria más rápidas, latencia de memoria más lenta y otras diferencias arquitectónicas. En última instancia, los investigadores aprovecharon el paralelismo de la GPU, su capacidad para ejecutar múltiples operaciones simultáneamente, para optimizar sus patrones de martilleo. Este ajuste condujo a los flips de bit que demostraron un ataque exitoso.

No fue fácil. «Hamming en GPU es como martillar a ciegas», dice Saileshwar, y señala que el equipo casi se rindió después de repetidas fallas para activar cualquier flips de bits.

En las CPU, los investigadores pueden usar herramientas para inspeccionar la interfaz de memoria y comprender cómo se comportan los acceso a la memoria y cómo se envían las instrucciones de la CPU a la memoria. Pero debido a que los chips de memoria de GPU se soldan directamente en la placa de la GPU, no hay una manera fácil de realizar inspecciones similares, dice Saileshwar. La única señal que observó el equipo fue la eventual flips de bits.

A principios de este año, los investigadores revelaron en privado sus hallazgos al gigante de GPU Nvidia, ahora la compañía más valiosa del mundo. En julio, la empresa estadounidense emitió un aviso de seguridad a sus clientes.

El remedio sugerido de NVIDIA es habilitar una característica llamada Código de corrección de errores (ECC), que puede repeler un ataque GPUHammer. Sin embargo, los investigadores encontraron que el remedio ralentiza las tareas de aprendizaje automático hasta en un 10%. También advirtieron que los ataques futuros que involucran más volteos de bits podrían abrumar incluso las protecciones del ECC.

Los hallazgos subrayan la necesidad de una mayor atención a la seguridad de GPU, un área donde Saireshwar dice que el trabajo está «apenas comenzando».

«Más investigación probablemente revelará más problemas. Y eso es importante, porque estamos ejecutando cargas de trabajo increíblemente valiosas en las GPU. Los modelos de IA se están utilizando en entornos del mundo real, como la atención médica, las finanzas y la ciberseguridad. Si hay vulnerabilidades que permiten a los atacantes a tambalearse con esos modelos a nivel de hardware, necesitamos encontrarlos antes de que estén explotados». «.

Más información:

GPUHammer: los ataques de Rowhammer en los recuerdos de GPU son prácticos. gururaj-s.github.io/assets/pdf/sec25_gpuhammer.pdf

Citación: Los investigadores descubren una vulnerabilidad de GPU que podría amenazar los modelos AI (2025, 4 de septiembre) recuperado el 4 de septiembre de 2025 de https://techxplore.com/news/2025-09-gpu-vulnerability-threaten-ai.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.