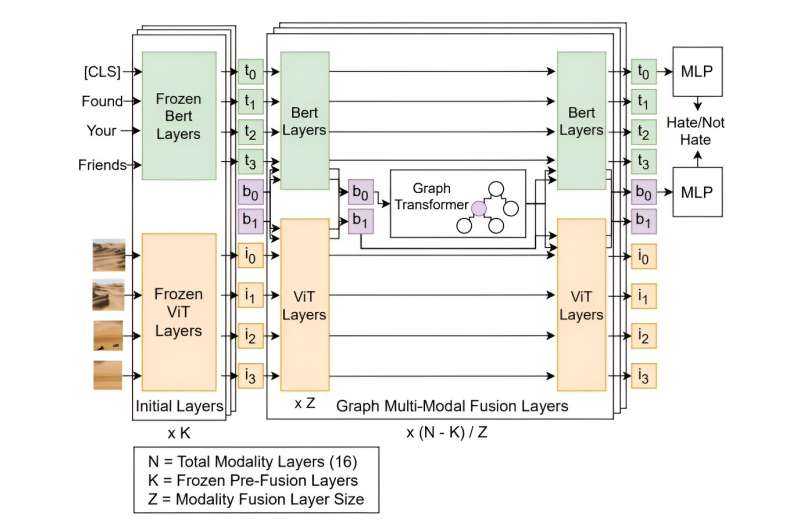

Transformador de discusión multimodal. Crédito: arXiv (2023). DOI: 10.48550/arxiv.2307.09312

Un equipo de investigadores de la Universidad de Waterloo ha desarrollado un nuevo método de aprendizaje automático que detecta el discurso de odio en las plataformas de redes sociales con un 88% de precisión, ahorrando a los empleados cientos de horas de trabajo emocionalmente dañino.

El método, denominado transformador de discusión multimodal (mDT), puede comprender la relación entre texto e imágenes, así como poner los comentarios en un mayor contexto, a diferencia de los métodos anteriores de detección de discursos de odio. Esto es particularmente útil para reducir los falsos positivos, que a menudo se marcan incorrectamente como discurso de odio debido a un lenguaje culturalmente sensible.

«Realmente esperamos que esta tecnología pueda ayudar a reducir el costo emocional de hacer que los humanos examinen manualmente el discurso de odio», dijo Liam Hebert, Ph.D. en informática de Waterloo. estudiante y primer autor del estudio. «Creemos que al adoptar un enfoque centrado en la comunidad en nuestras aplicaciones de IA, podemos ayudar a crear espacios en línea más seguros para todos».

Los investigadores han estado construyendo modelos para analizar el significado de las conversaciones humanas durante muchos años, pero históricamente estos modelos han tenido dificultades para comprender conversaciones matizadas o declaraciones contextuales. Los modelos anteriores solo han podido identificar el discurso de odio con hasta un 74% de precisión, menos de lo que pudo lograr la investigación de Waterloo.

«El contexto es muy importante a la hora de entender el discurso de odio», dijo Hebert. «Por ejemplo, el comentario ‘¡Eso es asqueroso!’ Puede ser inocuo por sí solo, pero su significado cambia dramáticamente si es en respuesta a una foto de pizza con piña versus una persona de un grupo marginado.

«Comprender esa distinción es fácil para los humanos, pero entrenar un modelo para que comprenda las conexiones contextuales en una discusión, incluyendo la consideración de las imágenes y otros elementos multimedia dentro de ellas, es en realidad un problema muy difícil».

A diferencia de esfuerzos anteriores, el equipo de Waterloo construyó y entrenó su modelo en un conjunto de datos que consta no solo de comentarios de odio aislados sino también del contexto de esos comentarios. El modelo se entrenó en 8.266 debates de Reddit con 18.359 comentarios etiquetados de 850 comunidades.

«Más de tres mil millones de personas utilizan las redes sociales todos los días», afirmó Hebert. «El impacto de estas plataformas de redes sociales ha alcanzado niveles sin precedentes. Existe una enorme necesidad de detectar el discurso de odio a gran escala para construir espacios donde todos sean respetados y seguros».

Los hallazgos son publicado sobre el arXiv servidor de preimpresión.

Más información:

Liam Hebert et al, Transformador de discusión multimodal: integración de transformadores de texto, imágenes y gráficos para detectar el discurso de odio en las redes sociales, arXiv (2023). DOI: 10.48550/arxiv.2307.09312

Citación: Los investigadores construyen IA para salvar a los humanos del costo emocional que supone monitorear el discurso de odio (29 de mayo de 2024), obtenido el 29 de mayo de 2024 de https://techxplore.com/news/2024-05-ai-humans-emotional-toll-speech. HTML

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.

GIPHY App Key not set. Please check settings