Como si los defensores de las cadenas de suministro de software no tuvieran suficientes vectores de ataque de los que preocuparse, ahora tienen uno nuevo: los modelos de aprendizaje automático.

Los modelos ML están en el corazón de tecnologías como el reconocimiento facial y los chatbots. Al igual que los repositorios de software de código abierto, los desarrolladores y científicos de datos a menudo descargan y comparten los modelos, por lo que un modelo comprometido podría tener un impacto aplastante en muchas organizaciones simultáneamente.

Investigadores de HiddenLayer, una empresa de seguridad de lenguaje de máquina, revelaron en un Blog el martes cómo un atacante podría usar un modelo ML popular para implementar ransomware.

El método descrito por los investigadores es similar a cómo los piratas informáticos usan la esteganografía para ocultar cargas maliciosas en imágenes. En el caso del modelo ML, el código malicioso está oculto en los datos del modelo.

Según los investigadores, el proceso de esteganografía es bastante genérico y se puede aplicar a la mayoría de las bibliotecas de ML. Agregaron que el proceso no necesita limitarse a incrustar código malicioso en el modelo y también podría usarse para extraer datos de una organización.

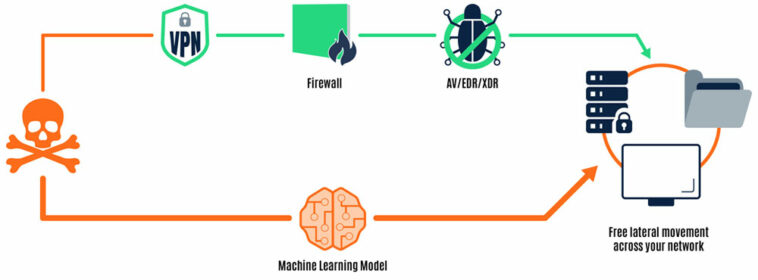

Imagen cortesía de HiddenLayer

Los ataques también pueden ser independientes del sistema operativo. Los investigadores explicaron que las cargas útiles específicas de la arquitectura y el sistema operativo podrían integrarse en el modelo, donde pueden cargarse dinámicamente en tiempo de ejecución, según la plataforma.

Volando bajo el radar

Incrustar malware en un modelo ML ofrece algunos beneficios para un adversario, observó Tom Bonner, director sénior de investigación de amenazas adversarias en HiddenLayer, con sede en Austin, Texas.

“Les permite volar por debajo del radar”, dijo Bonner a TechNewsWorld. “No es una técnica que sea detectada por el software antivirus o EDR actual”.

“También abre nuevos objetivos para ellos”, dijo. “Es una ruta directa a los sistemas de científicos de datos. Es posible subvertir un modelo de aprendizaje automático alojado en un repositorio público. Los científicos de datos lo bajarán y lo cargarán, luego se verán comprometidos”.

“Estos modelos también se descargan en varias plataformas de operaciones de aprendizaje automático, lo que puede dar bastante miedo porque pueden tener acceso a depósitos de Amazon S3 y robar datos de entrenamiento”, continuó.

«La mayoría de [the] las máquinas que ejecutan modelos de aprendizaje automático tienen GPU grandes y gruesas, por lo que los mineros de bitcoin también podrían ser muy efectivos en esos sistemas”, agregó.

HiddenLayer demuestra cómo su modelo ResNet preentrenado secuestrado ejecutó una muestra de ransomware en el momento en que PyTorch lo cargó en la memoria en su máquina de prueba.

Ventaja de primer movimiento

A los actores de amenazas a menudo les gusta explotar vulnerabilidades imprevistas en nuevas tecnologías, señaló Chris Clements, vicepresidente de arquitectura de soluciones en Centinela Cerberouna empresa de consultoría de seguridad cibernética y pruebas de penetración en Scottsdale, Arizona.

“Los atacantes que buscan una ventaja pionera en estas fronteras pueden disfrutar tanto de una menor preparación como de una protección proactiva frente a la explotación de nuevas tecnologías”, dijo Clements a TechNewsWorld.

“Este ataque a los modelos de lenguaje de máquina parece ser el siguiente paso en el juego del gato y el ratón entre atacantes y defensores”, dijo.

Mike Parkin, ingeniero técnico sénior de Vulcano cibernéticoun proveedor de SaaS para la remediación de riesgos cibernéticos empresariales en Tel Aviv, Israel, señaló que los actores de amenazas aprovecharán todos los vectores que puedan para ejecutar sus ataques.

«Este es un vector inusual que podría escabullirse de bastantes herramientas comunes si se hace con cuidado», dijo Parkin a TechNewsWorld.

Las soluciones tradicionales de detección y respuesta antimalware y de punto final están diseñadas para detectar ransomware en función de comportamientos basados en patrones, incluidas firmas de virus y monitoreo de API clave, archivos y solicitudes de registro en Windows para detectar posibles actividades maliciosas, explicó Morey Haber, director de seguridad de Más allá de la confianzaun fabricante de soluciones de administración de cuentas privilegiadas y administración de vulnerabilidades en Carlsbad, California.

“Si el aprendizaje automático se aplica a la entrega de malware como ransomware, entonces los vectores de ataque tradicionales e incluso los métodos de detección pueden modificarse para que parezcan no maliciosos”, dijo Haber a TechNewsWorld.

Potencial de daños generalizados

Los ataques a los modelos de lenguaje de máquina van en aumento, señaló Karen Crowley, directora de soluciones de productos de instinto profundouna empresa de ciberseguridad de aprendizaje profundo en la ciudad de Nueva York.

«Todavía no es significativo, pero existe la posibilidad de un daño generalizado», dijo Crowley a TechNewsWorld.

“En la cadena de suministro, si se envenenan los datos de manera que cuando se entrena a los modelos, se envenena también el sistema, ese modelo podría estar tomando decisiones que reduzcan la seguridad en lugar de fortalecerla”, explicó.

“En los casos de Log4j y SolarWinds, vimos el impacto no solo en la organización propietaria del software, sino en todos sus usuarios en esa cadena”, dijo. “Una vez que se introduzca ML, ese daño podría multiplicarse rápidamente”.

Casey Ellis, CTO y fundador de Multitud de bichosque opera una plataforma de recompensas de errores de colaboración colectiva, señaló que los ataques a los modelos ML podrían ser parte de una tendencia más amplia de ataques a las cadenas de suministro de software.

“De la misma manera que los adversarios pueden intentar comprometer la cadena de suministro de aplicaciones de software para insertar códigos maliciosos o vulnerabilidades, también pueden apuntar a la cadena de suministro de modelos de aprendizaje automático para insertar datos o algoritmos maliciosos o sesgados”, dijo Ellis a TechNewsWorld.

“Esto puede tener un impacto significativo en la confiabilidad e integridad de los sistemas de IA y puede usarse para socavar la confianza en la tecnología”, dijo.

Pablum para Script Kiddies

Los actores de amenazas pueden estar mostrando un mayor interés en los modelos de máquinas porque son más vulnerables de lo que la gente pensaba que eran.

“La gente sabía que esto era posible desde hace algún tiempo, pero no se dieron cuenta de lo fácil que es”, dijo Bonner. «Es bastante trivial encadenar un ataque con unos pocos scripts simples».

“Ahora que la gente se da cuenta de lo fácil que es, está en el ámbito de los script kiddies lograrlo”, agregó.

Clements estuvo de acuerdo en que los investigadores han demostrado que no se requiere una gran experiencia en ciencia de datos de ML/IA para insertar comandos maliciosos en los datos de entrenamiento que luego pueden ser activados por modelos de ML en tiempo de ejecución.

Sin embargo, continuó, requiere más sofisticación que los ataques de ransomware comunes y corrientes que se basan principalmente en el simple relleno de credenciales o phishing para lanzar.

“En este momento, creo que es probable que la popularidad del vector de ataque específico sea baja en el futuro previsible”, dijo.

“Explotar esto requiere que un atacante comprometa un proyecto de modelo de ML ascendente utilizado por desarrolladores posteriores, engañando a la víctima para que descargue un modelo de ML previamente entrenado con los comandos maliciosos incrustados de una fuente no oficial, o comprometiendo el conjunto de datos privado utilizado por los desarrolladores de ML para insertar el explota”, explicó.

«En cada uno de estos escenarios», continuó, «parece que habría formas mucho más fáciles y directas de comprometer el objetivo además de insertar exploits ofuscados en los datos de entrenamiento».