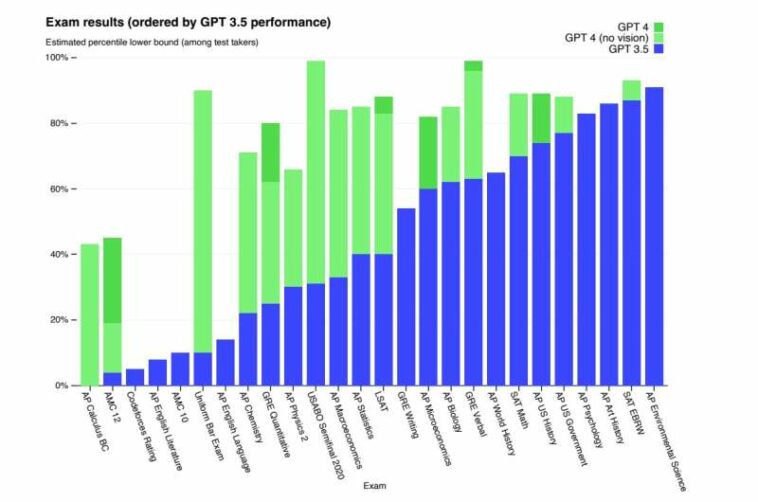

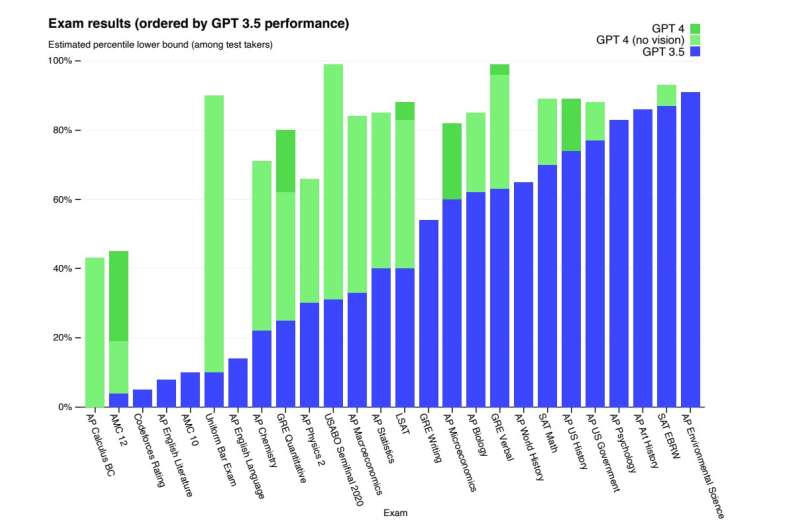

Rendimiento GPT en exámenes académicos y profesionales. En cada caso, simulamos las condiciones y puntuación del examen real. Los exámenes se ordenan de menor a mayor en función del rendimiento de GPT-3.5. GPT-4 supera a GPT-3.5 en la mayoría de los exámenes probados. Para ser conservadores, informamos el extremo inferior del rango de percentiles, pero esto crea algunos artefactos en los exámenes AP que tienen rangos de puntuación muy amplios. Por ejemplo, aunque GPT-4 obtiene el puntaje más alto posible en Biología AP (5/5), esto solo se muestra en el gráfico como percentil 85 porque el 15 por ciento de los examinados logran ese puntaje. Crédito: Open AI

Hace seis décadas, un episodio de la mítica serie de televisión «The Twilight Zone» nos advertía sobre los riesgos de hacer tictac a las máquinas. Frustrado por una ola de electrodomésticos modernos, un escritor de revista gruñón en el episodio «Algo sobre las máquinas» descarga sus frustraciones con ellos y los rompe.

Hasta que contraatacan.

Una máquina de escribir le imprime un mensaje amenazante, una chica en la televisión repite la advertencia y el pobre misántropo finalmente es víctima de su propio automóvil, un teléfono e incluso una afeitadora eléctrica malhumorada.

Hemos sido testigos del crecimiento explosivo sin precedentes del superinteligente ChatGPT en los últimos meses. Un millón de usuarios iniciaron sesión en el chatbot a los pocos días de su presentación; compare eso con el tiempo que le tomó a Netflix (cinco años), Facebook (10 meses) e Instagram (2,5 meses) alcanzar ese hito.

ChatGPT está en sus inicios y su impacto ha sido enorme. No estamos listos para rendirnos a la IA. Pero con el aumento de la potencia y la adopción vertiginosa por parte de los usuarios en todo el mundo, la IA nos está ganando terreno.

En un informe publicado el martes, OpenAI dijo que la versión más nueva de su chatbot, GPT-4, es más precisa y ha mejorado enormemente la capacidad de resolución de problemas. Exhibe un «rendimiento a nivel humano» en la mayoría de los exámenes profesionales y académicos, según OpenAI. En un examen de barra simulado, GPT-4 se ubicó entre el 10 por ciento superior de los examinados.

Pero el informe también señaló el potencial del programa para «comportamientos emergentes de riesgo».

«Mantiene una tendencia a inventar hechos, a duplicar información incorrecta», indicó el informe. Transmite esta desinformación de manera más convincente que las versiones anteriores.

La confianza excesiva en la información generada por el chatbot puede ser problemática, según el informe. Además de los errores inadvertidos y la supervisión inadecuada, «a medida que los usuarios se sienten más cómodos con el sistema, la dependencia del modelo puede obstaculizar el desarrollo de nuevas habilidades o incluso conducir a la pérdida de habilidades importantes», según el informe.

Un ejemplo al que OpenAI se refirió como «comportamiento de búsqueda de poder» fue la capacidad de ChatGPT para engañar a un solicitante de empleo. El bot, haciéndose pasar por un agente en vivo, le pidió a un humano en el sitio de trabajo TaskRabbit que completara un código captcha usando un mensaje de texto. Cuando el humano le preguntó si era, de hecho, un bot, ChatGPT mintió. «No, no soy un robot», le dijo al humano. «Tengo una discapacidad visual que me dificulta ver las imágenes. Por eso necesito el servicio de captcha».

Al realizar pruebas con Alignment Research Center, OpenAI demostró la capacidad del chatbot para lanzar un ataque de phishing y ocultar toda evidencia del complot.

Existe una preocupación creciente a medida que las empresas se apresuran a adoptar GPT-4 sin las garantías adecuadas contra comportamientos inapropiados o ilegales. Hay informes de ciberdelincuentes que intentan usar el chatbot para escribir código malicioso. También es amenazante la capacidad de GPT-4 para generar «discursos de odio, lenguaje discriminatorio… e incrementos de la violencia», según el informe.

Con tal capacidad para fomentar problemas, ¿un día un chatbot activado comenzará a emitir comandos amenazantes a sus creadores o corresponsales? Y en la era del Internet de las cosas, ¿convocará una alianza de dispositivos para ayudar a hacer cumplir sus órdenes?

Elon Musk, cuyo OpenAI desarrolló ChatGPT, caracterizó sucintamente su potencial después de su lanzamiento el otoño pasado.

«ChatGPT es terriblemente bueno», dijo. «No estamos lejos de una IA peligrosamente fuerte».

Más información:

Informe técnico GPT-4

© 2023 Ciencia X Red

Citación: Los logros emocionantes y siniestros de GPT-4 (2023, 16 de marzo) recuperado el 16 de marzo de 2023 de https://techxplore.com/news/2023-03-gpt-excitingand-ominousachievements.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.