|

|

Las nuevas instancias Trn2 de Amazon Elastic Compute Cloud (Amazon EC2) y Trn2 UltraServers son las opciones informáticas EC2 más poderosas para el entrenamiento e inferencia de ML. Impulsadas por la segunda generación de chips AWS Trainium (AWS Trainium2), las instancias Trn2 son 4 veces más rápidas, ofrecen 4 veces más ancho de banda de memoria y 3 veces más capacidad de memoria que las instancias Trn1 de primera generación. Las instancias Trn2 ofrecen un rendimiento de precio entre un 30% y un 40% mejor que la generación actual de instancias EC2 P5e y P5en basadas en GPU.

Además de los 16 chips Trainium2, cada instancia de Trn2 cuenta con 192 vCPU, 2 TiB de memoria y 3,2 Tbps de ancho de banda de red Elastic Fabric Adapter (EFA) v3, que ofrece una latencia hasta un 50 % menor que la generación anterior.

Los Trn2 UltraServers, que son una oferta informática completamente nueva, cuentan con chips Trainium2 64x conectados con una interconexión NeuronLink de baja latencia y alto ancho de banda, para lograr el máximo rendimiento de inferencia y entrenamiento en modelos básicos de frontera.

Decenas de miles de chips Trainium ya están impulsando los servicios de Amazon y AWS. Por ejemplo, más de 80.000 chips AWS Inferentia y Trainium1 respaldaron al asistente de compras Rufus en el Prime Day más reciente. Los chips Trainium2 ya están impulsando las versiones con latencia optimizada de Llama 3.1 405B y Claude 3.5 Haiku modelos en Amazon Bedrock.

Arriba y afuera y arriba

El crecimiento sostenido en el tamaño y la complejidad de los modelos de frontera es posible gracias a formas innovadoras de potencia informática, ensambladas en formas arquitectónicas igualmente innovadoras. En tiempos más simples, podríamos hablar de arquitectura para la escalabilidad de dos maneras: escalando (usando una computadora más grande) y escalando (usando más computadoras). Hoy, cuando miro el chip Trainium2, la instancia Trn2 y las ofertas informáticas aún más grandes de las que hablaré en un minuto, parece que ambos modelos se aplican, pero en diferentes niveles de la jerarquía general. Repasemos los bloques de construcción de Trn2, comenzando en NeuronCore y escalando a un UltraCluster:

Núcleos neuronales están en el corazón del chip Trainium2. Cada NeuronCore de tercera generación incluye un motor escalar (1 entrada a 1 salida), un motor vectorial (múltiples entradas a múltiples salidas), un motor tensor (multiplicación, convolución y transposición de matrices sistólicas) y un GPSIMD (instrucción única de propósito general). múltiples datos) núcleo.

Núcleos neuronales están en el corazón del chip Trainium2. Cada NeuronCore de tercera generación incluye un motor escalar (1 entrada a 1 salida), un motor vectorial (múltiples entradas a múltiples salidas), un motor tensor (multiplicación, convolución y transposición de matrices sistólicas) y un GPSIMD (instrucción única de propósito general). múltiples datos) núcleo.

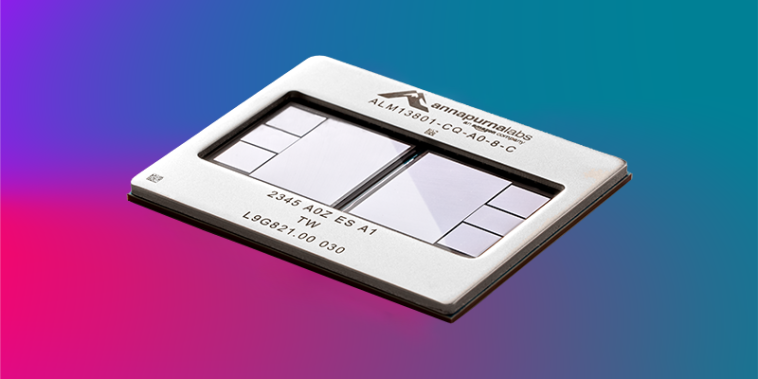

Cada trenio2 El chip alberga ocho NeuronCores y 96 GiB de memoria de alto ancho de banda (HBM), y admite 2,9 TB/segundo de ancho de banda HBM. Los núcleos se pueden direccionar y utilizar individualmente, o se pueden agrupar pares de núcleos físicos en un único núcleo lógico. Un solo chip Trainium2 ofrece hasta 1,3 petaflops de cómputo FP8 denso y hasta 5,2 petaflops de cómputo FP8 disperso, y puede impulsar una utilización del 95 % del ancho de banda de la memoria gracias a la reordenación automatizada de la cola de HBM.

Cada Trn2 Esta instancia alberga, a su vez, 16 chips Trainum2. Eso es un total de 128 NeuronCores, 1,5 TiB de HBM y 46 TB/segundo de ancho de banda de HBM. En total, esto se multiplica hasta 20,8 petaflops de computación densa del FP8 y hasta 83,2 petaflops de computación escasa del FP8. Los chips Trainium2 están conectados a través de NeuronLink en un toro 2D para una comunicación de chip a chip de alto ancho de banda y baja latencia a 1 GB/segundo.

Un Ultraservidor alberga cuatro instancias Trn2 conectadas con NeuronLink de baja latencia y gran ancho de banda. Eso es 512 NeuronCores, 64 chips Trainium2, 6 TiB de HBM y 185 TB/segundo de ancho de banda de HBM. Haciendo los cálculos, esto da como resultado hasta 83 petaflops de cómputo FP denso y hasta 332 petaflops de cómputo FP8 disperso. Además del toro 2D que conecta los NeuronCores dentro de una instancia, los núcleos en las posiciones XY correspondientes en cada una de las cuatro instancias están conectados en un anillo. Por inferencia, los UltraServers ayudan a ofrecer un tiempo de respuesta líder en la industria para crear las mejores experiencias en tiempo real. Para la capacitación, los UltraServers aumentan la velocidad y la eficiencia de la capacitación del modelo con una comunicación colectiva más rápida para el paralelismo del modelo en comparación con las instancias independientes. Los UltraServers están diseñados para respaldar la capacitación y la inferencia en el nivel de un billón de parámetros y más allá; están disponibles en forma de vista previa y usted puede contáctanos para unirse a la vista previa.

Se están implementando instancias Trn2 y UltraServers en EC2 Ultracúmulos para permitir una capacitación distribuida escalable en decenas de miles de chips Trainium en una única red sin bloqueo a escala de petabit, con acceso a Amazon FSx para almacenamiento de alto rendimiento Lustre.

Usando instancias Trn2

Las instancias Trn2 están disponibles hoy para uso de producción en la región de AWS Este de EE. UU. (Ohio) y se pueden reservar mediante bloques de capacidad de Amazon EC2 para aprendizaje automático. Puede reservar hasta 64 instancias por hasta seis meses, y se aceptan reservas con hasta ocho semanas de anticipación, con horarios de inicio instantáneos y la posibilidad de extender sus reservas si es necesario. Para obtener más información, lea Anuncio de bloques de capacidad de Amazon EC2 para ML para reservar capacidad de GPU para sus cargas de trabajo de aprendizaje automático.

En el lado del software, puede comenzar con las AMI de aprendizaje profundo de AWS. Estas imágenes están preconfiguradas con los marcos y herramientas que probablemente ya conozca y utilice: PyTorch, jaxy mucho más.

Si usaste el SDK de neuronas de AWS Para crear sus aplicaciones, puede traerlas y recompilarlas para usarlas en instancias Trn2. Este SDK se integra de forma nativa con JAX, PyTorch y bibliotecas esenciales como Hugging Face, PyTorch Lightning y NeMo. Neuron incluye optimizaciones listas para usar para capacitación e inferencia distribuidas con las bibliotecas de código abierto PyTorch NxD Training y NxD Inference, al tiempo que proporciona información detallada para la creación de perfiles y la depuración. Neuron también es compatible con OpenXLA, incluidos HLO estable y GSPMD, lo que permite a los desarrolladores de PyTorch/XLA y JAX utilizar las optimizaciones del compilador de Neuron para Trainium2.

— jeff;

GIPHY App Key not set. Please check settings