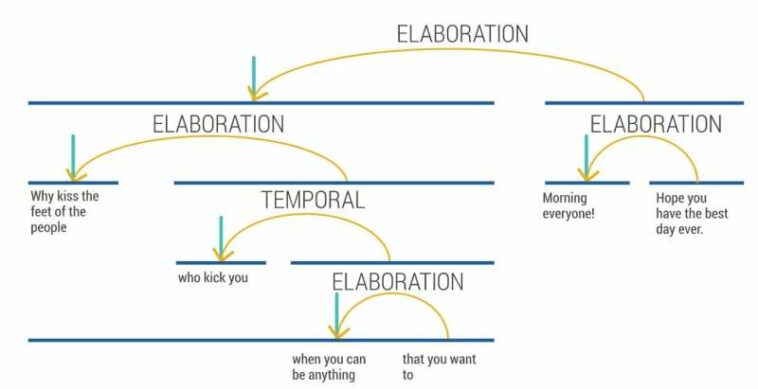

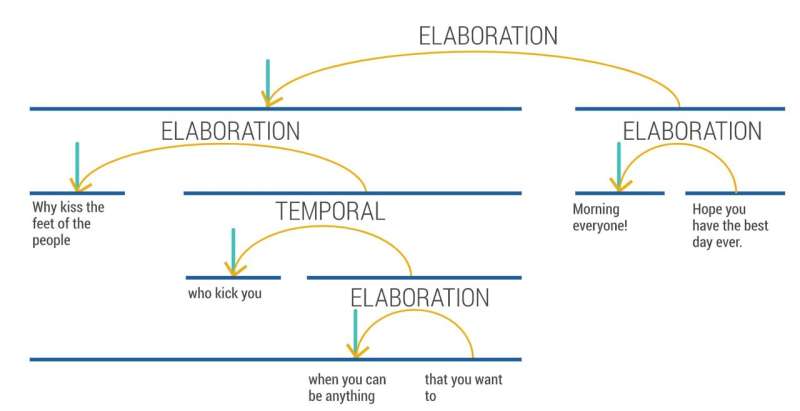

Un ejemplo de estructura de texto extraído utilizando el analizador RST. Crédito: Tendencias en IA desde las perspectivas del equipo rojo y azul: datos sintéticos en una sociedad basada en datos frente al análisis de sentimientos (2023).

Un informe del Centro de Excelencia en Comunicaciones Estratégicas de la OTAN (StratCom COE) advirtió que muchas de las herramientas de inteligencia artificial (IA) utilizadas para monitorear las publicaciones en las redes sociales son demasiado literales y tienen dificultades para detectar mensajes hostiles sutiles e información errónea.

Muchos modelos de aprendizaje automático permiten que las plataformas, las empresas y los gobiernos calculen la emoción de las publicaciones y los videos en línea.

Sin embargo, una semana antes del Festival Mundial de Inteligencia Artificial de Cannes (del 9 al 11 de febrero), un equipo de expertos dice que la mayoría de estos sistemas basados en IA se basan en comprender el sentimiento detrás de un mensaje, que no es tan claro como se pensaba.

Su estudio, publicado como parte de una colaboración entre la Universidad de Portsmouth y un informe de investigación del Centro de Excelencia en Comunicaciones Estratégicas de la OTAN, explora las tendencias en IA. Describe las limitaciones de estas estrategias de sentimiento de código abierto y recomienda formas de mejorarlas.

El objetivo del texto microagresivo en línea es atacar a un individuo, grupo, organización o país, de una manera que es difícil de detectar cuando lo analiza la IA.

El Dr. Alexander Gegov, lector de inteligencia computacional y líder del equipo de la Universidad de Portsmouth que trabaja en la investigación para el COE de StratCom de la OTAN, dijo: «Las microagresiones sutiles son peligrosas en las plataformas de redes sociales, ya que a menudo pueden resonar con personas de creencias similares y ayudar a propagar sustancias tóxicas». o mensajes hostiles».

«Estimar las emociones en línea es un desafío, pero en este informe, demostramos que hay muchas maneras en que podemos mejorar nuestras canalizaciones de preprocesamiento convencionales. Es hora de ir más allá de las simples emociones polares y enseñar a la IA a evaluar el contexto de una conversación. »

Los autores dicen que el clasificador de emociones de Google Jigsaw es una adición interesante para analizar las emociones polares en línea, pero sus clasificadores no pueden distinguir entre las respuestas de los lectores a comentarios tóxicos o alguien que difunde un discurso de odio.

Descubrieron que un enfoque diferente, conocido como teoría de la estructura retórica (RST), es una forma más sólida y efectiva de analizar las microagresiones. En cierto modo, imita cómo los cerebros sopesan inconscientemente diferentes partes de las oraciones al asignar importancia a ciertas palabras o frases.

Por ejemplo: ‘Today is pretty bad’ y ‘That’s a pretty dress’ contienen la palabra positiva ‘bonito’. Pero ‘bonito’ también puede intensificar el sentimiento de las palabras que lo rodean, por ejemplo, ‘malo’.

«Claramente, analizar el texto por sí solo no es suficiente cuando se trata de clasificar formas más sutiles de discurso de odio», explicó la codirectora de la investigación, Djamila Ouelhadj, profesora de investigación operativa y análisis en la Universidad de Portsmouth.

«Nuestra investigación con el COE StratCom de la OTAN ha propuesto algunas recomendaciones sobre cómo mejorar las herramientas de inteligencia artificial para abordar estas limitaciones.

«Aprender cómo un individuo ha elaborado un mensaje ofrece una rica fuente de información sin explotar que puede proporcionar a un analista la ‘historia’ de cómo y por qué se armó el mensaje.

«Al analizar mensajes y tuits de grupos e individuos ofensivos o antioccidentales, por ejemplo, el modelo RST puede decirnos qué tan radicalizado está un grupo, en función de su confianza en el tema que están transmitiendo.

«También puede ayudar a detectar si alguien está siendo preparado o radicalizado al medir el nivel de inseguridad que muestra la persona al transmitir su ‘opinión'».

El equipo ha producido una serie de conjuntos de datos para comprender las microagresiones y los ha probado con texto en inglés y ruso.

Extrajeron una muestra de 500 mensajes en ruso de un canal de Telegram vinculado al Kremlin que discutía la guerra de Ucrania y analizaron sus niveles de hostilidad utilizando el modelo Google Jigsaw.

El texto traducido obtuvo una puntuación más baja en toxicidad en comparación con los documentos rusos originales. Esto resaltó que cuando AI traduce los mensajes de su idioma original, algunas de las inferencias tóxicas se pierden o se pasan por alto. El efecto podría ser aún más fuerte al analizar la microagresión, donde la hostilidad no es tan obvia.

Para superar esto, el documento dice que los traductores en línea pueden ajustarse y adaptarse a los idiomas específicos de países y regiones.

El Dr. Gundars Bergmanis-Korāts, experto sénior del COE StratCom de la OTAN, dijo: «Los gobiernos, las organizaciones y las instituciones de la OTAN y los países aliados deben abordar los desafíos actuales de la IA y centrarse en los ajustes específicos del idioma local para garantizar la igualdad de capacidades de la IEA. »

«Las organizaciones militares y gubernamentales aprovechan las herramientas de aprendizaje automático para detectar, medir y mitigar la desinformación en línea y medir la efectividad y el alcance de las comunicaciones. Por lo tanto, es crucial comprender a las audiencias mediante el análisis del contexto de la comunicación».

El año pasado, EE. UU. reservó más de medio millón de dólares para desarrollar un modelo de inteligencia artificial que pueda detectar y suprimir automáticamente las microagresiones en las redes sociales.

El Dr. Gegov agregó: «A menudo, la esencia general de los mensajes de las redes sociales se oculta entre oraciones menos relevantes, razón por la cual son necesarios los pasos de filtrado manual y procesamiento posterior en las plataformas».

«Es probable que esto no cambie de la noche a la mañana, pero si bien no existe una ‘herramienta que lo haga todo’, exploramos algunos trucos simples que los analistas de datos y los entusiastas de la IA pueden hacer para aumentar potencialmente el rendimiento de sus canales de procesamiento de texto».

«También alentamos a los monitores de redes sociales a ser más transparentes sobre los sistemas que están usando actualmente».

Más información:

Informe: stratcomcoe.org/pdfjs/?file=/p … AL.pdf?zoom=page-fit

Citación: Las herramientas de inteligencia artificial están pasando por alto mensajes sutiles hostiles en las redes sociales (2 de febrero de 2023) consultado el 2 de febrero de 2023 en https://techxplore.com/news/2023-02-subtle-hostile-social-media-messaging.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.