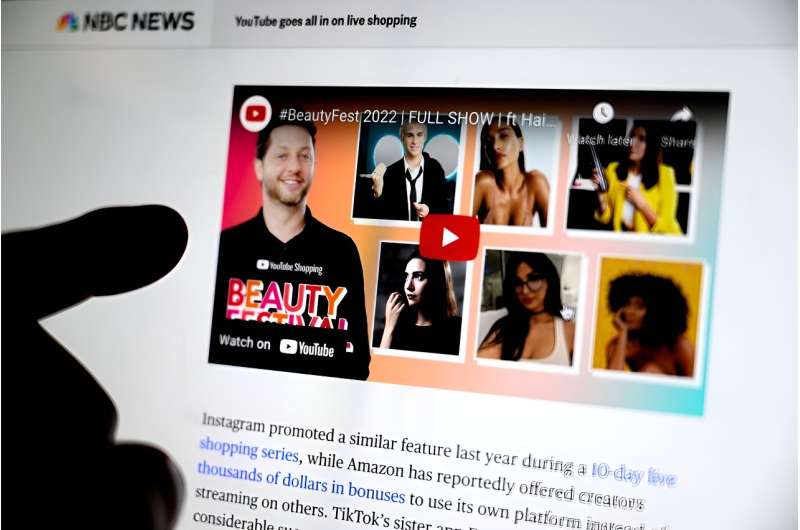

Las investigaciones encuentran que el contenido extremista y alternativo en YouTube se ve predominantemente fuera de la plataforma a través de clips incrustados. Crédito: Matthew Modoono/Universidad del Noreste

Es fácil caer en la madriguera de la plataforma para compartir vídeos en línea YouTube. Después de todo, ¿existe realmente un límite para los vídeos lindos de mascotas?

Pero ¿qué pasa con el lado más siniestro de la plataforma? Después de las elecciones presidenciales de EE. UU. de 2016, YouTube fue tan criticado por radicalizar a los usuarios al recomendar contenidos cada vez más extremistas y marginales que cambió su algoritmo de recomendación.

Una investigación realizada cuatro años más tarde por el científico informático de la Universidad Northeastern, Christo Wilson, descubrió que, si bien el contenido extremista permanecía en YouTube,las suscripciones y las referencias externas llevaron a los usuarios descontentos a acceder a contenido extremista en lugar del algoritmo de recomendación.

«No vimos este tipo de ‘efecto de madriguera'», dice Wilson, profesor asociado de la Facultad de Ciencias de la Computación Khoury de Northeastern. «De hecho, había mucho contenido problemático que todavía estaba en YouTube y todavía tenía una audiencia bastante significativa de personas que lo estaban viendo. Lo que pasa es que no se han radicalizado en YouTube».

Entonces, si no en YouTube, ¿dónde se estaba radicalizando esta audiencia?

En una nueva investigación presentado en una conferencia de ciencia web de ACMWilson descubre que las comunidades extremistas continúan dependiendo de YouTube para alojar videos; solo que fuera del sitio es donde comienza la «madriguera de conejos».

«Si ya eres un partidario político y vas a sitios web con una inclinación particular, eso te llevará a canales y videos de YouTube con el mismo tipo de inclinación», dice Wilson. «Si empezaste en un lugar donde estás expuesto a cosas malas, terminas en un lugar donde estás expuesto a más cosas malas».

YouTube es una plataforma para compartir vídeos en línea propiedad de Google. Tras las críticas por su papel en el alojamiento y la promoción de contenido de conspiración marginal, particularmente a través de su algoritmo de recomendación, la plataforma cambió ese algoritmo en 2019.

Pero el contenido extremista nunca desapareció por completo.

Gran parte de ellos emigró.

«YouTube no es sólo YouTube en sí: puedes insertar los vídeos en cualquier sitio web», afirma Wilson. «Este es el primer estudio en el que analizamos todas estas cosas que suceden fuera de la plataforma».

Wilson examinó a más de 1.000 residentes de EE. UU. de tres cohortes: usuarios demográficamente representativos, usuarios habituales de YouTube y usuarios con un alto resentimiento racial. Analizó todos los vídeos de YouTube encontrados por los usuarios durante un período de seis meses. Todos los usuarios accedieron a la web a través de computadoras de escritorio, en lugar de dispositivos móviles.

La investigación arrojó varias conclusiones interesantes.

Wilson descubrió que los usuarios veían más vídeos de YouTube en sitios distintos de YouTube que en el propio sitio web de la plataforma.

También descubrió que los sitios web políticamente de derecha tienden a insertar más vídeos de canales «problemáticos» de YouTube que los sitios web de centro o de izquierda. Los canales se consideraban problemáticos si se clasificaban como alternativos o extremistas, utilizando calificaciones asignadas por verificadores de datos profesionales u otros académicos.

Wilson dice que un canal alternativo sería, por ejemplo, Steven Crowder, una personalidad que entrevista tanto a científicos convencionales como a quienes niegan las vacunas y que es «un poco intelectualmente abierto». Los canales extremistas, dijo Wilson, serían «abiertamente odiosos», algo así como el antiguo canal de YouTube del ex Gran Mago del Ku Klux Klan David Duke.

En particular, los usuarios expuestos a videos fuera de la plataforma de canales problemáticos son significativamente más propensos a buscar videos en la plataforma de canales problemáticos.

«Su actividad fuera de la plataforma rápidamente se convierte en actividad dentro de la plataforma», dice Wilson.

Entonces, ¿qué puede hacer YouTube? Después de todo, Wilson admite que la plataforma no puede controlar lo que hacen las personas cuando están en otros sitios.

Wilson recomienda políticas de moderación de contenido más estrictas.

«YouTube puede saber dónde se están incrustando los vídeos fuera de la plataforma», señala Wilson. «Si ven que un canal en particular está integrado en un sitio web que es un conocido proveedor de información errónea, ese canal probablemente debería ser examinado minuciosamente».

Además, Wilson señala que YouTube aún aloja los videos, incluso si aparecen en otros sitios.

«Están ayudando e instigando a estas comunidades marginales que existen en la web al alojar videos para ellas», dice Wilson. «Si tuvieran políticas de moderación de contenido más estrictas, eso definitivamente ayudaría a abordar este problema».

Más información:

Desheng Hu et al, Exposición de los usuarios estadounidenses a vídeos de YouTube dentro y fuera de la plataforma, Conferencia de ciencia web de ACM (2024). DOI: 10.1145/3614419.3644027

Esta historia se republica por cortesía de Northeastern Global News. noticias.northeastern.edu.

Citación: Las comunidades extremistas siguen dependiendo de YouTube como alojamiento, pero la mayoría de los vídeos se ven fuera del sitio, según una investigación (22 de mayo de 2024), consultado el 22 de mayo de 2024 en https://techxplore.com/news/2024-05-extremist-communities -youtube-alojamiento-videos.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.

GIPHY App Key not set. Please check settings