Crédito: Jakhotiya, Patil y Rawlani.

Los atacantes cibernéticos están ideando técnicas cada vez más sofisticadas para robar información confidencial de los usuarios, cifrar documentos para recibir un rescate o dañar los sistemas informáticos. Como resultado, los científicos informáticos han estado tratando de crear técnicas más efectivas para detectar y prevenir ataques cibernéticos.

Muchos de los detectores de malware desarrollados en los últimos años se basan en algoritmos de aprendizaje automático entrenados para reconocer automáticamente los patrones o firmas asociados con ataques cibernéticos específicos. Si bien algunos de estos algoritmos lograron resultados notables, por lo general son susceptibles a los ataques de los adversarios.

Los ataques adversarios ocurren cuando un usuario malintencionado perturba o edita datos de manera sutil, para asegurarse de que un algoritmo de aprendizaje automático los clasifique incorrectamente. Como resultado de estas sutiles perturbaciones, el algoritmo podría clasificar el malware como si fuera un software seguro y normal.

Investigadores de la Facultad de Ingeniería de Pune, India, han llevado a cabo recientemente un estudio que investiga la vulnerabilidad de un detector de malware basado en aprendizaje profundo frente a ataques de adversarios. Su artículo, publicado previamente en arXiv, se centra específicamente en un detector basado en transformadores, una clase de modelos de aprendizaje profundo que pueden sopesar diferentes partes de los datos de entrada de manera diferente.

«Se han propuesto muchos modelos basados en el aprendizaje automático para detectar de manera eficiente una amplia variedad de malware», escribieron en su artículo Yash Jakhotiya, Heramb Patil y Jugal Rawlani.

«Se descubrió que muchos de estos modelos son susceptibles a los ataques de los adversarios, ataques que funcionan mediante la generación de entradas diseñadas intencionalmente que pueden obligar a estos modelos a clasificarse erróneamente. Nuestro trabajo tiene como objetivo explorar las vulnerabilidades en los detectores de malware de última generación frente a los ataques de los adversarios».

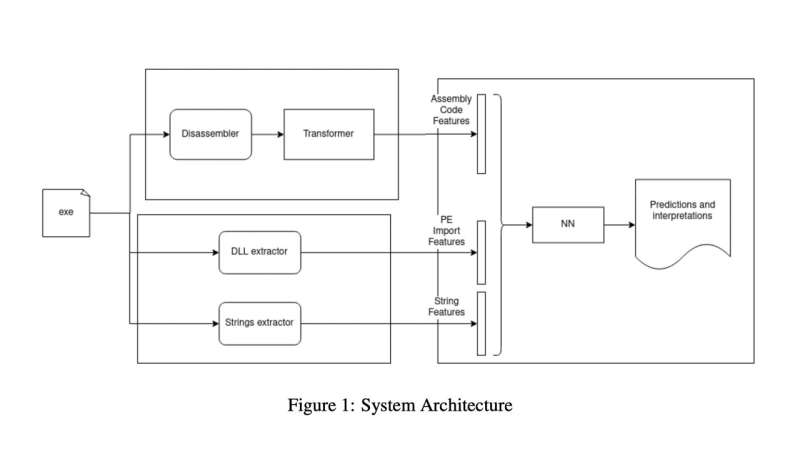

Para evaluar la vulnerabilidad de los detectores de malware basados en el aprendizaje profundo frente a los ataques de los adversarios, Jakhotiya, Patil y Rawlani desarrollaron su propio sistema de detección de malware. Este sistema tiene tres componentes clave: un módulo de ensamblaje, un módulo de características estáticas y un módulo de red neuronal.

El módulo ensamblador es responsable de calcular las características del lenguaje ensamblador que luego se utilizan para clasificar los datos. Usando la misma entrada alimentada al módulo de ensamblaje, el módulo de características estáticas produce dos conjuntos de vectores que también se usarán para clasificar datos.

El modelo de red neuronal utiliza las características y los vectores producidos por los dos modelos para clasificar archivos y software. En última instancia, su objetivo es determinar si los archivos y el software que analiza son benignos o maliciosos.

Los investigadores probaron su detector de malware basado en transformadores en una serie de pruebas, donde evaluaron cómo su rendimiento se vio afectado por los ataques de los adversarios. Descubrieron que era propenso a clasificar erróneamente los datos casi 1 de cada 4 veces.

«Entrenamos un detector de malware basado en Transformers, llevamos a cabo ataques adversarios que dan como resultado una tasa de clasificación errónea del 23,9 % y proponemos defensas que reducen esta tasa de clasificación errónea a la mitad», escribieron Jakhotiya, Patil y Rawlani en su artículo.

Los hallazgos recientes recopilados por este equipo de investigadores destacan la vulnerabilidad de los detectores de malware basados en transformadores de corriente frente a los ataques de los adversarios. Basándose en sus observaciones, Jakhotiya, Patil y Rawlani proponen una serie de estrategias de defensa que podrían ayudar a aumentar la resiliencia de los transformadores entrenados para detectar malware contra ataques adversarios.

Estas estrategias incluyen entrenar los algoritmos en muestras antagónicas, enmascarar el gradiente del modelo, reducir la cantidad de características que observan los algoritmos y bloquear la llamada transferibilidad de las arquitecturas neuronales. En el futuro, estas estrategias y los hallazgos generales publicados en el artículo reciente podrían informar el desarrollo de detectores de malware basados en aprendizaje profundo más efectivos y confiables.

Una técnica de aprendizaje profundo para generar ataques de amplificación de DNS

Yash Jakhotiya, Heramb Patil, Jugal Rawlani, Ataques adversos en detectores de malware basados en transformadores. arXiv:2210.00008v1 [cs.CR], arxiv.org/abs/2210.00008

© 2022 Ciencia X Red

Citación: La vulnerabilidad de los detectores de malware basados en transformadores a los ataques adversarios (18 de octubre de 2022) consultado el 18 de octubre de 2022 en https://techxplore.com/news/2022-10-vulnerability-transformers-based-malware-detectors-adversarial.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.