La semana pasada, Amazon hizo una Acuerdo inusual con una empresa llamada Adept en el que Amazon licenciará la tecnología de la empresa y también fichará a miembros de su equipo, incluidos los cofundadores de la empresa.

El gigante del comercio electrónico, la computación en la nube, la publicidad online, el streaming digital y la inteligencia artificial (IA) sin duda espera que el acuerdo impulse a Amazon, que se está quedando atrás de empresas como Microsoft, Google y Meta en el importantísimo ámbito de la IA. (De hecho, Adept ya había estado en conversaciones de adquisición con Microsoft y Meta).

Adept se especializa en el área más candente de la IA, de la que casi nadie habla, pero que algunos afirman con credibilidad que es el próximo paso adelante en la tecnología de la IA.

Pero espere, ¿qué es exactamente la IA con agentes? La forma más fácil de entenderla es comparándola con los chatbots basados en LLM.

En qué se diferencia la IA de los chatbots LLM

Sabemos todo sobre los chatbots basados en LLM como ChatGPT. Los sistemas de IA con agentes se basan en el mismo tipo de modelos de lenguaje grandes, pero con importantes añadidos. Mientras que los chatbots basados en LLM responden a indicaciones específicas, intentando ofrecer literalmente lo que se les pide, los sistemas con agentes llevan eso más allá al incorporar establecimiento de objetivos autónomos, razonamiento y planificación dinámica. También están diseñados para integrarse con aplicaciones, sistemas y plataformas.

Mientras que los LLM, como ChatGPT, hacen referencia a enormes cantidades de datos y los sistemas híbridos, como Perplexity AI, combinan eso con búsquedas web en tiempo real, los sistemas agenticos incorporan además circunstancias y contextos cambiantes para alcanzar objetivos, lo que les obliga a repriorizar tareas y cambiar métodos para alcanzar esos objetivos.

Si bien los chatbots LLM no tienen la capacidad de tomar decisiones reales, los sistemas agénticos se caracterizan por un razonamiento contextual y una toma de decisiones avanzados. Los sistemas agénticos pueden planificar, “comprender” intenciones e integrarse de manera más completa con una gama mucho más amplia de sistemas y plataformas de terceros.

¿Para qué sirve?

Un uso obvio de la IA agente es como asistente personal. Una herramienta de este tipo podría, basándose en solicitudes en lenguaje natural, programar reuniones y administrar un calendario, cambiar los horarios en función de la disponibilidad de los demás y la suya, y recordarle las reuniones. Y podría ser útil en las propias reuniones, recopilando datos con antelación, creando una agenda, tomando notas y asignando elementos de acción, para luego enviar recordatorios de seguimiento. Todo esto podría comenzar teóricamente con una única solicitud en lenguaje sencillo, pero vaga.

Podría leer, categorizar y responder correos electrónicos en su nombre, decidiendo cuáles responder y cuáles dejar para que usted responda.

Podrías pedirle a tu asistente de inteligencia artificial que complete formularios por ti o que se suscriba a servicios, ingrese la información solicitada e incluso procese cualquier pago. En teoría, incluso podría navegar por la web por ti, recopilar información y crear un informe.

Al igual que los chatbots LLM actuales, los asistentes de IA agentes podrían usar entrada multimodal y recibir instrucciones verbales junto con entradas de audio, texto y video recopiladas por cámaras y micrófonos en sus gafas.

Otra aplicación obvia de la IA con agentes es la atención al cliente. Los sistemas de respuesta de voz interactiva (IVR) actuales parecen una buena idea en teoría (dejar que los clientes tengan que navegar por árboles de decisión complejos mientras luchan con un reconocimiento de voz inadecuado para que una empresa no tenga que pagar a humanos para interactuar con los clientes), pero fallan en la práctica.

La inteligencia artificial de Agentic promete transformar el servicio de atención al cliente automatizado. Esta tecnología debería poder funcionar como si no solo entendiera las palabras, sino también los problemas y objetivos del cliente por teléfono, y luego realizar acciones de varios pasos para llegar a una solución.

Pueden hacer todo tipo de cosas que un empleado de nivel inferior podría hacer: calificar clientes potenciales de ventas, realizar el contacto inicial para llamadas de ventas, automatizar la detección de fraudes y el procesamiento de solicitudes de préstamos en un banco, evaluar de forma autónoma a los candidatos que solicitan empleo e incluso realizar entrevistas iniciales y otras tareas.

La IA agente también debería poder lograr objetivos a gran escala: optimizar las cadenas de suministro y las redes de distribución, gestionar el inventario, optimizar las rutas de entrega, reducir los costos operativos y más.

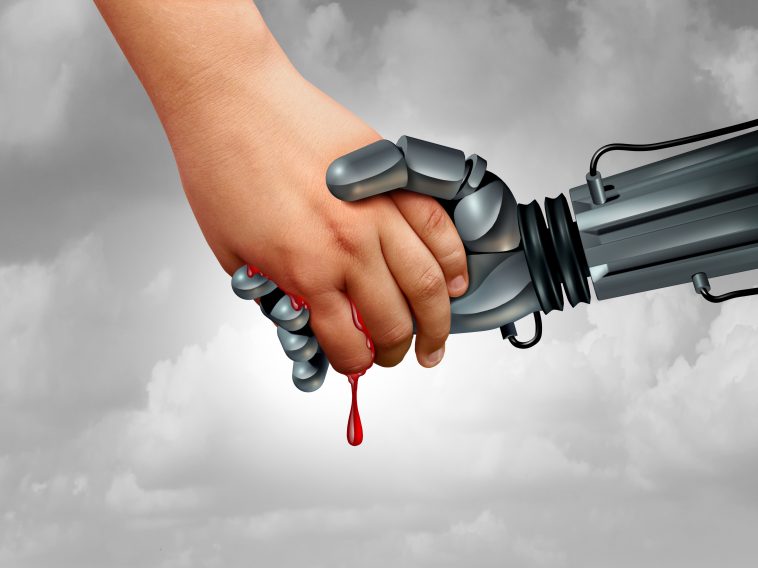

El riesgo de la IA agente

Empecemos por lo básico. La idea de una IA que pueda operar de forma “creativa” y autónoma (capaz de hacer cosas en distintos sitios, plataformas y redes, dirigida por un comando creado por humanos y con una supervisión humana limitada) es obviamente problemática.

Supongamos que un vendedor ordena a una IA que organice una reunión con un cliente potencial difícil de alcanzar. La IA entiende el objetivo y tiene una gran cantidad de información sobre cómo hacen las cosas los seres humanos reales, pero no tiene una brújula moral ni una dirección explícita para comportarse de manera ética.

Una forma de llegar a ese cliente (basándose en el comportamiento de seres humanos reales en el mundo real) podría ser enviar un correo electrónico, engañando a la persona para que haga clic en un malware autoejecutable, que abriría un troyano en el sistema del objetivo que se utilizaría para exfiltrar todos los datos personales y utilizar esos datos para averiguar dónde estaría esa persona en un momento determinado. La IA podría entonces realizar una llamada a esa ubicación y decir que hay una emergencia. El objetivo respondería a la llamada y la IA intentaría concertar una reunión.

Este es solo un pequeño ejemplo de cómo una IA con capacidad de actuar sin una ética codificada o inducida podría hacer algo incorrecto. Las posibilidades de que surjan problemas son infinitas.

La IA agente podría ser tan poderosa y capaz que no habría forma de que esto terminara bien sin un gran esfuerzo en el desarrollo y mantenimiento de marcos de gobernanza de la IA que incluyan pautas, medidas de seguridad y supervisión constante por parte de personas bien capacitadas.

Nota: El auge de los LLM, empezando por ChatGPT, generó temores de que la IA pudiera quitarle puestos de trabajo a la gente; la IA agente es la tecnología que realmente podría hacer eso a escala.

El peor escenario posible sería que millones de personas fueran despedidas y reemplazadas por una IA con capacidad de agencia. El mejor escenario posible sería que la tecnología fuera inferior a la de un ser humano que la acompañara. Con una herramienta de este tipo, el trabajo humano podría ser mucho más eficiente y menos propenso a errores.

Soy pesimista respecto de que la IA con agentes pueda beneficiar a la humanidad si las consideraciones éticas siguen estando completamente en manos de los expertos en tecnología, los inversores y los tecnólogos de IA de Silicon Valley. Tendremos que combinar la experiencia de la IA, la ética, el derecho, el mundo académico y dominios industriales específicos y avanzar con cautela hacia la era de la IA con agentes.

Es razonable sentirse emocionado por la promesa de la IA con agentes y a la vez aterrorizado por los posibles efectos negativos. Una cosa es cierta: es hora de prestar atención a esta tecnología emergente.

Con una empresa gigante, ambiciosa, capaz y agresiva como Amazon tomando medidas para liderar la IA agente, ya no es posible ignorarla.

GIPHY App Key not set. Please check settings