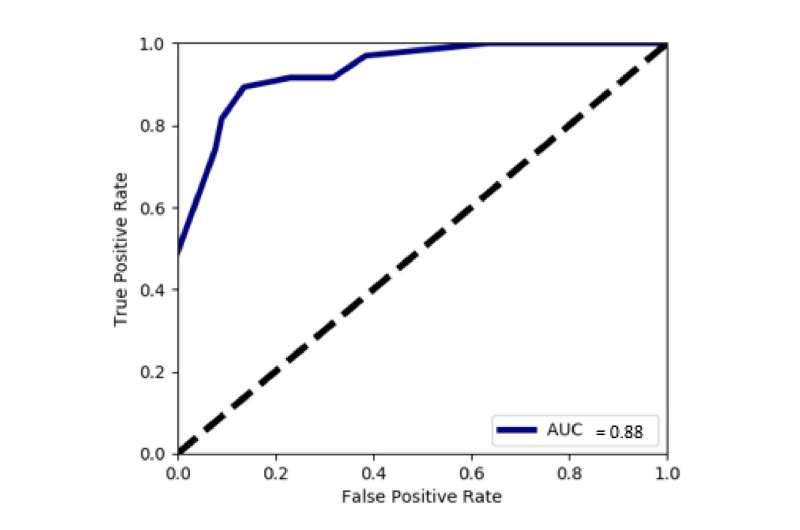

Clasificador de conversaciones sobre riesgos sexuales de CNN ROC. Crédito: Actas de la ACM sobre interacción humano-computadora (2023). DOI: 10.1145/3579522

En un esfuerzo único en su tipo, los investigadores de redes sociales de la Universidad de Drexel, la Universidad de Vanderbilt, el Instituto de Tecnología de Georgia y la Universidad de Boston están recurriendo a los jóvenes usuarios de las redes sociales para ayudar a construir un programa de aprendizaje automático que pueda detectar avances sexuales no deseados en Instagram. . Entrenado con datos de más de 5 millones de mensajes directos, anotados y aportados por 150 adolescentes que habían experimentado conversaciones que los hicieron sentir sexualmente incómodos o inseguros, la tecnología puede señalar de forma rápida y precisa los DM riesgosos.

El proyecto, que fue publicado recientemente por la Association for Computing Machinery en su Actas de la ACM sobre interacción humano-computadoratiene como objetivo abordar las preocupaciones de que un aumento de adolescentes que usan las redes sociales, particularmente durante la pandemia, está contribuyendo a las crecientes tendencias de explotación sexual infantil.

«Solo en el año 2020, el Centro Nacional para Niños Desaparecidos y Explotados recibió más de 21,7 millones de denuncias de explotación sexual infantil, lo que supuso un aumento del 97 % con respecto al año anterior. Este es un problema muy real y aterrador», dijo Afsaneh Razi. , Ph.D., profesor asistente en la Facultad de Computación e Informática de Drexel, quien fue líder de la investigación.

Las empresas de redes sociales están implementando una nueva tecnología que puede marcar y eliminar imágenes de explotación sexual y ayuda a los usuarios a denunciar más rápidamente estas publicaciones ilegales. Pero los defensores piden una mayor protección para los usuarios jóvenes que podría identificar y reducir estas interacciones de riesgo antes.

Los esfuerzos del grupo son parte de un campo de investigación en crecimiento que analiza cómo el aprendizaje automático y la inteligencia artificial se integran en las plataformas para ayudar a mantener a los jóvenes seguros en las redes sociales, al mismo tiempo que se garantiza su privacidad. Su proyecto más reciente se destaca por su colección de un tesoro de mensajes directos privados de usuarios jóvenes, que el equipo usó para entrenar un programa basado en aprendizaje automático que tiene una precisión del 89% para detectar conversaciones sexualmente inseguras entre adolescentes en Instagram.

«La mayor parte de la investigación en esta área utiliza conjuntos de datos públicos que no son representativos de las interacciones reales que ocurren en privado», dijo Razi. «La investigación ha demostrado que los modelos de aprendizaje automático basados en las perspectivas de quienes experimentaron los riesgos, como el acoso cibernético, brindan un mayor rendimiento en términos de recuerdo. Por lo tanto, es importante incluir las experiencias de las víctimas al tratar de detectar los riesgos».

Cada uno de los 150 participantes, cuyas edades oscilan entre los 13 y los 21 años, había usado Instagram durante al menos tres meses entre los 13 y los 17 años, intercambiado mensajes directos con al menos 15 personas durante ese tiempo y había al menos dos mensajes directos que los hicieron sentir incómodos o inseguros a ellos o a otra persona.

Contribuyeron con sus datos de Instagram (más de 15 000 conversaciones privadas) a través de un portal en línea seguro diseñado por el equipo. Y luego se les pidió que revisaran sus mensajes y etiquetaran cada conversación, como «segura» o «insegura», según cómo los hiciera sentir.

«Recopilar este conjunto de datos fue muy desafiante debido a la sensibilidad del tema y porque en algunos casos los menores aportan los datos», dijo Razi. «Debido a esto, aumentamos drásticamente las precauciones que tomamos para preservar la confidencialidad y la privacidad de los participantes y para garantizar que la recopilación de datos cumpliera con altos estándares legales y éticos, incluida la denuncia de abuso infantil y la posibilidad de cargar artefactos potencialmente ilegales, como material de abuso infantil».

Los participantes marcaron 326 conversaciones como inseguras y, en cada caso, se les pidió que identificaran qué tipo de riesgo presentaba: desnudez/pornografía, mensajes sexuales, acoso, incitación al odio, violencia/amenazas, venta o promoción de actividades ilegales o autoevaluación. -lesiones—y el nivel de riesgo que sintieron—ya sea alto, medio o bajo.

Este nivel de evaluación generada por el usuario proporcionó una guía valiosa a la hora de preparar los programas de aprendizaje automático. Razi señaló que la mayoría de los conjuntos de datos de interacción en las redes sociales se recopilan de conversaciones disponibles públicamente, que son muy diferentes a las que se mantienen en privado. Y normalmente están etiquetados por personas que no participaron en la conversación, por lo que puede ser difícil para ellos evaluar con precisión el nivel de riesgo que sintieron los participantes.

«Con las etiquetas autoinformadas de los participantes, no solo detectamos a los depredadores sexuales, sino que también evaluamos las perspectivas de los sobrevivientes sobre la experiencia de riesgo sexual», escribieron los autores. «Este es un objetivo significativamente diferente que intentar identificar a los depredadores sexuales. Basado en este conjunto de datos y etiquetas de usuarios reales, este documento también incorpora características centradas en el ser humano en el desarrollo de un sistema automatizado de detección de riesgos sexuales».

Se utilizaron combinaciones específicas de funciones de conversación y mensajes como entrada de los modelos de aprendizaje automático. Estos incluyeron características contextuales, como la edad, el género y la relación de los participantes; características lingüísticas, como el recuento de palabras, el enfoque de las preguntas o los temas de la conversación; si fue positivo, negativo o neutral; con qué frecuencia se usaron ciertos términos; y si se utilizó o no un conjunto de 98 palabras preidentificadas relacionadas con el sexo.

Esto permitió que los programas de aprendizaje automático designaran un conjunto de atributos de conversaciones riesgosas y, gracias a las evaluaciones de los participantes de sus propias conversaciones, el programa también pudo clasificar el nivel relativo de riesgo.

El equipo puso a prueba su modelo frente a un gran conjunto de muestras de conversaciones públicas creadas específicamente para la investigación de detección de riesgos de depredación sexual. El mejor rendimiento provino de su programa clasificador «Random Forest», que puede asignar rápidamente características a conversaciones de muestra y compararlas con conjuntos conocidos que han alcanzado un umbral de riesgo. El clasificador identificó con precisión el 92% de las conversaciones sexuales inseguras del set. También tuvo una precisión del 84 % al marcar mensajes individuales de riesgo.

Al incorporar su capacitación de evaluación de riesgos etiquetada por el usuario, los modelos también pudieron descubrir las características más relevantes para identificar una conversación insegura. Las características contextuales, como la edad, el sexo y el tipo de relación, así como la consulta lingüística y el recuento de palabras, fueron las que más contribuyeron a identificar conversaciones que hicieron que los usuarios jóvenes se sintieran inseguros, escribieron.

Esto significa que un programa como este podría usarse para advertir automáticamente a los usuarios, en tiempo real, cuando una conversación se vuelve problemática, así como para recopilar datos después del hecho. Ambas aplicaciones podrían ser de gran ayuda en la prevención de riesgos y la persecución de delitos, pero los autores advierten que su integración en las plataformas de redes sociales debe preservar la confianza y la privacidad de los usuarios.

«Los proveedores de servicios sociales encuentran valor en el uso potencial de la IA como un sistema de detección temprana de riesgos, porque actualmente dependen en gran medida de los autoinformes de los jóvenes después de que se realizó una investigación formal», dijo Razi.

«Pero estos métodos deben implementarse en un asunto de preservación de la privacidad para no dañar la confianza y la relación de los adolescentes con los adultos. Muchas aplicaciones de monitoreo de los padres son invasivas para la privacidad ya que comparten la mayor parte de la información de los adolescentes con los padres, y estos sistemas de detección de aprendizaje automático puede ayudar con un intercambio mínimo de información y pautas para los recursos cuando sea necesario».

Sugieren que si el programa se implementa como una intervención en tiempo real, los usuarios jóvenes deberían recibir una sugerencia, en lugar de una alerta o un informe automático, y deberían poder proporcionar comentarios al modelo y tomar la decisión final.

Si bien la naturaleza innovadora de sus datos de capacitación hace que este trabajo sea una valiosa contribución al campo de la detección de riesgos computacionales y la investigación de la seguridad en línea de los adolescentes, el equipo señala que podría mejorarse ampliando el tamaño de la muestra y observando a los usuarios de diferentes redes sociales. plataformas Las anotaciones de entrenamiento para los modelos de aprendizaje automático también podrían revisarse para permitir que expertos externos califiquen el riesgo de cada conversación.

El grupo planea continuar con su trabajo y perfeccionar aún más sus modelos de detección de riesgos. También ha creado una comunidad de código abierto para compartir de forma segura los datos con otros investigadores en el campo, reconociendo lo importante que podría ser para la protección de esta población vulnerable de usuarios de redes sociales.

«La contribución central de este trabajo es que nuestros hallazgos se basan en las voces de los jóvenes que experimentaron riesgos sexuales en línea y fueron lo suficientemente valientes como para compartir estas experiencias con nosotros», escribieron. «Hasta donde sabemos, este es el primer trabajo que analiza los enfoques de aprendizaje automático en conversaciones privadas de jóvenes en las redes sociales para detectar conversaciones sexuales inseguras».

Más información:

Afsaneh Razi et al, Deslizarse en mis DM: detección de experiencias de riesgo sexual incómodas o inseguras dentro de los mensajes directos de Instagram basados en la perspectiva de la juventud, Actas de la ACM sobre interacción humano-computadora (2023). DOI: 10.1145/3579522

Citación: Jóvenes usuarios de redes sociales ayudan a entrenar el programa de aprendizaje automático para marcar conversaciones sexuales (24 de abril de 2023) recuperado el 24 de abril de 2023 de https://techxplore.com/news/2023-04-young-social-media-users-machine.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.