Desde la fabricación y la logística hasta la agricultura y el transporte, la expansión de la inteligencia artificial (IA) en la última década ha revolucionado una multitud de industrias; los ejemplos incluyen mejorar el análisis predictivo en la planta de fabricación y hacer predicciones de microclima para que los agricultores puedan responder y salvar sus cultivos. a tiempo. Se espera que la adopción de IA se acelere en los próximos años, lo que subraya la necesidad de un proceso de adopción eficiente que preserve la privacidad de los datos.

Actualmente, las organizaciones que desean adoptar IA en su flujo de trabajo pasan por el proceso de validación de modelos, en el que prueban o validar, modelos de IA de múltiples proveedores antes de seleccionar el que mejor se adapte a sus necesidades. Esto generalmente se hace con un conjunto de datos de prueba que proporciona la organización. Desafortunadamente, las dos opciones disponibles actualmente para la validación del modelo son insuficientes; ambos corren el riesgo de exponer los datos.

Una de estas opciones implica que el proveedor de IA comparta su modelo con la organización, que luego puede validar el modelo en su conjunto de datos de prueba. Sin embargo, al hacer esto, el proveedor de IA corre el riesgo de exponer su propiedad intelectual, que sin duda quiere proteger. La segunda opción, igualmente arriesgada, implica que la organización comparta su conjunto de datos de prueba con el proveedor de IA. Esto es problemático en dos frentes. Primero, corre el riesgo de exponer un conjunto de datos con información confidencial. Además, existe el riesgo de que el proveedor de IA utilice el conjunto de datos de prueba para entrenar el modelo de IA, por lo que «sobreajustará» el modelo al conjunto de datos de prueba para mostrar resultados creíbles. Para evaluar con precisión el rendimiento de un modelo de IA en un conjunto de datos de prueba, es fundamental que el modelo no se entrene en él. Actualmente, estas preocupaciones se abordan mediante acuerdos legales complejos, que a menudo demoran varios meses en redactarse y ejecutarse, lo que genera un retraso sustancial en el proceso de adopción de IA.

El riesgo de exposición de datos y la necesidad de acuerdos legales se agravan en el ámbito de la atención médica, donde los datos de los pacientes, que componen el conjunto de datos de prueba, son increíblemente confidenciales y existen estrictas normas de privacidad que ambas organizaciones deben cumplir. Además, el modelo de IA del proveedor no solo contiene información de propiedad intelectual patentada, sino que también puede incluir información confidencial del paciente como parte de los datos de capacitación que se usaron para desarrollarlo. Esto lo convierte en una situación difícil. Por un lado, las organizaciones de atención médica quieren adoptar rápidamente la IA debido a su enorme potencial en aplicaciones como la comprensión de los riesgos para la salud de los pacientes, la predicción y el diagnóstico de enfermedades y el desarrollo de intervenciones de salud personalizadas. Por otro lado, hay una lista de rápido crecimiento de proveedores de IA en el espacio de la atención médica para elegir (actualmente más de 200), lo que hace que el papeleo legal acumulativo de la validación de IA sea abrumador.

EzPC: computación multipartita fácil y segura

Estamos muy interesados en acelerar el proceso de validación del modelo de IA y, al mismo tiempo, garantizar la privacidad del conjunto de datos y del modelo. Por esta razón, construimos Easy Secure Multi-party Computation (EzPC). Este marco de código abierto es el resultado de una colaboración entre investigadores con experiencia en criptografía, lenguajes de programación, aprendizaje automático (ML) y seguridad. En esencia, EzPC se basa en cómputo multiparte seguro (MPC): un conjunto de protocolos criptográficos que permiten que varias partes calculen en colaboración una función en sus datos privados sin revelar esos datos a una u otra parte. Esta funcionalidad hace que la validación del modelo de IA sea un caso de uso ideal para MPC.

Sin embargo, aunque MPC existe desde hace casi cuatro décadas, rara vez se implementa porque la creación de protocolos MPC escalables y eficientes requiere una gran experiencia en criptografía. Además, si bien MPC funciona bien cuando se calculan funciones independientes pequeñas o simples, la combinación de varios tipos diferentes de funciones, lo cual es fundamental para las aplicaciones de ML, es mucho más difícil e ineficiente si se hace sin un conjunto de habilidades especializadas.

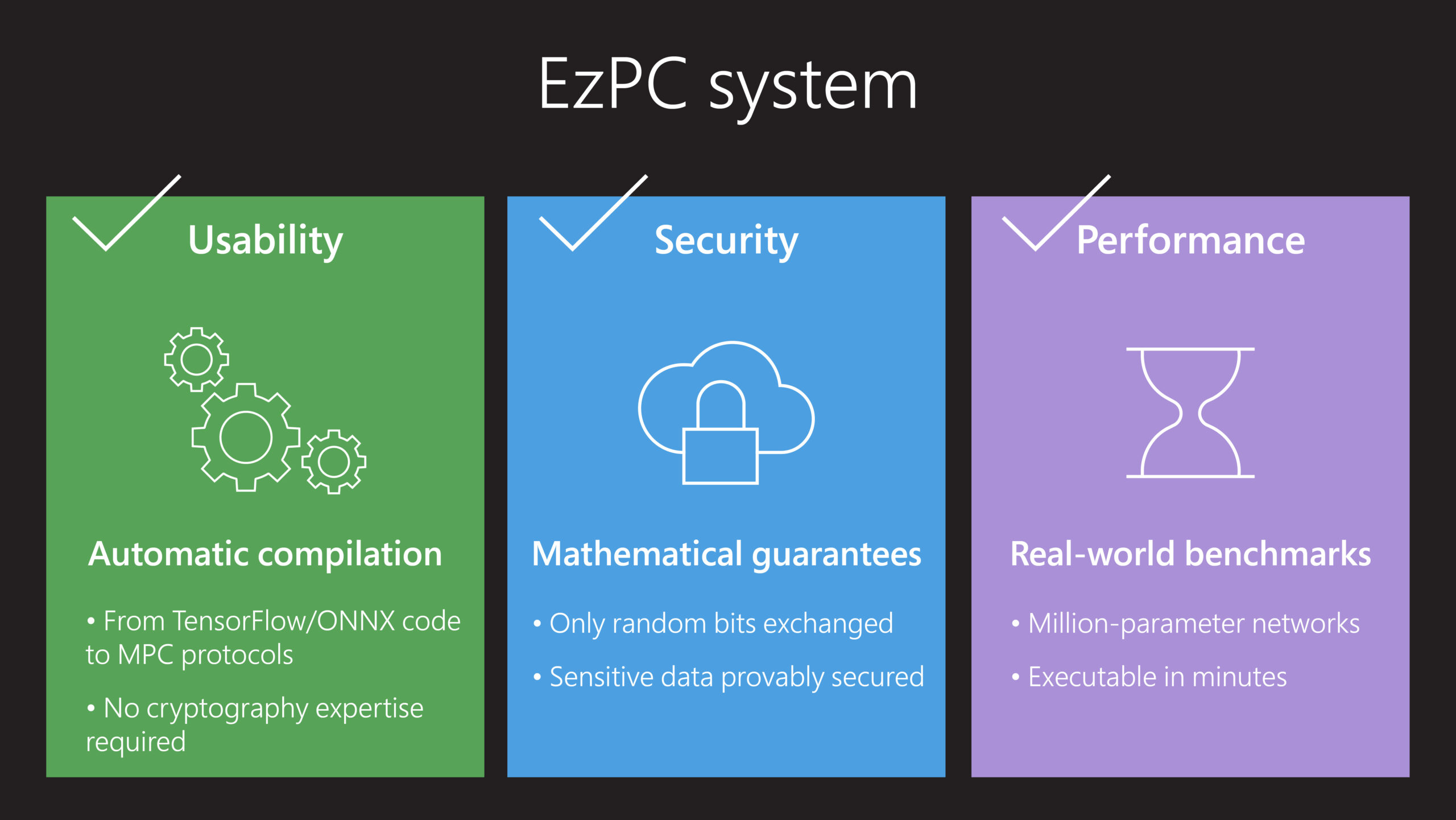

EzPC resuelve estos problemas, lo que facilita a todos los desarrolladores, no solo a los expertos en criptografía, usar MPC como un componente básico en sus aplicaciones al tiempo que proporciona un alto rendimiento computacional. Dos innovaciones son el núcleo de EzPC. Primero, un compilador modular llamado CrypTFlow toma como entrada el código TensorFlow o Open Neural Network Exchange (ONNX) para la inferencia de ML y genera automáticamente un código similar a C, que luego se puede compilar en varios protocolos MPC. Este compilador es compatible con MPC y está optimizado, lo que garantiza que los protocolos MPC sean eficientes y escalables. La segunda innovación es un conjunto de protocolos criptográficos de alto rendimiento para computar de forma segura funciones complejas de ML.

EzPC en la práctica: validación de IA de imágenes médicas en múltiples instituciones

En una colaboración reciente con investigadores de Universidad Stanford y el Centro de Investigación Avanzada en Imagen, Neurociencia y Genómica (CARING), el equipo de EzPC creó un sistema utilizando EzPC para abordar la necesidad de una validación de modelo de IA segura y eficaz. El equipo de la Universidad de Stanford había desarrollado un parámetro de 7 millones ampliamente aclamado Modelo de IA DenseNet-121 entrenado en el CheXpert conjunto de datos para predecir ciertas enfermedades pulmonares a partir de radiografías de tórax, mientras que un equipo de CARING creó un conjunto de datos de prueba etiquetado de quinientas imágenes de pacientes. El objetivo era probar la precisión del modelo CheXpert en el conjunto de datos de prueba de CARING mientras se preservaba la privacidad tanto del modelo como de los datos de prueba.

Con esta prueba, EzPC permitió la primera validación segura de un modelo de IA de grado de producción, lo que demuestra que no es necesario compartir datos para realizar con precisión la validación del modelo de IA. Además, los gastos generales de rendimiento de la validación segura fueron razonables y prácticos para la aplicación. En particular, se necesitaron 15 minutos para realizar una inferencia segura en una sola imagen a partir de los datos de prueba entre dos máquinas virtuales en la nube estándar, aproximadamente 3000 veces más que el tiempo necesario para probar una imagen sin la seguridad adicional que brinda EzPC. Ejecutar todas las imágenes de los datos de prueba tomó un total de cinco días con un costo general nominal (validación de IA de imágenes médicas encriptadas de múltiples instituciones sin compartir datos).

De cara al futuro: estandarización de la tecnología y las aplicaciones de privacidad más allá del cuidado de la salud

Con EzPC, la tecnología MPC ahora es lo suficientemente práctica y accesible para ejecutarse en cargas de trabajo complejas de IA, lo que la convierte en un cambio de juego en la colaboración de datos y permite a las organizaciones en todas las industrias, no solo de atención médica, para seleccionar los mejores modelos de IA para sus casos de uso y, al mismo tiempo, proteger los datos y la confidencialidad del modelo. Queremos fomentar el uso de EzPC con la conciencia de que es posible validar modelos de IA sin compartir datos. Al hacerlo, podemos prevenir el riesgo de exposición de datos y potencialmente superar las barreras actuales en la colaboración de datos.

Además, esta tecnología tiene el potencial de afectar la negociación de acuerdos legales complejos necesarios para el proceso de validación del modelo de IA. Esperamos que este tipo de acuerdos legales, así como la legislación que tiene como objetivo proteger la información confidencial y patentada, puedan incorporar el entendimiento de que, al usar la última tecnología de preservación de la privacidad, no es necesario compartir este tipo de información para calcular funciones en conjunto. datos.

Además de la validación del modelo de IA, EzPC se puede aplicar a varios escenarios diferentes en los que es esencial mantener la privacidad de los datos. Hemos evaluado con éxito EzPC para calcular de forma segura una variedad de algoritmos en dominios tales como detección de phishing, radioterapia personalizada, voz a palabras clave y análisis.

EzPC es de código abierto bajo licencia MIT en GitHub. Descubra los últimos desarrollos en la página del proyecto de investigación EzPC, donde puede leer nuestras publicaciones y ver videos para obtener más información.