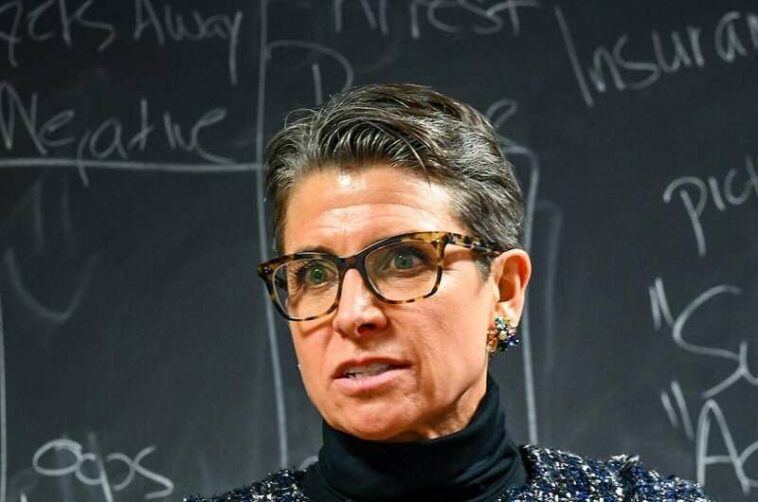

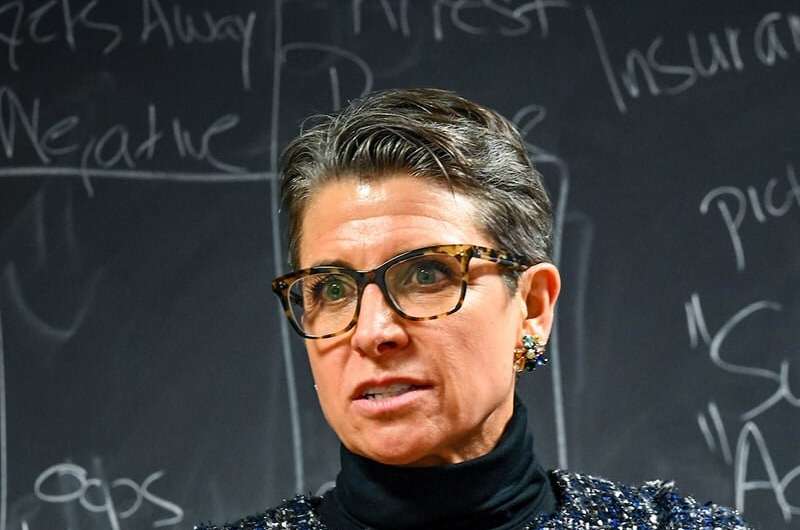

Kirsten Martin, directora del Centro de Ética Tecnológica de Notre Dame, imparte una clase en enero. ND TEC ofrece una especialización de 15 créditos en ética tecnológica que está abierta a todos los estudiantes de Notre Dame, independientemente de su especialización. Crédito: Universidad de Notre Dame

Mientras que las empresas de redes sociales buscan críticas sobre a quién eligen prohibir, los expertos en ética tecnológica dicen que la función más importante que controlan estas empresas ocurre detrás de escena en lo que recomiendan.

Kirsten Martin, directora del Centro de Ética Tecnológica de Notre Dame (ND TEC), argumenta que optimizar las recomendaciones basadas en un solo factor, el compromiso, es una decisión inherentemente cargada de valor.

La naturaleza humana puede estar fascinada y atraída por el contenido más polarizador: no podemos apartar la mirada de un choque de trenes. Pero todavía hay límites. Las plataformas de redes sociales como Facebook y Twitter luchan constantemente por encontrar el equilibrio adecuado entre la libertad de expresión y la moderación, dice.

«Hay un punto en el que la gente abandona la plataforma», dice Martin. «Contenido totalmente no moderado, donde puedes decir todo el material horrible que quieras, hay una razón por la cual la gente no acude a él. Porque si bien parece un choque de trenes cuando lo vemos, no queremos ser inundados con todo el tiempo. Creo que hay un rechazo natural».

Los cambios recientes de Elon Musk en Twitter han transformado este debate de un ejercicio académico a un caso de prueba en tiempo real. Musk puede haber pensado que la cuestión de si prohibir a Donald Trump era central, dice Martin. Un solo ejecutivo puede decidir una prohibición, pero elegir qué recomendar requiere tecnología como algoritmos e inteligencia artificial, y personas para diseñarlo y ejecutarlo.

«Lo que es diferente en este momento con Twitter es deshacerse de todas las personas que realmente hicieron eso», dice Martin. «El algoritmo de moderación de contenido es tan bueno como las personas que lo etiquetaron. Si cambias a las personas que toman esas decisiones o si te deshaces de ellas, entonces tu algoritmo de moderación de contenido se volverá obsoleto y con bastante rapidez».

Martin, experto en privacidad, tecnología y ética empresarial y profesor del Centro William P. y Hazel B. White de Ética Tecnológica en la Facultad de Negocios de Mendoza, ha analizado de cerca la promoción de contenido. Preocupada por las críticas sobre la desinformación en línea antes de las elecciones presidenciales de 2016, dice, las empresas de redes sociales establecieron nuevas barreras sobre qué contenido y grupos recomendar en el período previo a las elecciones de 2020.

Facebook y Twitter fueron conscientemente proactivos en la moderación de contenido, pero se detuvieron después de que cerraron las urnas. Martin dice que Facebook «pensó que las elecciones habían terminado» y sabía que sus algoritmos recomendaban grupos de odio, pero no se detuvo porque «ese tipo de material generaba mucha participación». Con más de mil millones de usuarios, el impacto fue profundo.

Martin escribió un artículo sobre este tema en un libro de texto de estudio de caso («Ética de datos y análisis«) editó, publicado en 2022. En «Recomendar una insurrección: Facebook y los algoritmos de recomendación», argumenta que Facebook tomó decisiones conscientes para priorizar el compromiso porque esa fue la métrica elegida para el éxito.

«Si bien la eliminación de una sola cuenta puede aparecer en los titulares, la sutil promoción y recomendación de contenido impulsó la participación de los usuarios», escribió. «Y, como descubrieron Facebook y otras plataformas, la participación de los usuarios no siempre se correspondía con el mejor contenido». El propio autoanálisis de Facebook descubrió que su tecnología conducía a la desinformación y la radicalización. En abril de 2021, un informe interno de Facebook encontró que «Facebook no logró evitar que un movimiento influyente usara su plataforma para deslegitimar las elecciones, alentar la violencia y ayudar a incitar los disturbios en el Capitolio».

Una pregunta central es si el problema es culpa de la plataforma o de los usuarios de la plataforma. Martin dice que este debate dentro de la filosofía de la tecnología se asemeja al conflicto sobre las armas, donde algunas personas culpan a las armas y otras a las personas que las usan por el daño. «O la tecnología es una pizarra en blanco neutral, o en el otro extremo del espectro, la tecnología determina todo y casi evoluciona por sí sola», dice ella. «De cualquier manera, la empresa que dirige esta tecnología determinista o culpa a los usuarios, la empresa que realmente la diseña no tiene responsabilidad alguna.

«A eso me refiero con las empresas que se esconden detrás de esto, casi diciendo: ‘Tanto el proceso mediante el cual se toman las decisiones como la decisión en sí misma están tan encasilladas o son tan neutrales que no soy responsable de ninguno de sus diseños o resultados». ‘» Martin rechaza ambas afirmaciones.

Un ejemplo que ilustra su convicción es la promoción que hace Facebook de los superusuarios, personas que publican material constantemente. La empresa amplificó a los superusuarios porque eso impulsó la participación, incluso si estos usuarios tendían a incluir más discursos de odio. Piensa en las granjas de trolls rusos. Los ingenieros informáticos descubrieron esta tendencia y propusieron resolverla modificando el algoritmo. Los documentos filtrados han demostrado que el taller de políticas de la compañía anuló a los ingenieros porque temían un impacto en el compromiso. Además, temían ser acusados de parcialidad política porque los grupos de extrema derecha a menudo eran súper usuarios.

Otro ejemplo en el libro de texto de Martin presenta a un conductor de Amazon despedido después de cuatro años de entregar paquetes en Phoenix. Recibió un correo electrónico automático porque los algoritmos que rastreaban su desempeño «decidieron que no estaba haciendo su trabajo correctamente».

La empresa era consciente de que delegar la decisión de disparar a las máquinas podría generar errores y titulares dañinos, «pero decidió que era más barato confiar en los algoritmos que pagar a la gente para que investigara los disparos erróneos, siempre que los controladores pudieran reemplazarse fácilmente». En cambio, Martin argumenta que reconocer los «sesgos de la tecnología cargados de valor» es necesario para preservar la capacidad de los humanos para controlar el diseño, el desarrollo y el despliegue de esa tecnología.

El debate sobre la moderación de contenido en línea se remonta a Sección 230 de la Ley de Decencia en las Comunicaciones. En 1995, una plataforma en línea fue demandada por difamación por la publicación de un usuario en su tablón de anuncios. La demanda tuvo éxito en parte porque la plataforma intentó eliminar el contenido dañino, lo que implica que la moderación condujo a la responsabilidad total, lo que desalentó cualquier intento.

En respuesta, el Congreso aprobó la Sección 230 para proteger el modelo comercial de la plataforma y alentar la automoderación. «La idea es que incluso si entras y tratas de moderarlo, no te trataremos como un periódico», dice Martin. «Usted no será responsable por el contenido de su sitio».

Las empresas de redes sociales han tenido éxito y han sido proactivas con respecto a algunos tipos de moderación. Cuando hay un consenso en contra de un tipo de contenido, como la pornografía infantil o el material con derechos de autor, lo eliminan rápidamente. Los problemas comienzan cuando hay un debate generalizado sobre lo que es dañino.

En casos difíciles, las empresas a veces usan la Sección 230 para adoptar un enfoque de no intervención, alegando que solo más contenido puede abrumar las mentiras. Martin dice que argumentan que no hay forma de hacerlo mejor: «Si nos regulan, vamos a cerrar».

Ella compara esto con General Motors en la década de 1970 afirmando que no podían poner cinturones de seguridad en los automóviles para hacerlos más seguros, o con las compañías siderúrgicas que afirman que no podían evitar la contaminación.

«Es una especie de evolución normal de una industria que crece muy rápido sin demasiada regulación o demasiada reflexión», dice Martin. “La gente retrocede y dice: ‘Oye, nos gustaría algo diferente’. Se darán cuenta. GM agregó cinturones de seguridad. Eventualmente, tendremos mejores compañías de redes sociales».

Martin puede ser optimista porque es fanática de la tecnología.

«No es que las personas que critican las redes sociales quieran que desaparezcan», dice. «Quieren que cumpla todo lo que puede ser. Les gusta el lado positivo».

Las redes sociales pueden conectar almas afines con un interés especializado o personas que se sienten solas. Eso fue especialmente valioso durante la pandemia. Las personas que viven bajo regímenes totalitarios pueden comunicarse rápida y fácilmente, evitando el control gubernamental de la tecnología más antigua.

A principios de la década de 2010, Facebook fue visto como una poderosa fuerza de libertad durante la Primavera Árabe, cuando los manifestantes se organizaron en línea y derrocaron a los líderes autoritarios en el norte de África y Medio Oriente.

Traído a casa, ese poder también puede tener un inconveniente, dependiendo de la perspectiva. «Si puedo comunicarme con alguien que es como yo, eso significa que si quiero planear una insurrección, puedo encontrar a alguien más que quiera planear una insurrección», dice Martin.

«Muchas veces, las personas que hablan fuerte sobre el odio tienen seguidores que lo ven como un llamado a las armas», dice Martin. “No es solo una persona, como Alex Jones diciéndoles a las víctimas de Sandy Hook, ‘ustedes no existen y eso nunca sucedió’. Es que hay miles de personas que luego también se dirigirán a esas personas en línea y fuera de línea. Creo que es malinterpretar la asimetría de los acosadores».

Los fenómenos recientes, desde la desinformación sobre el COVID-19 en Facebook hasta el efecto de Instagram en la imagen corporal de los adolescentes, pueden haber agriado a algunas personas en las redes sociales desde su promesa inicial. Martin identifica Gamergate en 2014 como el impulso del cambio en la percepción de muchas personas. Una campaña de acoso en línea poco organizada se enfocó en el feminismo y la diversidad en la cultura de los videojuegos, lo que generó muchos de los peores comportamientos que siguieron.

Martin dice que los usuarios de las redes sociales deben exigir moderación cuando el discurso de odio va demasiado lejos. Los anunciantes pueden ser otra fuerza poderosa. «Las marcas no quieren que el nuevo Cadillac eléctrico esté justo al lado de un puesto de supremacistas blancos», dice.

Musk puede preocuparse más por el discurso que quiere promover que por los grupos específicos en este momento, pero esa elección podría abrir la puerta a un competidor como Mastodon. Por su parte, Martín seguirá identificando los problemas y confía en que la tecnología pueda corregir el rumbo para brindar un beneficio social.

«Siempre pienso que la ética tecnológica tiene dos vertientes», dice. “Uno es un examen de evaluación crítica de la tecnología. Pero el otro lado es ayudar a las personas a descubrir cómo diseñar y desarrollar una mejor tecnología. El conjunto de habilidades para hacer ambas cosas no está necesariamente en la misma persona.

«Necesitas personas que digan lo que está mal y luego otras personas que digan: ‘Oh, podría arreglar eso y así es como lo haría de manera diferente'».

Citación: El experto promueve el equilibrio de la moderación y el compromiso en la ética de la tecnología (2023, 15 de febrero) consultado el 15 de febrero de 2023 en https://techxplore.com/news/2023-02-expert-moderation-engagement-technology-ethics.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.