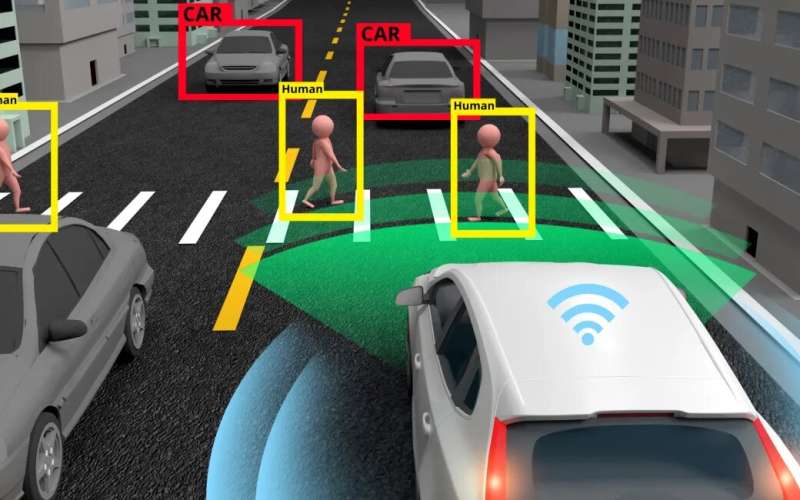

Se espera que los vehículos autónomos tengan mejores medidas de seguridad que los conductores humanos. Cuanto más crítico es el sistema, más relevante es la capacidad de minimizar los riesgos asociados. Crédito: Akarat Phasura

Un artículo titulado «Sobre el mal comportamiento y la tolerancia a fallos en los sistemas de aprendizaje automático», de la investigadora doctoral Lalli Myllyaho, fue nombrado uno de los mejores artículos de 2022 por la Revista de Sistemas y Software.

“La idea fundamental del estudio es que si pones sistemas críticos en manos de inteligencia artificial y algoritmos, también debes aprender a prepararte para su falla”, dice Myllyaho.

Puede que no sea necesariamente peligroso si un servicio de transmisión sugiere opciones poco interesantes para los usuarios, pero tal comportamiento socava la confianza en la funcionalidad del sistema. Sin embargo, las fallas en los sistemas más críticos que dependen del aprendizaje automático pueden ser mucho más dañinas.

«Quería investigar cómo prepararme para, por ejemplo, que la visión artificial identifique cosas erróneamente. Por ejemplo, en la tomografía computarizada, la inteligencia artificial puede identificar objetos en secciones. Si se producen errores, surgen dudas sobre hasta qué punto se debe confiar en las computadoras en tales asuntos. , y cuándo pedirle a un humano que eche un vistazo», dice Myllyaho.

Cuanto más crítico es el sistema, más relevante es la capacidad de minimizar los riesgos asociados.

Los sistemas más complejos generan errores cada vez más complejos

Además de Myllyaho, el estudio fue realizado por Mikko Raatikainen, Tomi Männistö, Jukka K. Nurminen y Tommi Mikkonen. La publicación está estructurada en torno a entrevistas a expertos.

«Se entrevistó a los arquitectos de software sobre los defectos y las imprecisiones en los modelos de aprendizaje automático y en torno a ellos. Y también queríamos averiguar qué opciones de diseño se podían tomar para evitar fallas», dice Myllyaho.

Si los modelos de aprendizaje automático contienen datos erróneos, el problema puede extenderse a los sistemas en cuya implementación se han utilizado los modelos. También es necesario determinar qué mecanismos son adecuados para corregir errores.

«Las estructuras deben diseñarse para evitar que los errores radicales se intensifiquen. En última instancia, la gravedad a la que puede progresar el problema depende del sistema».

Por ejemplo, es fácil que la gente entienda que con los vehículos autónomos, el sistema requiere varios mecanismos de seguridad y protección. Esto también se aplica a otras soluciones de IA que necesitan modos seguros que funcionen correctamente.

«Tenemos que investigar cómo garantizar que, en una variedad de circunstancias, la inteligencia artificial funcione como debería, es decir, con la racionalidad humana. La solución más adecuada no siempre es evidente, y los desarrolladores deben tomar decisiones sobre qué hacer cuando no puedes estar seguro de ello».

Myllyaho ha ampliado el estudio al desarrollar un mecanismo relacionado para identificar fallas, aunque aún no ha avanzado a un algoritmo real.

«Es solo una idea de las redes neuronales. Un modelo funcional de aprendizaje automático podría cambiar los modelos de trabajo sobre la marcha si el actual no funciona. En otras palabras, también debería poder predecir errores o reconocer indicaciones de errores».

Recientemente, Myllyaho se ha concentrado en finalizar su tesis doctoral, por lo que no puede decir nada sobre su futuro en el proyecto. El proyecto IVVES encabezado por Jukka K. Nurminen seguirá desarrollando su labor de testeo de la seguridad de los sistemas de aprendizaje automático.

Más información:

Lalli Myllyaho et al, Sobre el mal comportamiento y la tolerancia a fallas en los sistemas de aprendizaje automático, Revista de Sistemas y Software (2022). DOI: 10.1016/j.jss.2021.111096

Citación: Estudio: No se puede confiar en los modelos de aprendizaje automático con certeza absoluta (2023, 18 de abril) recuperado el 18 de abril de 2023 de https://techxplore.com/news/2023-04-machine-absolute-certainty.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.