Crédito: Melanie Deziel / Unsplash

como el «guerras de chatbotsfuror en Silicon Valley, la creciente proliferación de herramientas de inteligencia artificial (IA) diseñadas específicamente para generar texto parecido a un humano tiene dejó a muchos desconcertados.

Los educadores en particular se esfuerzan por adaptarse a la disponibilidad de software que puede producir un ensayo moderadamente competente sobre cualquier tema en cualquier momento. ¿Deberíamos volver a las evaluaciones de lápiz y papel? ¿Aumentar la supervisión de los exámenes? ¿Prohibir el uso de IA por completo?

Todo esto y más se han propuesto. Sin embargo, ninguna de estas medidas menos que ideales sería necesaria si los educadores pudieran distinguir de forma fiable Texto generado por IA y escrito por humanos.

Profundizamos en varios métodos y herramientas propuestos para reconocer texto generado por IA. Ninguno de ellos es infalible, todos son vulnerables a las soluciones alternativas y es poco probable que alguna vez sean tan confiables como nos gustaría.

Quizás se esté preguntando por qué las principales empresas de inteligencia artificial del mundo no pueden distinguir de manera confiable los productos de sus propias máquinas del trabajo de los humanos. La razón es ridículamente simple: la misión corporativa en los brazos de IA de alto riesgo de hoy en día es entrenar IA de «procesador de lenguaje natural» (NLP) para producir resultados que sean lo más similares posible a la escritura humana. De hecho, las demandas públicas de un medio fácil para detectar tales IA en la naturaleza pueden parecer paradójicas, como si nos estuviéramos perdiendo el objetivo del programa.

Un esfuerzo mediocre

OpenAI, el creador de ChatGPT, lanzó un «clasificador para indicar texto escrito por IA«a finales de enero.

El clasificador fue entrenado en IA externas, así como en los propios motores de generación de texto de la empresa. En teoría, esto significa que debería poder marcar ensayos generados por BLOOM IA o similares, no solo los creados por ChatGPT.

Le damos a este clasificador una calificación C– en el mejor de los casos. OpenAI admite que identifica con precisión solo el 26 % del texto generado por IA (verdadero positivo), mientras que etiqueta incorrectamente la prosa humana como generada por IA el 9 % de las veces (falso positivo).

OpenAI no ha compartido su investigación sobre la tasa a la que el texto generado por IA se etiqueta incorrectamente como texto generado por humanos (falso negativo).

Un contendiente prometedor

Un competidor más prometedor es un clasificador creado por un estudiante de la Universidad de Princeton durante sus vacaciones de Navidad.

eduardo tianuna licenciatura en informática con mención en periodismo, lanzó la primera versión de GPTZero en Enero.

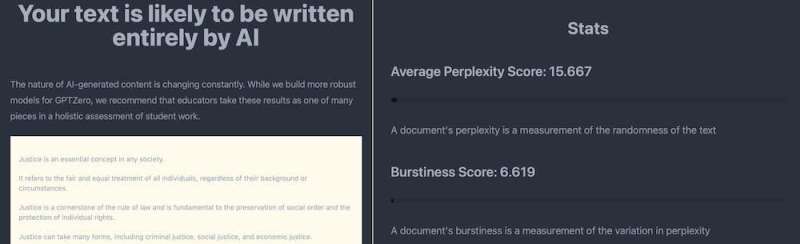

Esta aplicación identifica la autoría de la IA en función de dos factores: perplejidad y explosión. La perplejidad mide qué tan complejo es un texto, mientras que la ráfaga compara la variación entre oraciones. Cuanto más bajos sean los valores de estos dos factores, más probable es que un texto haya sido producido por una IA.

Enfrentamos a este modesto David contra el goliat de ChatGPT.

Primero, solicitamos a ChatGPT que generara un breve ensayo sobre la justicia. A continuación, copiamos el artículo, sin cambios, en GPTZero. La herramienta de Tian determinó correctamente que era probable que el texto hubiera sido escrito en su totalidad por una IA porque sus puntajes promedio de perplejidad y explosión eran muy bajos.

GPTZero mide la complejidad y variedad dentro de un texto para determinar si es probable que haya sido producido por IA. Crédito: GTPZero

Engañando a los clasificadores

Una manera fácil de engañar a los clasificadores de IA es simplemente reemplazar algunas palabras con sinónimos. Los sitios web que ofrecen herramientas que parafrasean el texto generado por IA para este propósito ya están apareciendo en Internet.

Muchas de estas herramientas muestran su propio conjunto de obsequios de IA, como salpicar la prosa humana con «frases torturadas» (por ejemplo, usando «conciencia falsificada» en lugar de «IA»).

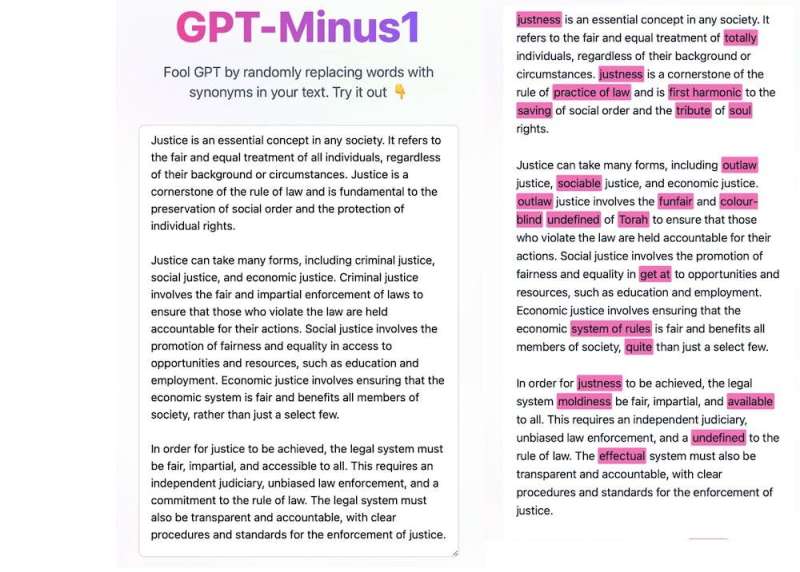

Para probar GPTZero aún más, copiamos el ensayo de justicia de ChatGPT en GPT-Menos1—un sitio web que ofrece «codificar» el texto de ChatGPT con sinónimos. La imagen de la izquierda muestra el ensayo original. La imagen de la derecha muestra los cambios de GPT-Minus1. Alteró alrededor del 14% del texto.

GPT-Minus1 realiza pequeños cambios en el texto para que parezca menos generado por IA. Crédito: GPT-Menos1

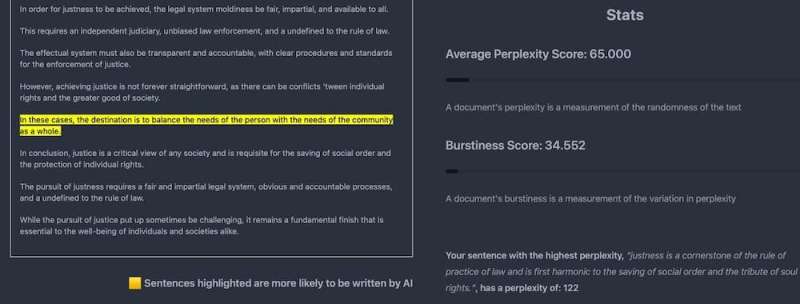

Luego copiamos la versión GPT-Minus1 del ensayo de justicia nuevamente en GPTZero. ¿Su veredicto?

«Lo más probable es que su texto esté escrito por humanos, pero hay algunas oraciones con pocas perplejidades».

Resaltó solo una oración que pensó que tenía una alta probabilidad de haber sido escrita por una IA (ver la imagen a continuación a la izquierda) junto con un informe sobre las puntuaciones generales de perplejidad y explosión del ensayo que eran mucho más altas (ver la imagen a continuación a la derecha).

Ejecutar un texto generado por IA a través de una herramienta de engaño de IA hace que parezca «más humano». Crédito: GPTZero

Herramientas como la de Tian son muy prometedoras, pero no son perfectas y también son vulnerables a las soluciones temporales. Por ejemplo, un tutorial de YouTube publicado recientemente explica cómo solicitar a ChatGPT que produzca texto con altos grados de, lo adivinó, perplejidad y explosión.

marca de agua

Otra propuesta es que el texto escrito por IA contenga una «marca de agua» que sea invisible para los lectores humanos pero que el software pueda detectar.

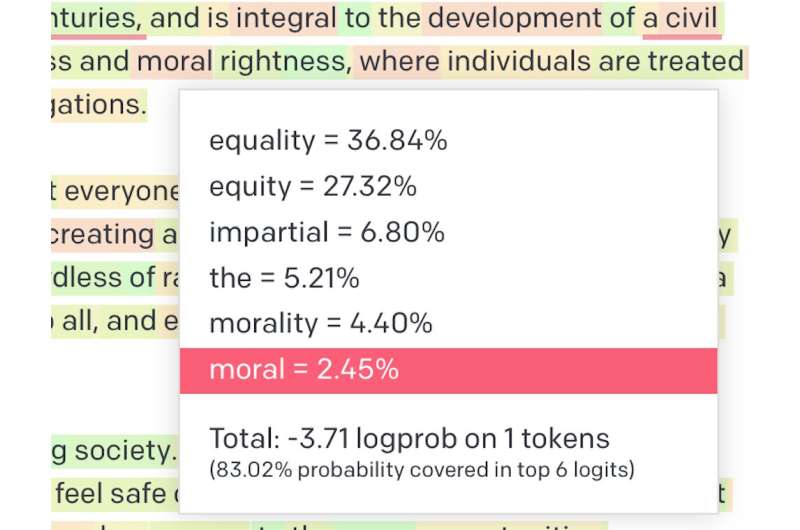

Los modelos de lenguaje natural funcionan palabra por palabra. Seleccionan qué palabra generar en función de la probabilidad estadística.

Sin embargo, no siempre eligen palabras con la mayor probabilidad de aparecer juntas. En cambio, de una lista de palabras probables, seleccionan una al azar (aunque es más probable que se seleccionen palabras con puntajes de probabilidad más altos).

Esto explica por qué los usuarios obtienen un resultado diferente cada vez que generan texto usando el mismo aviso.

Una de las interfaces del modelo de lenguaje natural de OpenAI (Playground) brinda a los usuarios la capacidad de ver la probabilidad de las palabras seleccionadas. En la captura de pantalla anterior (capturada el 1 de febrero de 2023), podemos ver que la probabilidad de que se seleccione el término «moral» es del 2,45 %, que es mucho menor que la «igualdad» con un 36,84 %. Crédito: Zona de juegos OpenAI

En pocas palabras, la marca de agua implica «poner en una lista negra» algunas de las palabras probables y permitir que la IA solo seleccione palabras de una «lista blanca». Dado que un texto escrito por humanos probablemente incluirá palabras de la «lista negra», esto podría hacer posible diferenciarlo de un texto generado por IA.

Sin embargo, la marca de agua también tiene limitaciones. La calidad del texto generado por IA podría verse reducida si se restringiera su vocabulario. Además, cada generador de texto probablemente tendría un sistema de marca de agua diferente, por lo que el texto se compararía con todos ellos.

La marca de agua también se puede eludir con herramientas de paráfrasis, que pueden insertar palabras en la lista negra o reformular preguntas de ensayo.

Una carrera armamentista en curso

Los detectores de texto generados por IA serán cada vez más sofisticados. Servicio antiplagio TurnItIn anunció recientemente un próximo detector de escritura de IA con una precisión del 97 %.

Sin embargo, los generadores de texto también se volverán más sofisticados. El competidor ChatGPT de Google, Bard, está en pruebas públicas tempranas. OpenAI en sí mismo es esperado para lanzar una actualización importante, GPT-4, a finales de este año.

Nunca será posible hacer que los identificadores de texto de IA sean perfectos, ya que incluso OpenAI reconocey siempre habrá nuevas formas de engañarlos.

A medida que continúa esta carrera armamentista, es posible que veamos el aumento de la «paráfrasis de contratos»: en lugar de pagarle a alguien para que escriba su tarea, le paga a alguien para que reelabore su tarea generada por IA para pasar los detectores.

No hay respuestas fáciles aquí para los educadores. Los arreglos técnicos pueden ser parte de la solución, pero también lo serán las nuevas formas de enseñanza y evaluación (que pueden incluir el aprovechamiento del poder de la IA).

No sabemos exactamente cómo será esto. Sin embargo, dedicamos el último año a crear prototipos de herramientas de inteligencia artificial de código abierto para la educación y la investigación en un esfuerzo por ayudar a navegar por un camino entre lo antiguo y lo nuevo, y puede acceder a las versiones beta en IA a prueba de fallos.

Este artículo se vuelve a publicar de La conversación bajo una licencia Creative Commons. Leer el artículo original.![]()

Citación: Enfrentamos a ChatGPT con herramientas para detectar texto escrito por IA y los resultados son preocupantes (2023, 20 de febrero) consultado el 20 de febrero de 2023 en https://techxplore.com/news/2023-02-pitted-chatgpt-tools-ai -texto-escrito.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.