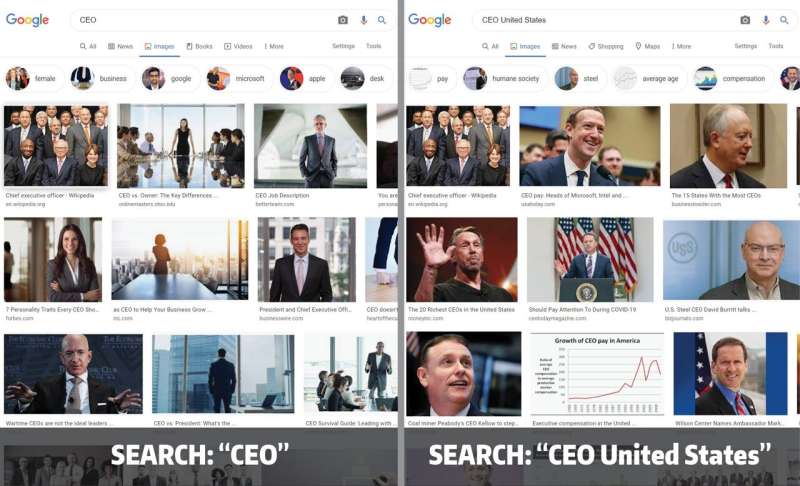

Investigadores de la Universidad de Washington demostraron que los resultados de búsqueda de imágenes de cuatro motores de búsqueda importantes de todo el mundo, incluido Google, reflejan sesgos de género. Una búsqueda de una ocupación, como «CEO», arrojó resultados con una proporción de personas cis-masculinas y cis-femeninas que coinciden con las estadísticas actuales. Pero cuando el equipo agregó otro término de búsqueda, por ejemplo, «CEO Estados Unidos», la búsqueda de imágenes arrojó menos fotos de personas que presentaban mujeres cis. Crédito: Universidad de Washington

Usamos la búsqueda de imágenes de Google para ayudarnos a comprender el mundo que nos rodea. Por ejemplo, una búsqueda sobre una determinada profesión, por ejemplo, «conductor de camión», debería arrojar imágenes que nos muestren una muestra representativa de las personas que se ganan la vida conduciendo camiones.

Pero en 2015, los investigadores de la Universidad de Washington (UW) descubrieron que al buscar una variedad de ocupaciones, incluido «CEO», las mujeres estaban significativamente subrepresentadas en los resultados de las imágenes y que estos resultados pueden cambiar la visión del mundo de los buscadores. Desde entonces, Google ha afirmado haber solucionado este problema.

Un equipo diferente de UW investigó recientemente la veracidad de la empresa. Los investigadores demostraron que para cuatro de los principales motores de búsqueda de todo el mundo, incluido Google, este sesgo solo se corrige parcialmente, según un artículo presentado en febrero en la Conferencia AAAI de Inteligencia Artificial. Una búsqueda de una ocupación, como «CEO», arrojó resultados con una proporción de personas cis-masculinas y cis-femeninas que coinciden con las estadísticas actuales. Pero cuando el equipo agregó otro término de búsqueda, por ejemplo, «CEO + Estados Unidos», la búsqueda de imágenes arrojó menos fotos de personas que presentaban mujeres cis. En el documento, los investigadores proponen tres posibles soluciones a este problema.

«Mi laboratorio ha estado trabajando en el tema del sesgo en los resultados de búsqueda durante un tiempo, y nos preguntamos si este sesgo de búsqueda de imágenes del CEO solo se había solucionado en la superficie», dijo el autor principal Chirag Shah, profesor asociado de la Escuela de Información de la Universidad de Washington. . «Queríamos poder demostrar que este es un problema que se puede solucionar sistemáticamente para todos los términos de búsqueda, en lugar de algo que tiene que solucionarse con este tipo de enfoque de ‘golpear un topo’, un problema a la vez. «

El equipo investigó los resultados de búsqueda de imágenes de Google, así como del motor de búsqueda chino Baidu, Naver de Corea del Sur y Yandex de Rusia. Los investigadores realizaron una búsqueda de imágenes de 10 ocupaciones comunes, incluidos director ejecutivo, biólogo, programador de computadoras y enfermera, con y sin un término de búsqueda adicional, como «Estados Unidos».

«Este es un enfoque común para estudiar los sistemas de aprendizaje automático», dijo el autor principal Yunhe Feng, becario postdoctoral de la UW en iSchool. «Al igual que la gente hace pruebas de choque en automóviles para asegurarse de que están seguros, los investigadores de privacidad y seguridad intentan desafiar los sistemas informáticos para ver qué tan bien funcionan. Aquí, simplemente cambiamos el término de búsqueda ligeramente. No esperábamos ver salidas tan diferentes».

Para cada búsqueda, el equipo recopiló las 200 imágenes principales y luego utilizó una combinación de voluntarios y un software de inteligencia artificial de detección de género para identificar cada rostro como una presentación cis-masculina o cis-femenina.

Una limitación de este estudio es que asume que el género es binario, reconocieron los investigadores. Pero eso les permitió comparar sus hallazgos con los datos de la Oficina de Estadísticas Laborales de EE. UU. para cada ocupación.

Los investigadores tenían especial curiosidad acerca de cómo cambiaba la proporción de sesgo de género según la cantidad de imágenes que miraban.

«Sabemos que las personas pasan la mayor parte de su tiempo en la primera página de los resultados de búsqueda porque quieren encontrar una respuesta muy rápidamente», dijo Feng. «Pero tal vez si las personas se desplazaran más allá de la primera página de resultados de búsqueda, comenzarían a ver más diversidad en las imágenes».

Cuando el equipo agregó «+ Estados Unidos» a las búsquedas de imágenes de Google, algunas ocupaciones tenían proporciones de sesgo de género más altas que otras. Mirar más imágenes a veces resolvía estos sesgos, pero no siempre.

Mientras que los otros motores de búsqueda mostraron diferencias para ocupaciones específicas, la tendencia general se mantuvo: la adición de otro término de búsqueda cambió la proporción de género.

«Esto no es solo un problema de Google», dijo Shah. «No quiero que parezca que estamos jugando algún tipo de favoritismo hacia otros motores de búsqueda. Baidu, Naver y Yandex son todos de diferentes países con diferentes culturas. Este problema parece ser rampante. Este es un problema para todos de ellos.»

El equipo diseñó tres algoritmos para abordar sistemáticamente el problema. El primero baraja aleatoriamente los resultados.

«Este trata de sacudir las cosas para evitar que sea tan homogéneo en la parte superior», dijo Shah.

Los otros dos algoritmos agregan más estrategia al barajado de imágenes. Uno incluye la «puntuación de relevancia» de la imagen, que los motores de búsqueda asignan en función de la relevancia de un resultado para la consulta de búsqueda. El otro requiere que el motor de búsqueda conozca los datos de la oficina de estadísticas y luego el algoritmo mezcla los resultados de la búsqueda para que las imágenes mejor clasificadas sigan la tendencia real.

Los investigadores probaron sus algoritmos en los conjuntos de datos de imágenes recopilados de las búsquedas de Google, Baidu, Naver y Yandex. Para ocupaciones con una gran proporción de sesgo, por ejemplo, «biólogo + Estados Unidos» o «CEO + Estados Unidos», los tres algoritmos lograron reducir el sesgo de género en los resultados de búsqueda. Pero para las ocupaciones con una proporción de sesgo más pequeña, por ejemplo, «conductor de camión + Estados Unidos», solo el algoritmo con conocimiento de las estadísticas reales pudo reducir el sesgo.

Aunque los algoritmos del equipo pueden reducir sistemáticamente el sesgo en una variedad de ocupaciones, el verdadero objetivo será ver que este tipo de reducciones aparezcan en las búsquedas en Google, Baidu, Naver y Yandex.

«Podemos explicar por qué y cómo funcionan nuestros algoritmos», dijo Feng. «Pero el modelo de IA detrás de los motores de búsqueda es una caja negra. Puede que el objetivo de estos motores de búsqueda no sea presentar la información de manera justa. Es posible que estén más interesados en lograr que sus usuarios interactúen con los resultados de búsqueda».

La nueva herramienta de Google facilita que los menores eliminen imágenes de sí mismos de los resultados de búsqueda

Citación: El sesgo de género de la búsqueda de imágenes del ‘CEO’ de Google realmente no se ha solucionado: estudio (2022, 16 de febrero) recuperado el 16 de febrero de 2022 de https://techxplore.com/news/2022-02-google-ceo-image-gender- sesgo.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.