MTJ para computación neuromórfica binaria. Crédito: Ingeniería de Comunicaciones (2025). DOI: 10.1038/s44172-025-00479-2

¿Podrían las computadoras aprender más como lo hacen los humanos, sin depender de sistemas de inteligencia artificial (IA) que deben someterse a una capacitación extremadamente costosa?

La computación neuromórfica podría ser la respuesta. Esta tecnología emergente presenta hardware informático inspirado en el cerebro que podría realizar tareas de IA de manera mucho más eficiente con muchos menos cálculos de entrenamiento y utilizando mucha menos energía que los sistemas convencionales. En consecuencia, las computadoras neuromórficas también tienen el potencial de reducir la dependencia de los centros de datos que consumen mucha energía y llevar la inferencia y el aprendizaje de la IA a los dispositivos móviles.

El Dr. Joseph S. Friedman, profesor asociado de ingeniería eléctrica e informática en la Universidad de Texas en Dallas, y su equipo de investigadores en el Laboratorio NeuroSpinCompute han dado un importante paso adelante en la construcción de una computadora neuromórfica al crear un prototipo a pequeña escala que aprende patrones y hace predicciones utilizando menos cálculos de entrenamiento que los sistemas de IA convencionales. Su próximo desafío es ampliar la prueba de concepto a tamaños más grandes.

«Nuestro trabajo muestra un nuevo camino potencial para construir computadoras inspiradas en el cerebro que puedan aprender por sí mismas», dijo Friedman. «Dado que las computadoras neuromórficas no necesitan cantidades masivas de cálculos de entrenamiento, podrían alimentar dispositivos inteligentes sin enormes costos de energía».

El equipo, que incluía investigadores de Everspin Technologies Inc. y Texas Instruments, describió el prototipo en un estudio. publicado en Ingeniería de Comunicaciones.

Las computadoras convencionales y las unidades de procesamiento gráfico mantienen el almacenamiento de memoria separado del procesamiento de la información. Como resultado, no pueden hacer inferencias de IA con tanta eficiencia como lo hace el cerebro humano. También requieren grandes cantidades de datos etiquetados y una enorme cantidad de cálculos de entrenamiento complejos. Los costos de estos cálculos de entrenamiento pueden ascender a cientos de millones de dólares.

Las computadoras neuromórficas integran el almacenamiento de memoria con el procesamiento, lo que les permite realizar operaciones de IA con mucha mayor eficiencia y menores costos. El hardware neuromórfico está inspirado en el cerebro, donde las redes de neuronas y sinapsis procesan y almacenan información, respectivamente. Las sinapsis forman las conexiones entre las neuronas, fortaleciéndose o debilitándose según patrones de actividad. Esto permite que el cerebro se adapte continuamente a medida que aprende.

El enfoque de Friedman se basa en un principio propuesto por el neuropsicólogo Dr. Donald Hebb, conocido como ley de Hebb: neuronas que se activan juntas, se conectan entre sí.

«El principio que utilizamos para que una computadora aprenda por sí sola es que si una neurona artificial hace que otra neurona artificial se active, la sinapsis que las conecta se vuelve más conductora», dijo Friedman.

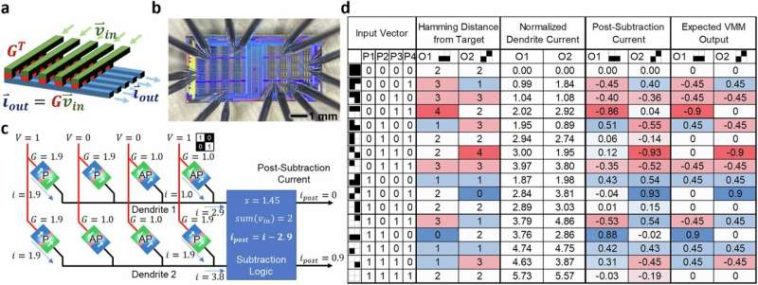

Una innovación importante en el diseño de Friedman es el uso de uniones de túnel magnético (MTJ), dispositivos a nanoescala que constan de dos capas de material magnético separadas por una capa aislante. Los electrones pueden viajar, o hacer túneles, a través de esta barrera más fácilmente cuando las magnetizaciones de las capas están alineadas en la misma dirección y menos fácilmente cuando están alineadas en direcciones opuestas.

En los sistemas neuromórficos, los MTJ se pueden conectar en redes para imitar la forma en que el cerebro procesa y aprende patrones. A medida que las señales pasan a través de los MTJ de manera coordinada, sus conexiones se ajustan para fortalecer ciertas vías, de la misma manera que las conexiones sinápticas en el cerebro se refuerzan durante el aprendizaje. La conmutación binaria de los MTJ los hace confiables para almacenar información, resolviendo un desafío que durante mucho tiempo ha impedido enfoques neuromórficos alternativos.

Más información:

Peng Zhou et al, Aprendizaje neuromórfico hebbiano con sinapsis de unión de túnel magnético, Ingeniería de Comunicaciones (2025). DOI: 10.1038/s44172-025-00479-2

Citación: El prototipo de computadora neuromórfica aprende patrones con menos cálculos que la IA tradicional (2025, 29 de octubre) recuperado el 29 de octubre de 2025 de https://techxplore.com/news/2025-10-neuromorphic-prototype-patterns-traditional-ai.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.