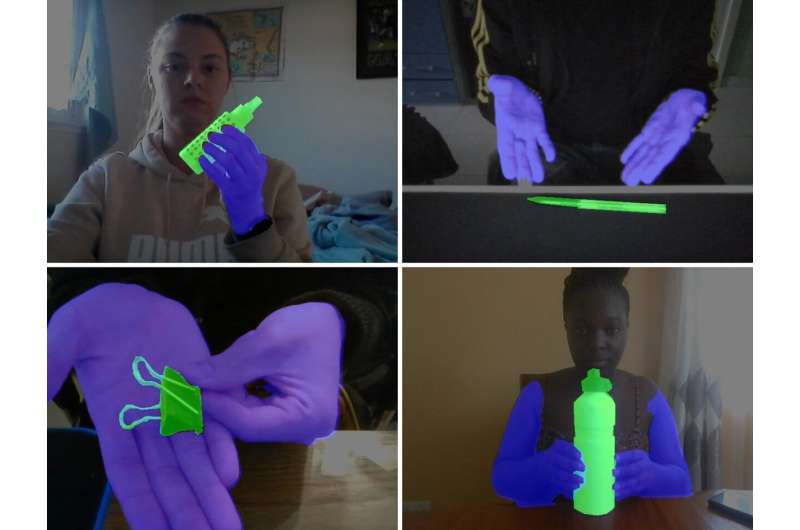

En cada imagen del conjunto de datos personalizados de HuTics, las manos de los usuarios se visualizan en azul y el objeto en verde. HuTics se utiliza para entrenar un modelo de aprendizaje automático. Crédito: ©2022 Yatani y Zhou

Muchos sistemas informáticos con los que las personas interactúan a diario requieren conocimientos sobre ciertos aspectos del mundo, o modelos, para funcionar. Estos sistemas tienen que ser entrenados, a menudo necesitando aprender a reconocer objetos a partir de datos de video o imagen. Estos datos frecuentemente contienen contenido superfluo que reduce la precisión de los modelos. Entonces, los investigadores encontraron una manera de incorporar gestos naturales con las manos en el proceso de enseñanza. De esta forma, los usuarios pueden enseñar a las máquinas sobre los objetos más fácilmente y las máquinas también pueden aprender de manera más efectiva.

Probablemente haya escuchado el término aprendizaje automático antes, pero ¿está familiarizado con la enseñanza automática? El aprendizaje automático es lo que sucede detrás de escena cuando una computadora usa datos de entrada para formar modelos que luego se pueden usar para realizar funciones útiles. Pero la enseñanza automática es la parte del proceso algo menos explorada, que se ocupa de cómo la computadora obtiene sus datos de entrada para empezar.

En el caso de los sistemas visuales, por ejemplo, los que pueden reconocer objetos, las personas necesitan mostrar objetos a una computadora para que pueda aprender sobre ellos. Pero hay inconvenientes en la forma en que esto se hace típicamente que los investigadores del Laboratorio de Sistemas Inteligentes Interactivos de la Universidad de Tokio intentaron mejorar.

«En un escenario típico de entrenamiento de objetos, las personas pueden sostener un objeto frente a una cámara y moverlo para que una computadora pueda analizarlo desde todos los ángulos para construir un modelo», dijo el estudiante graduado Zhongyi Zhou.

«Sin embargo, las máquinas carecen de nuestra capacidad evolucionada para aislar objetos de sus entornos, por lo que los modelos que crean pueden incluir, sin darse cuenta, información innecesaria de los fondos de las imágenes de entrenamiento. Esto a menudo significa que los usuarios deben dedicar tiempo a refinar los modelos generados, lo que puede ser bastante complicado». tarea técnica y que requiere mucho tiempo. Pensamos que debe haber una mejor manera de hacer esto que sea mejor tanto para los usuarios como para las computadoras, y con nuestro nuevo sistema, LookHere, creo que lo hemos encontrado».

Zhou, en colaboración con el profesor asociado Koji Yatani, creó LookHere para abordar dos problemas fundamentales en la enseñanza automática: primero, el problema de la eficiencia de la enseñanza, con el objetivo de minimizar el tiempo de los usuarios y el conocimiento técnico requerido. Y segundo, de la eficiencia del aprendizaje: cómo garantizar mejores datos de aprendizaje para que las máquinas creen modelos.

LookHere logra esto al hacer algo novedoso y sorprendentemente intuitivo. Incorpora los gestos de las manos de los usuarios en la forma en que se procesa una imagen antes de que la máquina la incorpore a su modelo, conocido como HuTics. Por ejemplo, un usuario puede señalar o presentar un objeto a la cámara de una manera que enfatice su importancia en comparación con los otros elementos de la escena. Así es exactamente como las personas pueden mostrarse objetos entre sí. Y al eliminar detalles superfluos, gracias al énfasis adicional en lo que es realmente importante en la imagen, la computadora obtiene mejores datos de entrada para sus modelos.

«La idea es bastante sencilla, pero la implementación fue muy desafiante», dijo Zhou. «Todo el mundo es diferente y no existe un conjunto estándar de gestos con las manos. Por lo tanto, primero recopilamos 2040 videos de ejemplo de 170 personas presentando objetos a la cámara en HuTics. Estos activos se anotaron para marcar qué era parte del objeto y qué partes del imagen eran solo las manos de la persona.

«LookHere se entrenó con HuTics y, en comparación con otros enfoques de reconocimiento de objetos, puede determinar mejor qué partes de una imagen entrante se deben usar para construir sus modelos. Para asegurarse de que sea lo más accesible posible, los usuarios pueden usar sus teléfonos inteligentes para trabajar con LookHere y el procesamiento real se realiza en servidores remotos. También lanzamos nuestro código fuente y conjunto de datos para que otros puedan desarrollarlo si lo desean».

Teniendo en cuenta la menor demanda de tiempo de los usuarios que LookHere ofrece a las personas, Zhou y Yatani descubrieron que puede crear modelos hasta 14 veces más rápido que algunos sistemas existentes. En la actualidad, LookHere se ocupa de enseñar a las máquinas sobre objetos físicos y utiliza exclusivamente datos visuales para la entrada. Pero en teoría, el concepto se puede ampliar para utilizar otros tipos de datos de entrada, como datos de sonido o científicos. Y los modelos hechos a partir de esos datos también se beneficiarían de mejoras similares en la precisión.

La investigación fue publicada como parte de El 35° Simposio Anual de ACM sobre Software y Tecnología de Interfaz de Usuario.

El nuevo enfoque de aprendizaje automático devuelve la vida a las fotos digitales

Zhongyi Zhou et al, Enseñanza de máquina interactiva consciente de gestos con anotaciones de objetos in situ, El 35° Simposio Anual de ACM sobre Software y Tecnología de Interfaz de Usuario (2022). DOI: 10.1145/3526113.3545648

Citación: El nuevo software permite a los no especialistas entrenar máquinas de forma intuitiva mediante gestos (31 de octubre de 2022) consultado el 31 de octubre de 2022 en https://techxplore.com/news/2022-10-software-nonspecialists-intuitively-machines-gestures.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.