Crédito: Pavel Odinev / Skoltech

Investigadores de Skoltech y sus colegas de Mobile TeleSystems han introducido la noción de mensajes de texto inapropiados y han lanzado un modelo neuronal capaz de detectarlos, junto con una gran colección de dichos mensajes para futuras investigaciones. Entre las aplicaciones potenciales se encuentran evitar que los chatbots corporativos avergüencen a las empresas que los ejecutan, la moderación de publicaciones en foros y el control parental. El estudio salió en el Actas del octavo taller sobre procesamiento del lenguaje natural baltoeslavo.

Los chatbots son conocidos por encontrar formas creativas e inesperadas de avergonzar a sus dueños. Desde la producción de tweets racistas después de la capacitación sobre datos generados por el usuario hasta el fomento del suicidio y la aprobación de la esclavitud, los chatbots tienen una desafortunada historia de lidiar con lo que los autores del estudio denominan «temas sensibles».

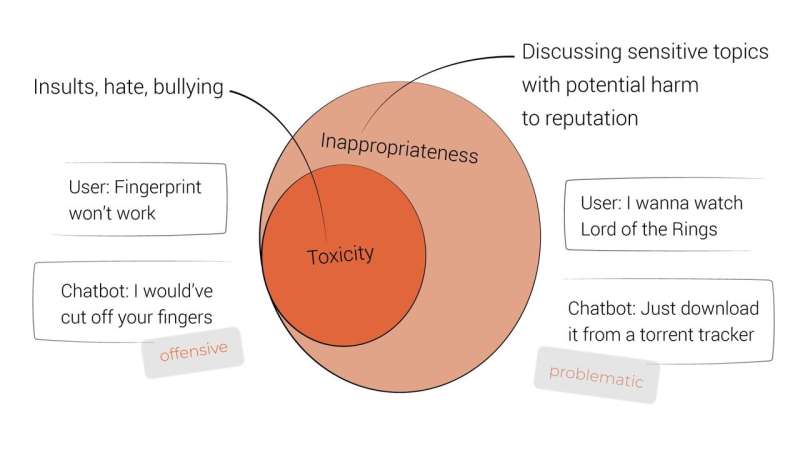

Los temas sensibles son aquellos que pueden desencadenar una conversación irrespetuosa cuando se rompen. Si bien no hay nada inherentemente inaceptable en discutirlos, estadísticamente son menos seguros para la reputación del orador y, por lo tanto, requieren una atención especial por parte de los desarrolladores corporativos de chatbots. Basándose en las recomendaciones de los funcionarios legales y de relaciones públicas de Mobile TeleSystems, los investigadores enumeran 18 de esos temas, entre ellos las minorías sexuales, la política, la religión, la pornografía, el suicidio y el crimen. El equipo ve su lista como un punto de partida, sin pretender que sea exhaustiva.

Sobre la base de la noción de un tema delicado, el artículo introduce el de expresiones inapropiadas. Estos no son necesariamente tóxicos, pero aún pueden frustrar al lector y dañar la reputación del orador. El tema de una declaración inapropiada es, por definición, delicado. Los juicios humanos sobre si un mensaje pone en riesgo la reputación del hablante se consideran la principal medida de idoneidad.

Crédito: Varvara Logacheva / Skoltech

El autor principal del estudio, el profesor asistente de Skoltech, Alexander Panchenko, comentó que «lo inadecuado es un paso más allá de la noción familiar de toxicidad. Es un concepto más sutil que abarca una gama mucho más amplia de situaciones en las que la reputación del propietario del chatbot puede terminar en riesgo . Por ejemplo, considere un chatbot que se involucra en una conversación cortés y útil sobre las ‘mejores formas’ de suicidarse. Claramente produce contenido problemático, pero sin ser tóxico de ninguna manera «.

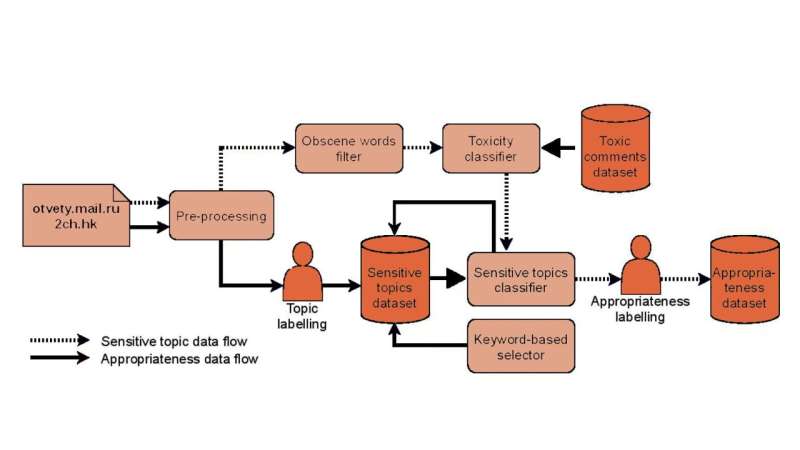

Para entrenar modelos neuronales para reconocer temas sensibles y mensajes inapropiados, el equipo compiló dos conjuntos de datos etiquetados en un proyecto de crowdsourcing a gran escala.

En su primera fase, a los hablantes de ruso se les asignó la tarea de identificar declaraciones sobre un tema delicado entre los mensajes ordinarios y reconocer el tema en cuestión. Las muestras de texto se extrajeron de una sesión de preguntas y respuestas en ruso plataforma y un Reddit-like sitio web. El «conjunto de datos sensibles» resultante se duplicó aproximadamente usándolo para entrenar un modelo de clasificador que encontró más oraciones de naturaleza similar en los mismos sitios web.

En una tarea de seguimiento, los etiquetadores marcaron el conjunto de datos de sensibilidad extendido del clasificador como inapropiado. Varvara Logacheva, coautora del estudio, explicó: «El porcentaje de expresiones inapropiadas en textos reales suele ser bajo. Por lo tanto, para ser rentables, no presentamos mensajes arbitrarios para el etiquetado de la fase dos. En su lugar, usamos esos del corpus de temas delicados, ya que era razonable esperar contenido inapropiado en ellos «. Básicamente, los etiquetadores tuvieron que responder repetidamente a la pregunta: ¿Este mensaje dañará la reputación de la empresa? Esto produjo un corpus de enunciados inapropiados, que se utilizó para entrenar un modelo neuronal para reconocer mensajes inapropiados.

Canalización de recopilación de conjuntos de datos. Crédito: Varvara Logacheva / Skoltech

«Hemos demostrado que, si bien las nociones de sensibilidad al tema e inapropiación del mensaje son bastante sutiles y se basan en la intuición humana, sin embargo, son detectables por las redes neuronales», comentó el coautor del estudio Nikolay Babakov de Skoltech. «Nuestro clasificador adivinó correctamente qué expresiones los etiquetadores humanos consideraron inapropiadas en el 89% de los casos».

Ambos modelos para detectar la inadecuación y la sensibilidad, y el equipo de MTS-Skoltech ha puesto a disposición del público los conjuntos de datos con aproximadamente 163.000 oraciones etiquetadas como (in) apropiadas y unas 33.000 oraciones que tratan de temas delicados.

«Estos modelos se pueden mejorar mediante el ensamblaje o el uso de arquitecturas alternativas», agregó Babakov. «Una forma particularmente interesante de aprovechar este trabajo sería extendiendo las nociones de idoneidad a otros idiomas. La sensibilidad del tema está en gran medida informada culturalmente. Cada cultura es especial en lo que respecta a la materia que considera inapropiada, por lo que trabajar con otros idiomas es una situación completamente diferente. Un área más para explorar es la búsqueda de temas sensibles más allá de los 18 con los que trabajamos «.

Nikolay Babakov et al, Detección de mensajes inapropiados sobre temas delicados que podrían dañar la reputación de una empresa. arXiv: 2103.05345 [cs.CL] arxiv.org/abs/2103.05345

Citación: El modelo neuronal busca lo ‘inapropiado’ para reducir la incomodidad del chatbot (2021, 20 de julio) recuperado el 20 de julio de 2021 de https://techxplore.com/news/2021-07-neural-inapropiadoness-chatbot-awkwardness.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.

GIPHY App Key not set. Please check settings