El marco SAGE para explicar el contexto en la IA explicable (Mill et al., 2024). Crédito: Inteligencia artificial aplicada (2024). Doi: 10.1080/08839514.2024.2430867

¿Estamos poniendo nuestra fe en la tecnología que no entendemos completamente? Un nuevo estudio de la Universidad de Surrey llega en un momento en que los sistemas de IA están tomando decisiones que afectan nuestra vida diaria, desde la banca y la atención médica hasta la detección de delitos. El estudio exige un cambio inmediato en cómo se diseñan y evalúan los modelos de IA, enfatizando la necesidad de transparencia y confiabilidad en estos poderosos algoritmos.

La investigación es publicado en el diario Inteligencia artificial aplicada.

A medida que la IA se integra en sectores de alto riesgo donde las decisiones pueden tener consecuencias alteradas, los riesgos asociados con los modelos de «caja negra» son mayores que nunca. La investigación arroja luz sobre los casos en que los sistemas de IA deben proporcionar explicaciones adecuadas para sus decisiones, lo que permite a los usuarios confiar y comprender la IA en lugar de dejarlos confundidos y vulnerables.

Con casos de diagnóstico erróneo en la atención médica y alertas de fraude erróneos en la banca, el potencial de daño, que podría ser potencialmente mortal, es significativo.

Los investigadores de Surrey detallan las instancias alarmantes en las que los sistemas de IA no han explicado adecuadamente sus decisiones, dejando a los usuarios confundidos y vulnerables. Los conjuntos de datos de fraude están inherentemente desequilibrados (0.01% son transacciones fraudulentas, lo que lleva a dañar la escala de miles de millones de dólares.

Es tranquilizador para las personas saber que la mayoría de las transacciones son genuinas, pero el desequilibrio desafía la IA en el aprendizaje de los patrones de fraude. Aún así, los algoritmos de IA pueden identificar una transacción fraudulenta con gran precisión, pero actualmente carecen de la capacidad de explicar adecuadamente por qué es fraudulento.

El Dr. Wolfgang Garn, coautor del estudio y profesor titular de análisis de la Universidad de Surrey, dijo: «No debemos olvidar que detrás de la solución de cada algoritmo, hay personas reales cuyas vidas se ven afectadas por las decisiones determinadas. Nuestro objetivo es crear sistemas de IA que no solo sean inteligentes, sino que también proporcionen explicaciones a las personas, los usuarios de la tecnología, que pueden confiar y entender «.

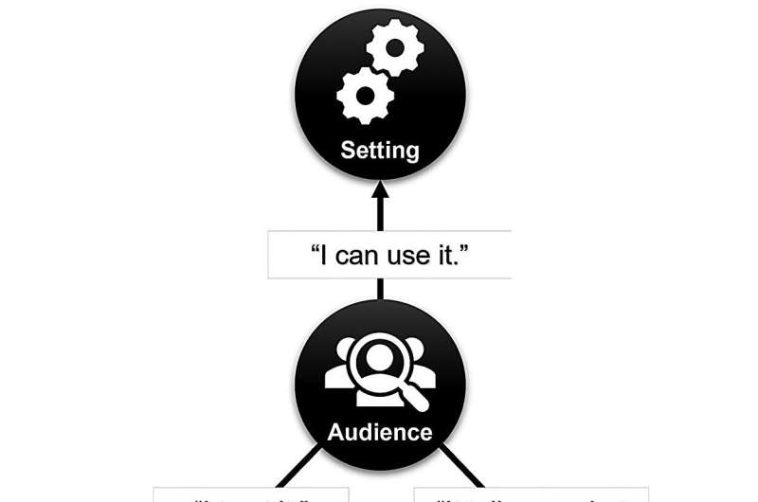

El estudio propone un marco integral conocido como salvia (configuración, audiencia, objetivos y ética) para abordar estos problemas críticos. SAGE está diseñado para garantizar que las explicaciones de IA no solo sean comprensibles sino también contextualmente relevantes para los usuarios finales.

Al centrarse en las necesidades y antecedentes específicos de la audiencia prevista, el marco SAGE tiene como objetivo cerrar la brecha entre los complejos procesos de toma de decisiones de IA y los operadores humanos que dependen de ellos.

Junto con este marco, la investigación utiliza técnicas de diseño basadas en escenarios (SBD), que profundizan en los escenarios del mundo real para averiguar qué los usuarios realmente requieren de las explicaciones de IA. Este método alienta a los investigadores y desarrolladores a entrar en los zapatos de los usuarios finales, asegurando que los sistemas de IA estén diseñados con empatía y comprensión en su núcleo.

El Dr. Garn dijo: «También necesitamos resaltar las deficiencias de los modelos de IA existentes, que a menudo carecen de la conciencia contextual necesaria para proporcionar explicaciones significativas. Al identificar y abordar estas brechas, nuestro documento defiende una evolución en el desarrollo de la IA que prioriza el usuario- Principios de diseño centrados.

«Pide que los desarrolladores de IA se involucren con especialistas de la industria y usuarios finales activamente, fomentando un entorno colaborativo donde las ideas de varias partes interesadas pueden dar forma al futuro de la IA. La tecnología que creamos y el impacto que tiene en nuestras vidas.

La investigación destaca la importancia de los modelos de IA que explican sus resultados en forma de texto o representaciones gráficas, atendiendo a las diversas necesidades de comprensión de los usuarios.

Este cambio tiene como objetivo garantizar que las explicaciones no solo sean accesibles sino también procesables, lo que permite a los usuarios tomar decisiones informadas basadas en ideas de IA.

Más información:

Eleanor Mill et al, eficacia del mundo real de la inteligencia artificial explicable utilizando el marco SAGE y el diseño basado en escenarios, Inteligencia artificial aplicada (2024). Doi: 10.1080/08839514.2024.2430867

Citación: Comprensión de la toma de decisiones de la IA: La investigación examina la transparencia del modelo (2025, 19 de febrero) Consultado el 19 de febrero de 2025 de https://techxplore.com/news/2025-02-ai-decision-transparency.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.

GIPHY App Key not set. Please check settings