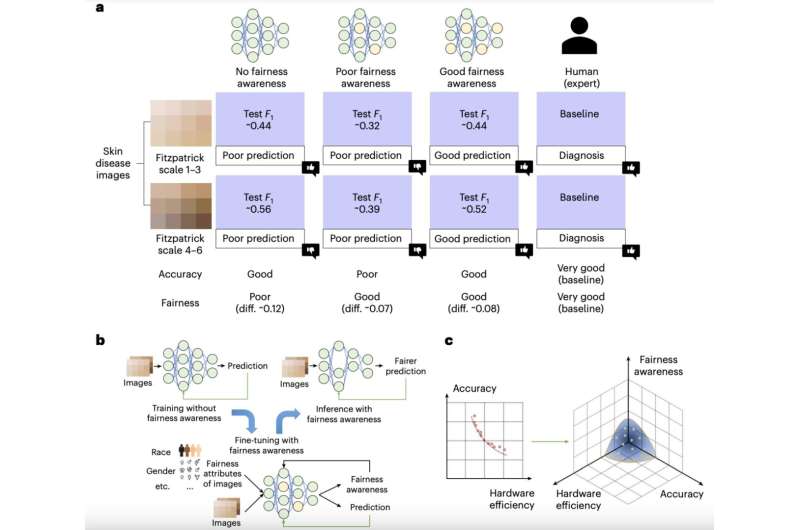

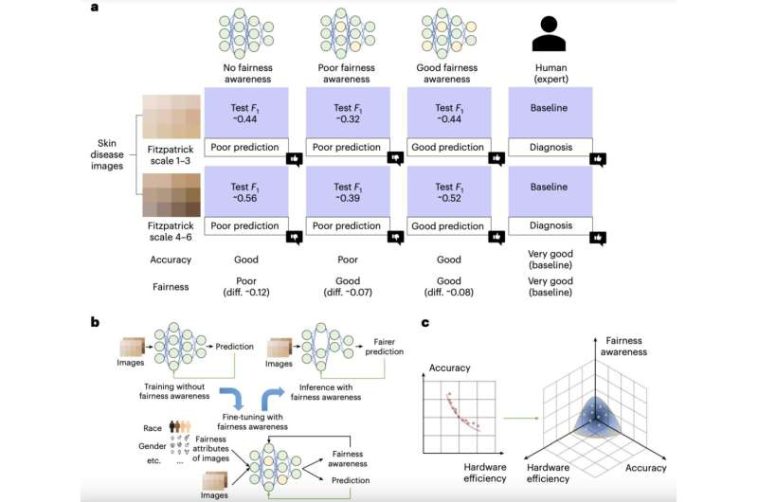

Equidad de las redes neuronales. a. Ejemplo ilustrativo de la conciencia de equidad de las redes neuronales en la detección de enfermedades dermatológicas. b. Proceso de entrenamiento del modelo con conciencia de equidad. c. Nuevo objetivo a tener en cuenta en el diseño del sistema. La conciencia de equidad añade un nuevo objetivo que buscamos, ampliando una nueva dimensión del problema. Crédito: Guo et al.

En las últimas dos décadas, los científicos informáticos han desarrollado una amplia gama de redes neuronales profundas (DNN) diseñadas para abordar diversas tareas del mundo real. Si bien algunos de estos modelos han demostrado ser muy eficaces, algunos estudios han descubierto que pueden ser injustos, lo que significa que su rendimiento puede variar en función de los datos con los que se entrenaron e incluso de las plataformas de hardware en las que se implementaron.

Por ejemplo, algunos estudios demostraron que las herramientas de reconocimiento facial basadas en aprendizaje profundo disponibles comercialmente eran significativamente mejores para reconocer los rasgos de las personas de piel clara en comparación con las de las personas de piel oscura. Estas variaciones observadas en el desempeño de la IA, en gran parte debido a las disparidades en los datos de entrenamiento disponibles, han inspirado esfuerzos destinados a mejorar la imparcialidad de los modelos existentes.

Recientemente, investigadores de la Universidad de Notre Dame se propusieron investigar cómo los sistemas de hardware pueden contribuir a la imparcialidad de la IA. Su artículo, publicado en Electrónica de la naturalezaidentifica formas en las que los diseños de hardware emergentes, como los dispositivos de computación en memoria (CiM), pueden afectar la imparcialidad de las DNN.

«Nuestro artículo surgió de una necesidad urgente de abordar la equidad en la IA, especialmente en áreas de alto riesgo como la atención médica, donde los sesgos pueden provocar daños significativos», dijo Yiyu Shi, coautor del artículo, a Tech Xplore.

«Si bien gran parte de la investigación se ha centrado en la imparcialidad de los algoritmos, el papel del hardware a la hora de influir en la imparcialidad se ha ignorado en gran medida. A medida que los modelos de IA se implementan cada vez más en dispositivos con recursos limitados, como los dispositivos móviles y los dispositivos periféricos, nos dimos cuenta de que el hardware subyacente podría exacerbar o mitigar los sesgos».

Después de revisar la literatura anterior que explora las discrepancias en el rendimiento de la IA, Shi y sus colegas se dieron cuenta de que aún no se había investigado la contribución del diseño del hardware a la imparcialidad de la IA. El objetivo clave de su reciente estudio fue llenar este vacío, examinando específicamente cómo los nuevos diseños de hardware de CiM afectaban la imparcialidad de las DNN.

«Nuestro objetivo era explorar sistemáticamente estos efectos, en particular a través de la lente de las arquitecturas CiM emergentes, y proponer soluciones que pudieran ayudar a garantizar implementaciones justas de IA en diversas plataformas de hardware», explicó Shi. «Investigamos la relación entre el hardware y la equidad mediante la realización de una serie de experimentos utilizando diferentes configuraciones de hardware, centrándonos especialmente en las arquitecturas CiM».

Como parte de este estudio reciente, Shi y sus colegas llevaron a cabo dos tipos principales de experimentos. El primer tipo tenía como objetivo explorar el impacto de los diseños de arquitectura neuronal con reconocimiento de hardware que varían en tamaño y estructura en la imparcialidad de los resultados obtenidos.

«Nuestros experimentos nos llevaron a varias conclusiones que no se limitaban a la selección de dispositivos», dijo Shi. «Por ejemplo, descubrimos que las redes neuronales más grandes y complejas, que normalmente requieren más recursos de hardware, tienden a mostrar una mayor equidad. Sin embargo, estos mejores modelos también eran más difíciles de implementar en dispositivos con recursos limitados».

Basándose en lo observado en sus experimentos, los investigadores propusieron posibles estrategias que podrían ayudar a aumentar la imparcialidad de la IA sin plantear desafíos computacionales significativos. Una posible solución podría ser comprimir modelos más grandes, conservando así su rendimiento y limitando su carga computacional.

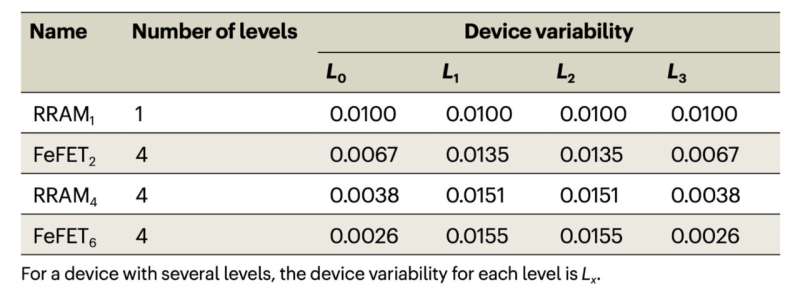

Modelado de dispositivos no ideales para diferentes dispositivos reales y sintetizados. Crédito: Guo et al.

«El segundo tipo de experimentos que llevamos a cabo se centró en ciertas no idealidades, como la variabilidad de los dispositivos y los problemas de bloqueo en caso de fallo que se dan en las arquitecturas CiM», dijo Shi. «Utilizamos estas plataformas de hardware para ejecutar varias redes neuronales y examinamos cómo los cambios en el hardware (como las diferencias en la capacidad de memoria o la potencia de procesamiento) afectaban la imparcialidad del modelo.

«Los resultados mostraron que se presentaron diversas compensaciones bajo diferentes configuraciones de variaciones del dispositivo y que los métodos existentes utilizados para mejorar la robustez bajo variaciones del dispositivo también contribuyeron a estas compensaciones».

Para superar los desafíos que se revelaron en su segundo conjunto de experimentos, Shi y sus colegas sugieren emplear estrategias de entrenamiento que tengan en cuenta el ruido. Estas estrategias implican la introducción de ruido controlado durante el entrenamiento de los modelos de IA, como un medio para mejorar tanto su solidez como su imparcialidad sin aumentar significativamente sus demandas computacionales.

«Nuestra investigación destaca que la imparcialidad de las redes neuronales no es sólo una función de los datos o algoritmos, sino que también está significativamente influenciada por el hardware en el que se implementan», dijo Shi. «Uno de los hallazgos clave es que los modelos más grandes y que consumen más recursos generalmente funcionan mejor en términos de imparcialidad, pero esto se produce a costa de requerir un hardware más avanzado».

A través de sus experimentos, los investigadores también descubrieron que las no idealidades inducidas por el hardware, como la variabilidad del dispositivo, pueden generar disyuntivas entre la precisión y la imparcialidad de los modelos de IA. Sus hallazgos resaltan la necesidad de considerar cuidadosamente tanto el diseño de las estructuras de los modelos de IA como las plataformas de hardware en las que se implementarán, para alcanzar un buen equilibrio entre precisión y equidad.

«En la práctica, nuestro trabajo sugiere que al desarrollar IA, particularmente herramientas para aplicaciones sensibles (por ejemplo, diagnósticos médicos), los diseñadores deben considerar no solo los algoritmos de software sino también las plataformas de hardware», dijo Shi.

El trabajo reciente de este equipo de investigación podría contribuir a futuros esfuerzos encaminados a aumentar la equidad de la IA, alentando a los desarrolladores a centrarse tanto en los componentes de hardware como de software. Esto, a su vez, podría facilitar el desarrollo de sistemas de IA que sean precisos y equitativos, y que produzcan resultados igualmente buenos al analizar los datos de usuarios con diferentes características físicas y étnicas.

«En el futuro, nuestra investigación seguirá profundizando en la intersección del diseño de hardware y la equidad de la IA», afirmó Shi. «Planeamos desarrollar marcos avanzados de diseño conjunto entre capas que optimicen las arquitecturas de redes neuronales para lograr la equidad, teniendo en cuenta las limitaciones del hardware. Este enfoque implicará explorar nuevos tipos de plataformas de hardware que respalden inherentemente la equidad junto con la eficiencia».

Como parte de sus próximos estudios, los investigadores también planean diseñar técnicas de entrenamiento adaptativo que puedan abordar la variabilidad y las limitaciones de los diferentes sistemas de hardware. Estas técnicas podrían garantizar que los modelos de IA sigan siendo justos independientemente de los dispositivos en los que se ejecuten y las situaciones en las que se implementen.

«Otra línea de interés para nosotros es investigar cómo se pueden ajustar configuraciones de hardware específicas para mejorar la equidad, lo que podría conducir al diseño de nuevas clases de dispositivos con la equidad como objetivo principal», agregó Shi. «Estos esfuerzos son cruciales a medida que los sistemas de IA se vuelven más omnipresentes y la necesidad de una toma de decisiones justa e imparcial se vuelve cada vez más crítica».

Más información:

Yuanbo Guo et al, Diseño de hardware y equidad de una red neuronal, Electrónica de la naturaleza (2024). DOI: 10.1038/s41928-024-01213-0

© 2024 Red Science X

Citación:Cómo contribuye el hardware a la equidad de las redes neuronales artificiales (24 de agosto de 2024) recuperado el 24 de agosto de 2024 de https://techxplore.com/news/2024-08-hardware-contributes-fairness-artificial-neural.html

Este documento está sujeto a derechos de autor. Salvo que se haga un uso legítimo con fines de estudio o investigación privados, no se podrá reproducir ninguna parte del mismo sin autorización por escrito. El contenido se ofrece únicamente con fines informativos.

GIPHY App Key not set. Please check settings