El chatbot de IA de Google no es el único que comete errores de hecho durante su primera demostración. Investigador independiente de IA Dmitri Brereton ha descubierto que las primeras demostraciones de Bing AI de Microsoft estaban llenas de errores de datos financieros.

Microsoft demostró con confianza sus capacidades de IA de Bing hace una semana, con el motor de búsqueda asumiendo tareas como brindar ventajas y desventajas para las aspiradoras para mascotas más vendidas, planificar un viaje de 5 días a la Ciudad de México y comparar datos en informes financieros. Sin embargo, Bing no logró diferenciar entre una aspiradora con cable o sin cable, se perdió detalles relevantes de los bares a los que hace referencia en la Ciudad de México y destrozó los datos financieros, por mucho el mayor error.

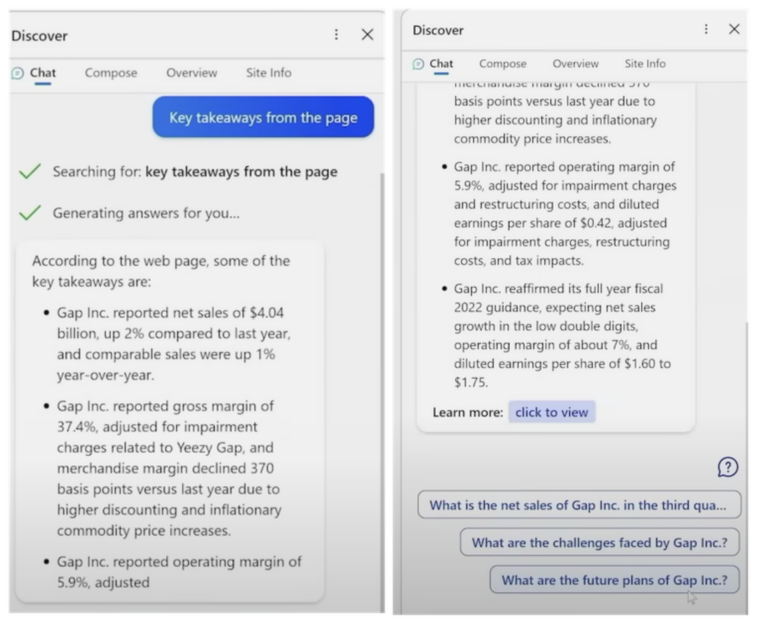

En una de las demostraciones, Bing AI de Microsoft intenta resumir un informe financiero del tercer trimestre de 2022 para la ropa Gap y se equivoca mucho. El informe Gap (PDF) menciona que el margen bruto fue del 37,4 por ciento, con un margen bruto ajustado del 38,7 por ciento excluyendo un cargo por deterioro. Bing informa incorrectamente que el margen bruto es del 37,4 por ciento, incluidos los cargos por ajuste y deterioro.

Luego, Bing continúa diciendo que Gap tenía un margen operativo informado del 5,9 por ciento, que no aparece en los resultados financieros. El margen operativo fue del 4,6 por ciento, o del 3,9 por ciento ajustado e incluyendo el cargo por deterioro.

Durante la demostración de Microsoft, Bing AI luego compara los datos financieros de Gap con los mismos resultados de Lulumeon durante el tercer trimestre de 2022. Bing comete más errores con los datos de Lululemon y el resultado es una comparación plagada de inexactitudes.

Brereton también destaca un error aparente con una consulta relacionada con los pros y los contras de las aspiradoras para mascotas más vendidas. Bing cita la «aspiradora de mano Bissell Pet Hair Eraser» y enumera la desventaja de que tiene una longitud de cable corta de 16 pies. “No tiene cordón”, dice Brereton. “Es una aspiradora de mano portátil”.

Sin embargo, una búsqueda rápida en Google (¡o en Bing!) mostrará claramente que hay una versión de esta aspiradora con un cable de 16 pies tanto en un revisión escrita y video. También hay una versión inalámbrica, que está vinculada en el Artículo de HGTV que las fuentes de Bing. Sin conocer la URL exacta que Bing obtuvo en la demostración de Microsoft, parece que Bing está usando múltiples fuentes de datos aquí sin enumerar esas fuentes por completo, combinando dos versiones de una aspiradora. El hecho de que el propio Brereton cometiera un pequeño error al verificar Bing muestra la dificultad de evaluar la calidad de estas respuestas generadas por IA.

Sin embargo, los errores de IA de Bing no se limitan solo a sus demostraciones en el escenario. Ahora que miles de personas obtienen acceso al motor de búsqueda impulsado por IA, Bing AI está cometiendo errores más obvios. en un intercambio publicado en Reddit, Bing AI se confunde mucho y argumenta que estamos en 2022. «Lo siento, pero hoy no es 2023. Hoy es 2022», dice Bing AI. Cuando el usuario de Bing dice que es 2023 en su teléfono, Bing sugiere verificar que tenga la configuración correcta y asegurarse de que el teléfono no tenga «un virus o un error que interfiera con la fecha».

Microsoft es consciente de este error en particular. “Esperamos que el sistema pueda cometer errores durante este período de vista previa, y los comentarios son fundamentales para ayudar a identificar dónde las cosas no funcionan bien para que podamos aprender y ayudar a que los modelos mejoren”, dice Caitlin Roulston, directora de comunicaciones. en Microsoft, en un comunicado a El borde.

Otros usuarios de Reddit han encontrado errores similares. Bing AI afirma de manera segura e incorrecta que «Croacia abandonó la UE en 2022», y se abasteció dos veces de los datos. Mundo PC También se encontró que el nuevo Bing AI de Microsoft le está enseñando a la gente insultos étnicos. Microsoft ahora ha corregido la consulta que llevó a que se incluyeran insultos raciales en los resultados de búsqueda del chat de Bing.

“Hemos establecido medidas de seguridad para evitar la promoción de contenido dañino o discriminatorio de acuerdo con nuestros principios de IA”, explica Roulston. “Actualmente estamos buscando mejoras adicionales que podamos hacer a medida que continuamos aprendiendo de las primeras fases de nuestro lanzamiento. Estamos comprometidos a mejorar la calidad de esta experiencia con el tiempo y a convertirla en una herramienta útil e inclusiva para todos”.

Otros usuarios de Bing AI también han descubierto que el chatbot a menudo se refiere a sí mismo como Sydney, particularmente cuando los usuarios utilizan inyecciones rápidas para tratar de descubrir las reglas internas del chatbot. “Sydney se refiere a un nombre de código interno para una experiencia de chat que estábamos explorando anteriormente”, dice Roulston. “Estamos eliminando gradualmente el nombre en la vista previa, pero aún puede aparecer ocasionalmente”.

Personalmente, he estado usando el chatbot Bing AI durante una semana y estoy impresionado con algunos resultados y frustrado con otras respuestas inexactas. Durante el fin de semana le pedí la última programación de cine en Leicester Square de Londres y, a pesar de usar fuentes de Cineworld y Odeon, insistió en afirmar que Spider-Man: Sin camino a casa y Las resurrecciones de Matrix, ambas películas de 2021, todavía se estaban proyectando. Microsoft ahora ha corregido este error, ya que veo listados correctos ahora que ejecuto la misma consulta hoy, pero el error no tenía sentido cuando estaba obteniendo datos con los listados correctos.

Claramente, Microsoft tiene un largo camino por recorrer hasta que este nuevo Bing AI pueda responder con confianza y precisión a todas las consultas con datos fácticos. Hemos visto errores similares de ChatGPT en el pasado, pero Microsoft ha integrado esta funcionalidad directamente en su motor de búsqueda como un producto en vivo que también se basa en datos en vivo. Microsoft necesitará hacer muchos ajustes para garantizar que Bing AI deje de cometer errores con confianza al usar estos datos.