Los nuevos paradigmas informáticos nunca dejarán de ser extraños, pero esa incomodidad se intensifica dramáticamente cuando el cuerpo humano entra en escena. Hay un sentido en el que la lente de contacto inteligente se siente como algo inevitable (ya sea que sea producido por Mojo Vision o por alguien más es otra cuestión), pero eso no significa que cada nueva aplicación no se sienta un poco extraña.

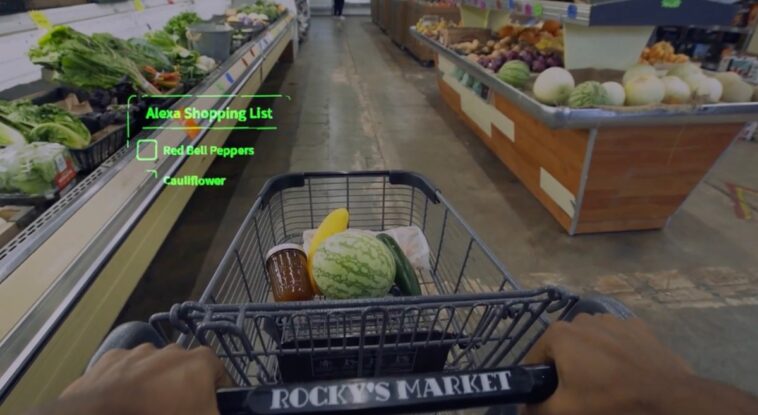

Mojo anunció hoy «la primera aplicación de consumo de terceros importante en una lente de contacto inteligente», con la introducción de la integración de Alexa Shopping List. Esto sigue siendo en gran medida una prueba, una prueba de concepto, en realidad, diseñada para demostrar cómo se vería algo así como una lista de compras en una interfaz informática basada en lentes de contacto.

La implementación utiliza la computación de voz de Alexa para agregar o eliminar elementos de la lista, que aparecen en la interfaz de HUD mientras se compra. El usuario puede navegar más a través de la lista con los ojos y marcar los artículos cuando están en el carrito. Si un miembro de la familia agrega un elemento a la lista de forma remota, aparecerá en la interfaz de Mojo.

Al menos, la función de prueba demuestra cómo se pueden usar interfaces adicionales como la computación de voz para aumentar las limitaciones de esta computación basada en el globo ocular. Intentar ingresar nuevos elementos usando el ojo suena como una pesadilla, pero esa interfaz ciertamente tiene sentido para tareas más simples, como desplazarse.

El equipo de Amazon ayudó a Mojo a implementar Alexa Shpping para la función de prueba.

“En Amazon, creemos que las experiencias se pueden mejorar con la tecnología que siempre está ahí cuando la necesitas, pero nunca tienes que pensar en ella”, dijo el gerente general de Alexa Shopping List, Ramya Reguramalingam, en un comunicado. “Estamos entusiasmados de que Invisible Computing for Mojo Lens de Mojo Vision, junto con la demostración de Alexa Shopping List como caso de uso, muestre el arte de lo que es posible para las experiencias de compra inteligentes, discretas y con manos libres”.

Mojo Vision todavía es razonablemente cauteloso sobre si dicha funcionalidad realmente está llegando o no. La compañía señala en el comunicado: «La integración de prueba muestra cómo Mojo Vision podría integrar la IA de voz de Alexa con la interfaz única y poderosa basada en el ojo de Mojo Lens».

Una demostración de la tecnología debutó en el escenario hoy en un evento del Wall Street Journal en el sur de California.

Amazon: Próximamente en tus ojos por Brian Heater publicado originalmente en TechCrunch