|

|

Hoy anunciamos la disponibilidad general de las instancias P6-B300 de Amazon Elastic Compute Cloud (Amazon EC2), nuestra plataforma GPU de próxima generación acelerada por las GPU NVIDIA Blackwell Ultra. Estas instancias ofrecen 2 veces más ancho de banda de red y 1,5 veces más memoria GPU en comparación con las instancias de la generación anterior, lo que crea una plataforma equilibrada para aplicaciones de IA a gran escala.

Con estas mejoras, las instancias P6-B300 son ideales para entrenar y servir modelos de IA a gran escala, particularmente aquellos que emplean técnicas sofisticadas como la Mezcla de Expertos (MoE) y el procesamiento multimodal. Para las organizaciones que trabajan con modelos de billones de parámetros y requieren capacitación distribuida en miles de GPU, estas instancias brindan el equilibrio perfecto entre capacidades de computación, memoria y redes.

Mejoras realizadas en comparación con sus predecesores

Las instancias P6-B300 ofrecen un ancho de banda de red con adaptador de tejido elástico (EFA) de 6,4 Tbps, lo que admite una comunicación eficiente entre grandes clústeres de GPU. Estas instancias cuentan con 2,1 TB de memoria GPU, lo que permite que modelos grandes residan dentro de un único dominio NVIDIA NVLink, lo que reduce significativamente la fragmentación de modelos y la sobrecarga de comunicación. Cuando se combinan con las redes EFA y las capacidades avanzadas de virtualización y seguridad de AWS Nitro System, estas instancias brindan velocidad, escala y seguridad sin precedentes para las cargas de trabajo de IA.

Las especificaciones para las instancias EC2 P6-B300 son las siguientes.

| Tamaño de instancia | VCPU | Memoria del sistema | GPU | Memoria GPU | Interconexión GPU-GPU | Ancho de banda de la red EFA | ancho de banda ENA | ancho de banda EBS | Almacenamiento local |

| P6-B300.48xgrande | 192 | 4TB | 8 GPU NVIDIA B300 | 2144GB HBM3e | 1800 GB/s | 6,4 Tbits por segundo | 300 Gbps | 100 Gbps | 8x 3,84TB |

Es bueno saberlo

En términos de almacenamiento persistente, las cargas de trabajo de IA utilizan principalmente una combinación de opciones de almacenamiento persistente de alto rendimiento, como Amazon FSx for Lustre, Amazon S3 Express One Zone y Amazon Elastic Block Store (Amazon EBS), según las consideraciones de precio y rendimiento. A modo de ejemplo, la red del adaptador de red elástica (ENA) dedicada de 300 Gbps en el P6-B300 permite el acceso al almacenamiento activo de alto rendimiento con S3 Express One Zone, lo que admite cargas de trabajo de capacitación a gran escala. Si está utilizando FSx para Lustre, ahora puede usar EFA con NVIDIA GPUDirect Storage (GDS) para lograr hasta 1,2 Tbps de rendimiento en el sistema de archivos Lustre en las instancias P6-B300 para cargar rápidamente sus modelos.

Disponible ahora

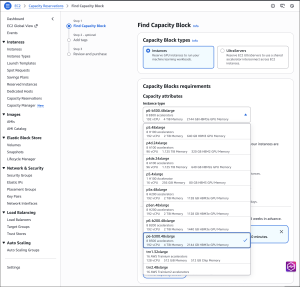

Las instancias P6-B300 ahora están disponibles a través de los bloques de capacidad de Amazon EC2 para ML y Savings Plan en la región de AWS Oeste de EE. UU. (Oregón).

Para reservas bajo demanda de instancias P6-B300, comuníquese con su administrador de cuentas. Como es habitual con Amazon EC2, pagas sólo por lo que usas. Para obtener más información, consulte Precios de Amazon EC2. Consulte la colección completa de instancias informáticas aceleradas para ayudarle a comenzar a migrar sus aplicaciones.

Para obtener más información, visite nuestra página de instancias Amazon EC2 P6-B300. Enviar comentarios a AWS re: Publicación para EC2 o a través de sus contactos habituales de AWS Support.

– Veliswa