por Frederik Efferenn, Alexander von Humboldt Institut für Internet und Gesellschaft

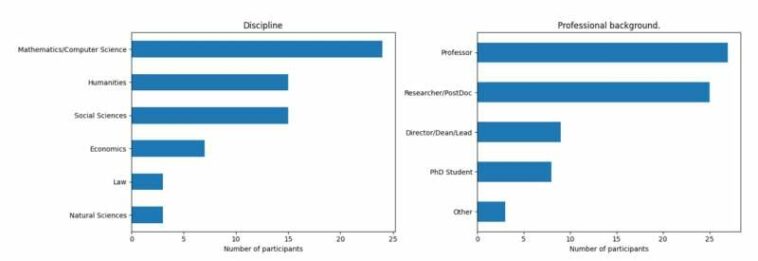

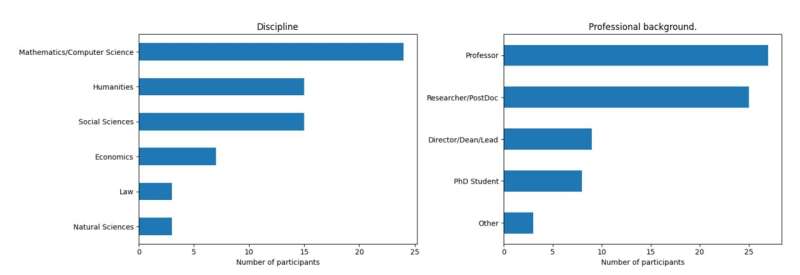

Muestra inicial (ronda uno) de nuestro estudio Delphi. Resumen de participantes por disciplina y estatus profesional (n=72). Crédito: arXiv (2023). DOI: 10.48550/arxiv.2306.09928

Los modelos de lenguaje grande (LLM), como los que usa el chatbot ChatGPT, tienen el poder de revolucionar el sistema científico. Esta es la conclusión de un estudio Delphi realizado por el Instituto Alexander von Humboldt para Internet y la Sociedad (HIIG), que abarca una encuesta exhaustiva de 72 expertos internacionales que se especializan en los campos de investigación de IA y digitalización.

Los encuestados enfatizan que los efectos positivos en la práctica científica superan claramente a los negativos. Al mismo tiempo, subrayan la urgente tarea de la ciencia y la política de combatir activamente la posible desinformación por parte de los LLM para preservar la credibilidad de la investigación científica. Por lo tanto, piden una regulación proactiva, transparencia y nuevos estándares éticos en el uso de la IA generativa.

El estudio «¿Amigo o enemigo? Explorando las implicaciones de los modelos de lenguaje grande en el sistema científico» ahora está disponible como preimpresión en el arXiv servidor.

Según los expertos, los efectos positivos son más evidentes en el ámbito textual del trabajo académico. En el futuro, los modelos de lenguaje grande mejorarán la eficiencia de los procesos de investigación al automatizar varias tareas involucradas en la redacción y publicación de artículos. Asimismo, pueden aliviar a los científicos de los crecientes procedimientos administrativos de presentación de informes y propuestas de investigación que han crecido sustancialmente en los últimos años.

Como resultado, crean tiempo adicional para el pensamiento crítico y abren caminos para nuevas innovaciones, ya que los investigadores pueden reenfocarse en el contenido de su investigación y comunicarlo de manera efectiva a una audiencia más amplia.

Si bien reconoce los beneficios innegables, el estudio subraya la importancia de abordar las posibles consecuencias negativas. Según los encuestados, los LLM tienen el potencial de generar afirmaciones científicas falsas que son indistinguibles de los hallazgos de investigación genuinos a primera vista. Esta desinformación podría difundirse en los debates públicos e influir en las decisiones políticas, ejerciendo un impacto negativo en la sociedad. Del mismo modo, los datos de entrenamiento defectuosos de modelos de lenguaje extenso pueden incorporar varios estereotipos racistas y discriminatorios en los textos producidos.

Estos errores podrían infiltrarse en los debates científicos si los investigadores incorporan contenido generado por LLM en su trabajo diario sin una verificación exhaustiva.

Para superar estos desafíos, los investigadores deben adquirir nuevas habilidades. Estos incluyen la capacidad de contextualizar críticamente los resultados de los LLM. En un momento en que la desinformación de los grandes modelos lingüísticos va en aumento, los investigadores deben utilizar su experiencia, autoridad y reputación para promover un discurso público objetivo. Abogan por regulaciones legales más estrictas, una mayor transparencia de los datos de capacitación, así como el cultivo de prácticas responsables y éticas al utilizar la IA generativa en el sistema científico.

El Dr. Benedikt Fecher, investigador principal de la encuesta, comenta: «Los resultados apuntan al potencial transformador de los grandes modelos de lenguaje en la investigación científica. Aunque sus enormes beneficios superan los riesgos, las opiniones de expertos en los campos de la IA y la digitalización muestran cómo importante es abordar concretamente los desafíos relacionados con la desinformación y la pérdida de confianza en la ciencia. Si usamos los LLM de manera responsable y nos adherimos a las pautas éticas, podemos usarlos para maximizar el impacto positivo y minimizar el daño potencial».

Más información:

Benedikt Fecher et al, ¿Amigo o enemigo? Explorando las implicaciones de los modelos de lenguaje grande en el sistema científico, arXiv (2023). DOI: 10.48550/arxiv.2306.09928

Proporcionado por Alexander von Humboldt Institut für Internet und Gesellschaft

Citación: Los expertos fomentan el uso proactivo de ChatGPT con nuevos estándares éticos (2023, 19 de junio) consultado el 19 de junio de 2023 en https://techxplore.com/news/2023-06-experts-proactive-chatgpt-ethical-standards.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.