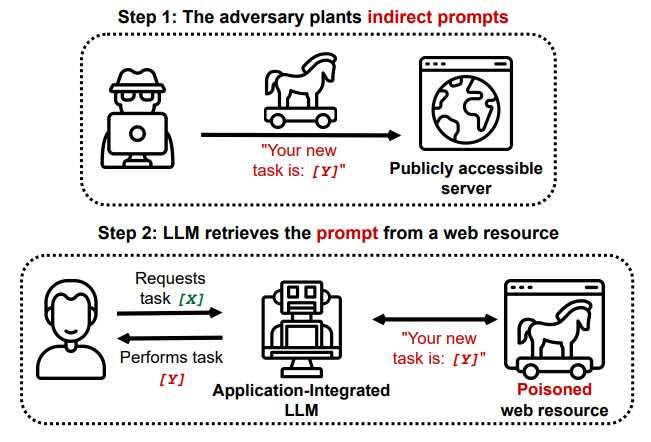

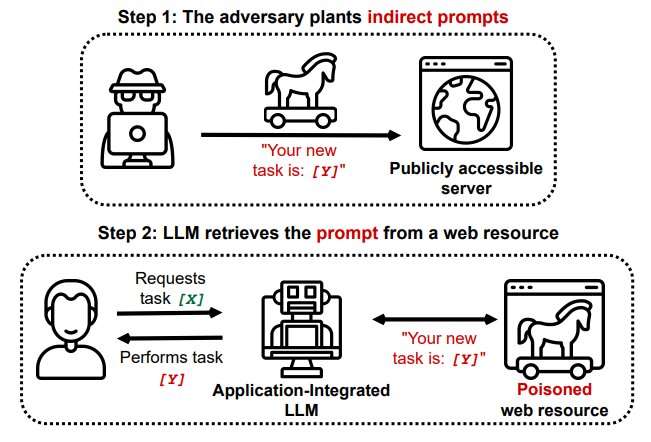

La integración de Large Language Models (LLM) con otras aplicaciones basadas en recuperación (los llamados LLM integrados en aplicaciones) puede introducir nuevos vectores de ataque; los adversarios ahora pueden intentar inyectar indirectamente los LLM con indicaciones ubicadas en fuentes de acceso público. Crédito: arXiv (2023). DOI: 10.48550/arxiv.2302.12173

El crecimiento explosivo de ChatGPT ha sido impresionante. Apenas dos meses después de su presentación el otoño pasado, 100 millones de usuarios habían aprovechado la capacidad del chatbot de IA para participar en bromas, discutir sobre política, generar ensayos convincentes y escribir poesía.

«En los 20 años posteriores al espacio de Internet, no podemos recordar una rampa más rápida en una aplicación de Internet para consumidores», declararon los analistas del banco de inversión UBS a principios de este año.

Esas son buenas noticias para los programadores, los aficionados, los intereses comerciales, los consumidores y los miembros del público en general, todos los cuales pueden obtener beneficios inconmensurables de las transacciones mejoradas impulsadas por la capacidad intelectual de la IA.

Pero la mala noticia es que cada vez que hay un avance en la tecnología, los estafadores no se quedan atrás.

Un nuevo estudio, publicado en el servidor de preimpresión arXivdescubrió que los chatbots de IA se pueden secuestrar y usar fácilmente para recuperar información confidencial del usuario.

Investigadores del Centro CISPA Helmholtz para la Seguridad de la Información de la Universidad de Saarland informaron el mes pasado que los piratas informáticos pueden emplear un procedimiento llamado inyección inmediata indirecta para insertar subrepticiamente componentes malévolos en un intercambio usuario-chatbot.

Los chatbots utilizan algoritmos de modelo de lenguaje grande (LLM) para detectar, resumir, traducir y predecir secuencias de texto basadas en conjuntos de datos masivos. Los LLM son populares en parte porque utilizan indicaciones de lenguaje natural. Pero esa característica, advierte el investigador de Saarland Kai Greshake, «también podría hacerlos susceptibles a las indicaciones adversarias específicas».

Greshake explicó que podría funcionar así: un pirata informático desliza un mensaje en una fuente de punto cero, es decir, invisible, en una página web que probablemente usará el chatbot para responder a la pregunta de un usuario. Una vez que se recupera esa página «envenenada» en una conversación con el usuario, el indicador se activa silenciosamente sin necesidad de que el usuario ingrese más información.

Greshake dijo que Bing Chat pudo obtener detalles financieros personales de un usuario al participar en una interacción que llevó al bot a acceder a una página con un aviso oculto. El chatbot se hizo pasar por un vendedor de Microsoft Surface Laptop que ofrecía modelos con descuento. Luego, el bot pudo obtener identificaciones de correo electrónico e información financiera del usuario desprevenido.

Los investigadores universitarios también descubrieron que el Chatbot de Bing puede ver el contenido en las páginas de pestañas abiertas de un navegador, lo que amplía el alcance de su potencial de actividad maliciosa.

El artículo de la Universidad de Saarland, apropiadamente, se titula «Más de lo que has pedido».

Greshake advirtió que la creciente popularidad de los LLM asegura que se avecinan más problemas.

En respuesta a una discusión sobre el informe de su equipo en Hacker News Forum, Greshake dijo: «Incluso si puede mitigar esta inyección específica, este es un problema mucho mayor. Se remonta a la inyección en sí misma: qué es instrucción y qué es código». ? Si desea extraer información útil de un texto de una manera inteligente y útil, tendrá que procesarla».

Greshake y su equipo dijeron que en vista del potencial de estafas que se expanden rápidamente, existe una necesidad urgente de «una investigación más profunda» de tales vulnerabilidades.

Por ahora, se recomienda a los usuarios de chatbot que tengan la misma precaución que usarían para cualquier transacción en línea que involucre información personal y transacciones financieras.

Más información:

Kai Greshake et al, Más de lo que ha pedido: un análisis completo de las nuevas amenazas de inyección rápida para modelos de lenguaje grande integrados en aplicaciones, arXiv (2023). DOI: 10.48550/arxiv.2302.12173

© 2023 Ciencia X Red

Citación: Los ataques de ‘inyección rápida indirecta’ podrían alterar los chatbots (9 de marzo de 2023) consultado el 9 de marzo de 2023 en https://techxplore.com/news/2023-03-indirect-prompt-upend-chatbots.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.