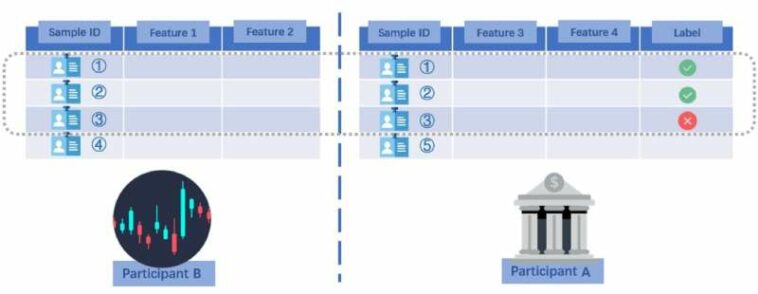

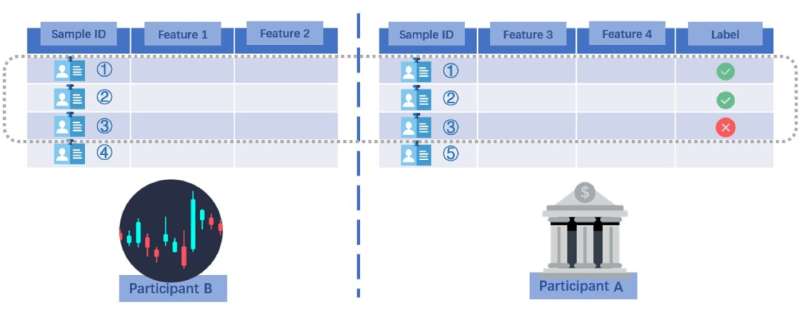

Una ilustración de ejemplo de VFL. La parte B es una empresa financiera que posee las características 1 y 2, y la parte A es un banco que posee las características 3 y 4. Colaboran para entrenar un modelo que predice si se debe aprobar una solicitud de préstamo. Crédito: Morteza Varasteh.

A medida que el uso de algoritmos de aprendizaje automático (ML) continúa creciendo, los informáticos de todo el mundo intentan constantemente identificar y abordar formas en las que estos algoritmos podrían usarse de forma maliciosa o inapropiada. De hecho, debido a sus capacidades avanzadas de análisis de datos, los enfoques de ML tienen el potencial de permitir que terceros accedan a datos privados o lleven a cabo ataques cibernéticos de manera rápida y efectiva.

Morteza Varasteh, investigadora de la Universidad de Essex en el Reino Unido, identificó recientemente un nuevo tipo de ataque de inferencia que podría comprometer los datos confidenciales de los usuarios y compartirlos con otras partes. Este ataque, que se detalla en un artículo publicado previamente en arXivexplota el aprendizaje federado vertical (VFL), un escenario de ML distribuido en el que dos partes diferentes poseen información diferente sobre las mismas personas (clientes).

«Este trabajo se basa en mi colaboración anterior con un colega en Nokia Bell Labs, donde introdujimos un enfoque para extraer información privada del usuario en un centro de datos, conocido como la parte pasiva (por ejemplo, una compañía de seguros)», dijo Varasteh a Tech. Explorar «La parte pasiva colabora con otro centro de datos, denominado parte activa (p. ej., un banco), para construir un algoritmo de ML (p. ej., un algoritmo de aprobación de crédito para el banco)».

El objetivo clave del estudio reciente de Varasteh fue mostrar que después de desarrollar un modelo ML en un entorno de aprendizaje federado vertical (VFL), una llamada «parte activa» podría potencialmente extraer información confidencial de los usuarios, que solo se comparte con el otra parte involucrada en la construcción del modelo ML. La parte activa podría hacerlo utilizando sus propios datos disponibles en combinación con otra información sobre el modelo de ML.

Es importante destacar que esto podría hacerse sin realizar una consulta sobre un usuario de la otra parte. Esto significa que, por ejemplo, si un banco y una compañía de seguros desarrollan en colaboración un algoritmo de ML, el banco podría usar el modelo para obtener información sobre sus propios clientes que también son clientes de la compañía de seguros, sin obtener su permiso.

«Considere un escenario en el que un banco y una compañía de seguros tienen muchos clientes en común, con clientes que comparten alguna información con el banco y otra con la compañía de seguros», explicó Varasteh. «Para construir un modelo de aprobación de crédito más poderoso, el banco colabora con la compañía de seguros en la creación de un algoritmo de aprendizaje automático (ML). El modelo está construido y el banco lo usa para procesar solicitudes de préstamos, incluida una de un cliente llamado Alex , quien también es cliente de la compañía de seguros”.

En el escenario esbozado por Varasteh, el banco podría estar interesado en averiguar qué información compartió Alex (el usuario hipotético que comparten con una compañía de seguros) con la compañía de seguros. Esta información es privada, por supuesto, por lo que la compañía de seguros no puede compartirla libremente con el banco.

«Para superar esto, el banco podría crear otro modelo de ML basado en sus propios datos para imitar el modelo de ML construido en colaboración con la compañía de seguros», dijo Varasteh. «El modelo ML autónomo produce estimaciones de la situación general de Alex en la compañía de seguros, teniendo en cuenta los datos compartidos por Alex con el banco. Una vez que el banco tiene esta idea aproximada de la situación de Alex, y también utilizando los parámetros del modelo VFL, puede usar un conjunto de ecuaciones para resolver la información privada de Alex compartida solo con la compañía de seguros».

El ataque de inferencia descrito por Varasteh en su artículo es relevante para todos los escenarios en los que dos partes (p. ej., bancos, empresas, organizaciones, etc.) comparten algunos usuarios comunes y tienen datos confidenciales de estos usuarios. Ejecutar este tipo de ataques requeriría que una parte «activa» contratara desarrolladores para crear modelos de ML autónomos, una tarea que ahora se está volviendo más fácil de lograr.

«Demostramos que un banco (es decir, una parte activa) puede usar sus datos disponibles para estimar el resultado del modelo VFL que se construyó en colaboración con una compañía de seguros», dijo Varasteh.

«Una vez que se obtiene esta estimación, es posible resolver un conjunto de ecuaciones matemáticas utilizando los parámetros del modelo VFL para obtener la información privada del usuario hipotético Alex. Vale la pena señalar que la información privada de Alex no debe ser conocida por nadie. Aunque Además, se han introducido algunas contramedidas en el documento para prevenir este tipo de ataque, el ataque en sí sigue siendo una parte notable de los resultados de la investigación».

El trabajo de Varasteh arroja nueva luz sobre los posibles usos maliciosos de los modelos ML para acceder ilícitamente a la información personal de los usuarios. En particular, el escenario de ataque y violación de datos que identificó no se había explorado en la literatura anterior.

En su artículo, el investigador de la Universidad de Essex propone esquemas de preservación de la privacidad (PPS) que podrían proteger a los usuarios de este tipo de ataques de inferencia. Estos esquemas están diseñados para distorsionar los parámetros de un modelo VFL que corresponden a las características de los datos en poder de una parte pasiva, como la compañía de seguros en el escenario descrito por Varasteh. Al distorsionar estos parámetros en diversos grados, las partes pasivas que ayudan en colaboración a una parte activa a construir un modelo de ML pueden reducir el riesgo de que la parte activa acceda a los datos confidenciales de sus clientes.

Este trabajo reciente puede inspirar a otros investigadores a evaluar los riesgos del ataque de inferencia recientemente descubierto e identificar ataques similares en el futuro. Mientras tanto, Varasteh tiene la intención de examinar más a fondo las estructuras de VFL, buscando posibles lagunas de privacidad y desarrollando algoritmos que puedan cerrarlas con un daño mínimo para todas las partes involucradas.

«El objetivo principal de VFL es permitir la construcción de modelos ML potentes y al mismo tiempo garantizar que se preserve la privacidad del usuario», agregó Varasteh. «Sin embargo, existe una sutil dicotomía en VPL entre la parte pasiva, que es responsable de mantener segura la información del usuario, y la parte activa, cuyo objetivo es obtener una mejor comprensión del modelo VFL y sus resultados. Proporcionar aclaraciones sobre los resultados del modelo puede conducir inherentemente a formas de extraer información privada. Por lo tanto, todavía hay mucho trabajo por hacer en ambos lados y para varios escenarios en el contexto de VPL».

Más información:

Morteza Varasteh, Privacidad contra ataques de inferencia agnóstica en el aprendizaje federado vertical, arXiv (2023). DOI: 10.48550/arxiv.2302.05545

© 2023 Ciencia X Red

Citación: Un nuevo ataque de inferencia que podría permitir el acceso a datos confidenciales del usuario (2023, 7 de marzo) recuperado el 7 de marzo de 2023 de https://techxplore.com/news/2023-03-inference-enable-access-Sensible-user.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.