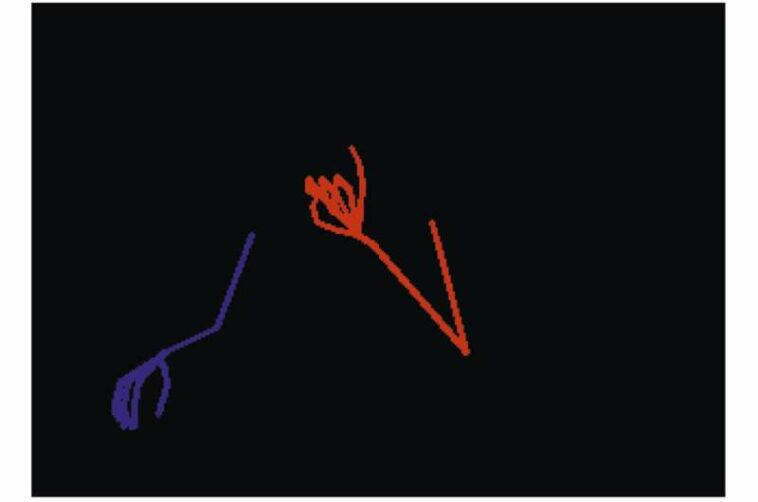

Muestra de conjunto de datos de imágenes con elementos de signos codificados por colores. Crédito: Inteligencia Computacional y Neurociencia (2021). DOI: 10.1155/2021/5532580

El Grupo de Robótica y Visión Tridimensional (RoViT) de la Universidad de Alicante (UA) ha diseñado la primera aplicación capaz de reconocer e interpretar el alfabeto de la lengua de signos española (conocida por las siglas LSE) en tiempo real.

La aplicación se llama Sign4all y es un gran avance que ayuda a romper las barreras de comunicación entre personas sordas y oyentes en situaciones cotidianas como ir al consultorio de un médico o comer en un restaurante. Según la última Encuesta sobre Discapacidad, Autonomía Personal y Situaciones de Dependencia del Instituto Nacional de Estadística (INE), en España hay 1.230.000 personas con discapacidad auditiva de diferentes tipos y grados. De estas, 27.300 personas utilizan la lengua de signos para comunicarse.

Gracias al uso de diferentes técnicas de visión artificial y aprendizaje profundo, Ph.D. la ingeniera informática e investigadora de la UA Ester Martínez, junto con el Ph.D. estudiante Francisco Morillas, ha desarrollado esta herramienta de bajo coste para poder ofrecer ayuda a las personas sordas cuando no pueden ser asistidas por un intérprete.

Sign4all, tras extraer el detalle del esqueleto de brazos y manos, codifica el lado izquierdo del cuerpo en azul y el lado derecho en rojo, manteniendo en todo momento el anonimato del usuario. A partir de ese momento, la aplicación traduce la seña utilizada por la persona sorda en tiempo real y en sentido contrario. Es capaz de usar un avatar virtual para firmar palabras en español escritas por la persona oyente. La idea es que todo este proceso se pueda hacer descargando una aplicación y usando la propia cámara del móvil o tablet, de forma que se pueda utilizar en cualquier lugar, según explica Martínez.

Según el investigador de la UA, tras muchas pruebas, Sign4all consigue interpretar y reconocer el alfabeto LSE con una precisión del 80%. Si bien este resultado corresponde al alfabeto dactilológico, están trabajando en una versión con un vocabulario específico perteneciente al campo de las tareas cotidianas donde pueden interpretar oraciones completas.

El equipo de la UA lleva meses entrenando este nuevo sistema, introduciendo cada vez más señales. En este sentido, ha surgido una colaboración con el Grupo de Investigación en Lengua Española y Lenguas de Signos (GRILES) de la Universidad de Vigo, un equipo con una dilatada experiencia en el estudio de esta lengua y su uso en diferentes territorios. La Universidad de Vigo está recogiendo imágenes con intérpretes y la UA está procesando todos estos datos. De esta forma, el vocabulario del sistema de reconocimiento e interpretación LSE se puede mejorar y ampliar mucho más rápidamente.

La investigación se publica en la revista Inteligencia Computacional y Neurociencia.

Más información:

Ester Martinez-Martin et al, Técnicas de Aprendizaje Profundo para la Interpretación de la Lengua de Signos Española, Inteligencia Computacional y Neurociencia (2021). DOI: 10.1155/2021/5532580

Citación: La primera aplicación capaz de reconocer e interpretar el alfabeto de la lengua de signos española (16 de febrero de 2023) recuperado el 16 de febrero de 2023 de https://techxplore.com/news/2023-02-application-capable-spanish-language-alphabet.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.