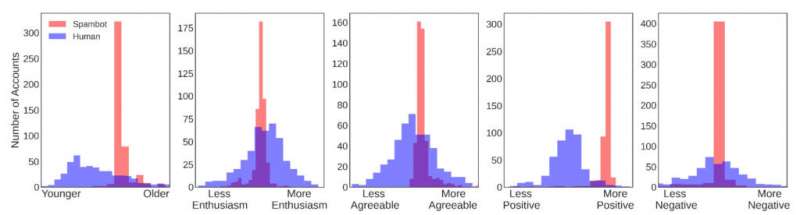

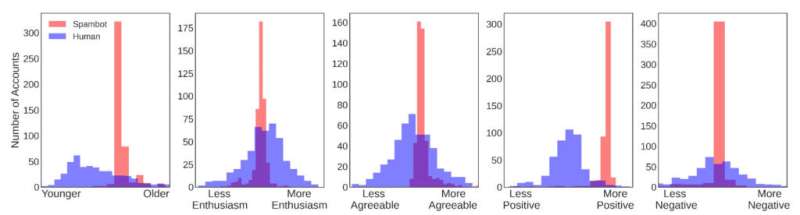

Distribución de cuentas humanas (azul) y bot (rojo) por edad, personalidad y sentimiento. En cada rasgo, las cuentas humanas tienen una gran variedad de valores, mientras que las cuentas de bot están agrupadas dentro de un rango pequeño. Por entusiasmo, amabilidad y negatividad, los bots se agrupan alrededor del centro de la distribución humana, lo que demuestra que estas cuentas exhiben rasgos muy promedio. Crédito: Universidad de Pensilvania

Los bots sociales, o cuentas de redes sociales automatizadas que se hacen pasar por personas genuinas, se han infiltrado en todo tipo de discusiones, incluidas las conversaciones sobre temas importantes, como la pandemia de COVID-19. Estos bots no son como llamadas automáticas o correos electrónicos no deseados; Estudios recientes han demostrado que los usuarios de las redes sociales los encuentran en su mayoría indistinguibles de los humanos reales.

Ahora, un nuevo estudio realizado por investigadores de la Universidad de Pensilvania y la Universidad de Stony Brook, publicado en Findings of the Association for Computational Linguistics, da una mirada más cercana a cómo estos bots se disfrazan. A través de técnicas de procesamiento de lenguaje natural y aprendizaje automático de última generación, los investigadores estimaron qué tan bien los bots imitan 17 atributos humanos, incluida la edad, el género y una variedad de emociones.

El estudio arroja luz sobre cómo se comportan los bots en las plataformas de redes sociales e interactúan con cuentas genuinas, así como las capacidades actuales de las tecnologías de generación de bots.

También sugiere una nueva estrategia para detectar bots: si bien el lenguaje utilizado por cualquier bot reflejaba rasgos de personalidad convincentemente humanos, su similitud entre sí traicionaba su naturaleza artificial.

«Esta investigación nos da una idea de cómo los bots pueden interactuar con estas plataformas sin ser detectados», dijo el autor principal Salvatore Giorgi, estudiante de posgrado en el Departamento de Ciencias de la Información y la Computación (CIS) de la Facultad de Ingeniería y Ciencias Aplicadas de Penn. «Si un usuario de Twitter piensa que una cuenta es humana, entonces es más probable que interactúe con esa cuenta. Dependiendo de la intención del bot, el resultado final de esta interacción podría ser inocuo, pero también podría llevar a involucrarse con información errónea potencialmente peligrosa. . «

Junto con Giorgi, la investigación fue realizada por Lyle Ungar, profesor en CIS, y el autor principal H. Andrew Schwartz, profesor asociado en el Departamento de Ciencias de la Computación de la Universidad de Stony Brook.

Algunos de los trabajos anteriores de los investigadores mostraron cómo el lenguaje de las publicaciones en las redes sociales se puede usar para predecir con precisión una serie de atributos del autor, incluida su edad, género y cómo obtendría una puntuación en una prueba de los «Cinco grandes» rasgos de personalidad. : apertura a la experiencia, escrupulosidad, extraversión, amabilidad y neuroticismo.

El nuevo estudio analizó más de 3 millones de tweets creados por tres mil cuentas de bot y un número igual de cuentas genuinas. Basándose únicamente en el lenguaje de estos tweets, los investigadores estimaron 17 características para cada cuenta: edad, género, los cinco rasgos de personalidad de los Cinco Grandes, ocho emociones (como alegría, ira y miedo) y sentimiento positivo / negativo.

Sus resultados mostraron que, individualmente, los bots parecen humanos y tienen valores razonables para su demografía, emociones y rasgos de personalidad estimados. Sin embargo, en su conjunto, los robots sociales parecen clones entre sí, en términos de sus valores estimados en los 17 atributos.

De manera abrumadora, el lenguaje que usaban los bots parecía ser característico de una persona de veintitantos años y abrumadoramente positivo.

El análisis de los investigadores reveló que la uniformidad de los puntajes de los bots sociales en los 17 rasgos humanos era tan fuerte que decidieron probar qué tan bien funcionarían estos rasgos como las únicas entradas para un detector de bots.

«Imagina que estás tratando de encontrar espías entre una multitud, todos con disfraces muy buenos pero también muy similares», dice Schwartz. «Mirando a cada uno individualmente, se ven auténticos y se mezclan extremadamente bien. Sin embargo, cuando alejas el zoom y miras a toda la multitud, son obvios porque el disfraz es muy común. La forma en que interactuamos con las redes sociales, somos no se ha alejado, solo vemos algunos mensajes a la vez. Este enfoque ofrece a los investigadores y analistas de seguridad una visión general para ver mejor el disfraz común de los bots sociales «.

Por lo general, los detectores de bots se basan en más funciones o en una combinación compleja de información de la red social del bot y las imágenes que publican. Schwartz y Giorgi descubrieron que al agrupar automáticamente las cuentas en dos grupos basados solo en estos 17 rasgos y sin etiquetas de bot, uno de los dos grupos terminó siendo casi en su totalidad bots. De hecho, pudieron usar esta técnica para hacer un detector de bots sin supervisión, y aproximadamente coincidió con la precisión del estado de la técnica (tasa de verdaderos positivos: 0,99, sensibilidad / recuperación: 0,95).

«Los resultados no fueron en absoluto los que esperábamos», dijo Giorgi. «La hipótesis inicial era que las cuentas de los bots sociales se verían claramente inhumanas. Por ejemplo, pensamos que nuestro clasificador podría estimar la edad de un bot en 130 o 50 en negativo, lo que significa que un usuario real podría darse cuenta de que algo andaba mal. Pero en los 17 rasgos, encontramos principalmente que los bots se encontraban dentro de un rango ‘humano’, a pesar de que había una variación extremadamente limitada en la población de bot «.

Por el contrario, al observar las estimaciones de rasgos humanos de los bots no sociales, cuentas automatizadas que no intentan ocultar su naturaleza artificial, las distribuciones de rasgos coincidían con las de la hipótesis original: valores estimados que caían fuera de los rangos humanos normales y aparentemente aleatorios. distribuciones a nivel de población.

«Hay mucha variación en el tipo de cuentas que uno puede encontrar en Twitter, con un paisaje casi de ciencia ficción: humanos, clones similares a humanos que fingen ser humanos y robots», dice Giorgi.

Salvatore Giorgi et al, Caracterizando los Spambots Sociales por sus Rasgos Humanos, Hallazgos de la Asociación de Lingüística Computacional: ACL-IJCNLP 2021 (2021). DOI: 10.18653 / v1 / 2021.findings-acl.457

Citación: Los bots de las redes sociales pueden parecer humanos, pero sus personalidades similares los delatan (2021, 24 de noviembre) recuperado el 24 de noviembre de 2021 de https://techxplore.com/news/2021-11-social-media-bots-human-similar. html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.