|

|

Desde que anunciamos Amazon SageMaker AI con MLflow en junio de 2024, nuestros clientes han estado utilizando servidores de seguimiento de MLflow para administrar sus flujos de trabajo de experimentación de IA y aprendizaje automático (ML). Sobre la base de esta base, continuamos evolucionando la experiencia de MLflow para hacer que la experimentación sea aún más accesible.

Hoy, me complace anunciar que Amazon SageMaker AI con MLflow ahora incluye una capacidad sin servidor que elimina la administración de infraestructura. Esta nueva capacidad de MLflow transforma el seguimiento de experimentos en una experiencia inmediata bajo demanda con escalamiento automático que elimina la necesidad de planificación de capacidad.

El cambio hacia una gestión sin infraestructura cambia fundamentalmente la forma en que los equipos abordan la experimentación con IA: las ideas se pueden probar inmediatamente sin planificación de infraestructura, lo que permite flujos de trabajo de desarrollo más iterativos y exploratorios.

Introducción a Amazon SageMaker AI y MLflow

Permítame guiarle en la creación de su primera instancia de MLflow sin servidor.

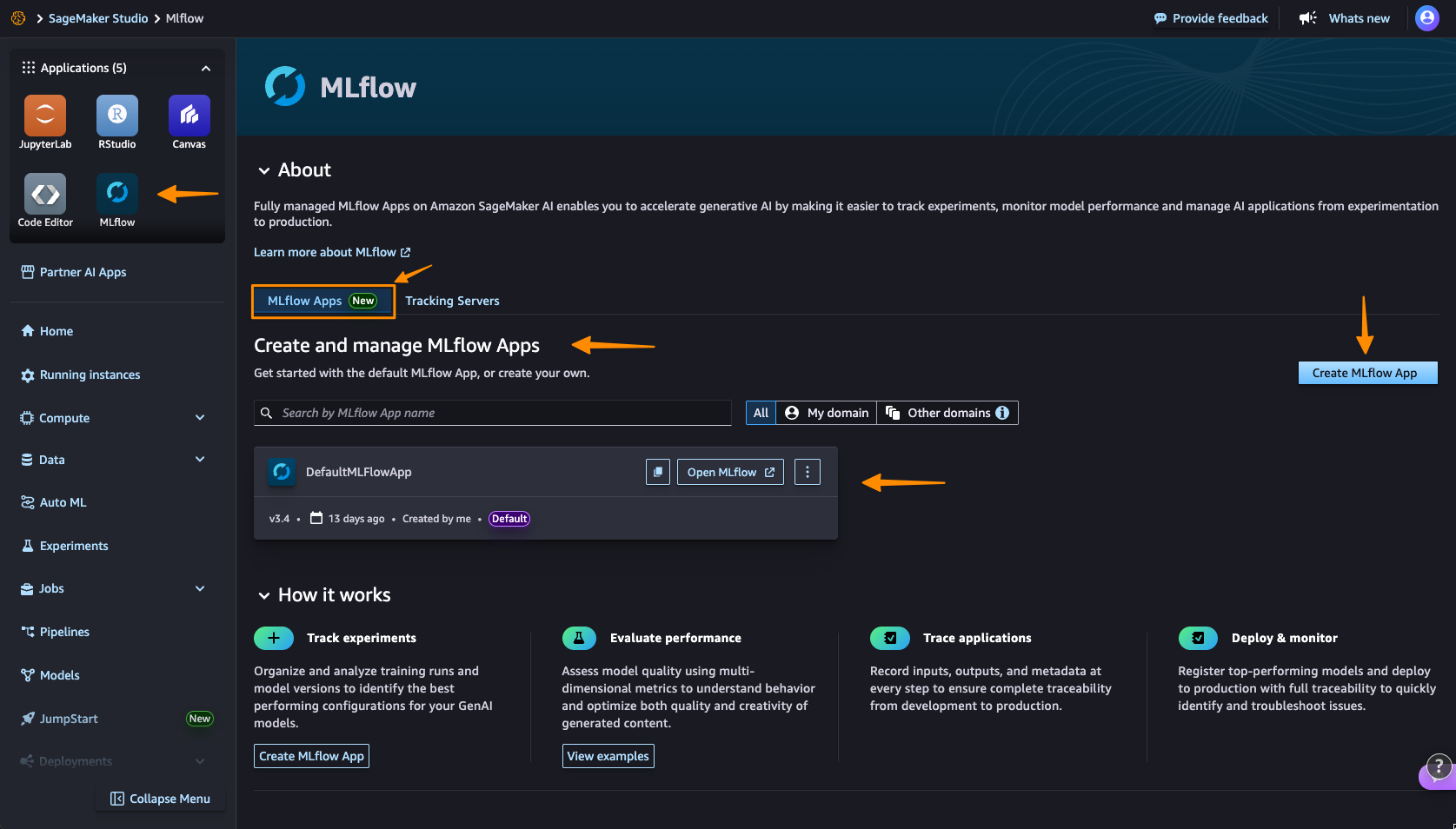

Navego a la consola de Amazon SageMaker AI Studio y selecciono el flujo ml solicitud. El término Aplicaciones de flujo ml reemplaza el anterior Servidores de seguimiento de MLflow terminología, que refleja el enfoque simplificado y centrado en la aplicación.

Aquí puedo ver que ya se ha creado una aplicación MLflow predeterminada. Esta experiencia simplificada de MLflow hace que me resulte más sencillo comenzar a realizar experimentos.

yo elijo Crear aplicación MLflowy escriba un nombre. Aquí, ya tengo configurado un rol de AWS Identity and Access Management (IAM) y un depósito de Amazon Simple Service (Amazon S3). Sólo necesito modificarlos en Configuraciones avanzadas si es necesario.

Aquí es donde se hace evidente la primera mejora importante: el proceso de creación se completa en aproximadamente 2 minutos. Esta disponibilidad inmediata permite una experimentación rápida sin retrasos en la planificación de la infraestructura, eliminando el tiempo de espera que antes interrumpía los flujos de trabajo de experimentación.

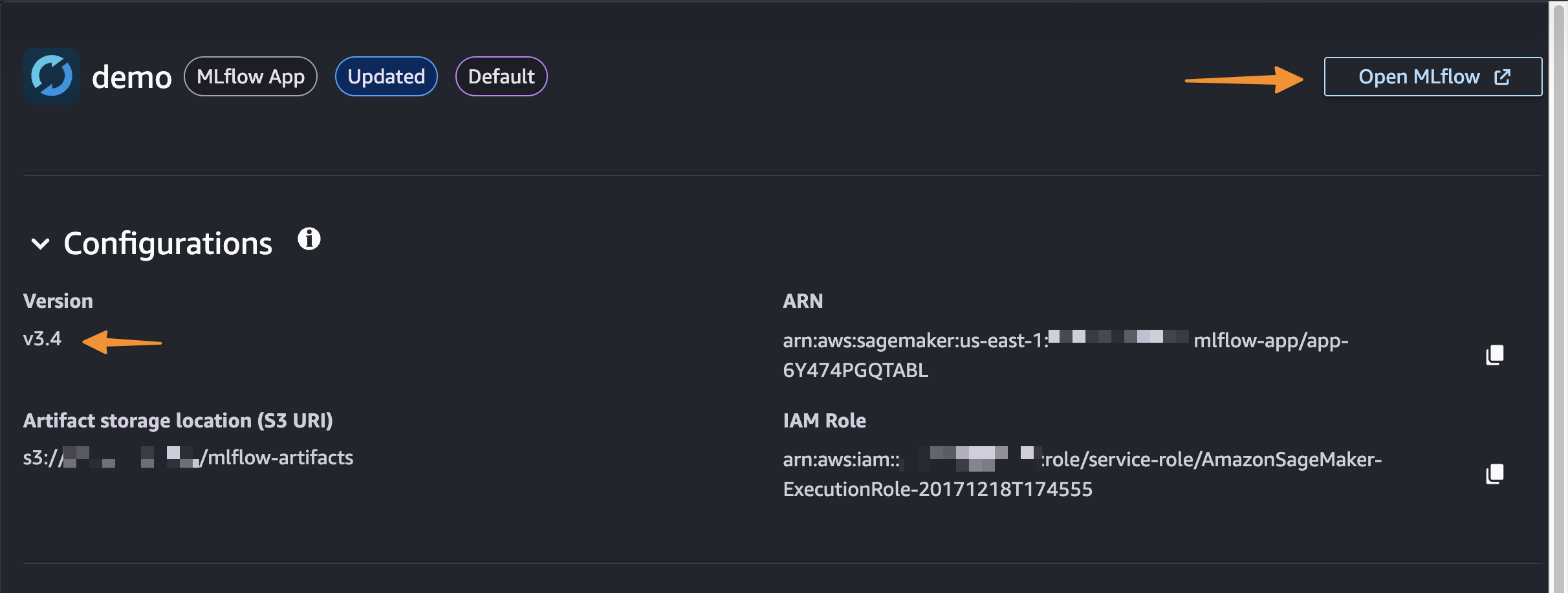

Una vez creado, recibo un nombre de recurso de Amazon (ARN) de MLflow para conectarme desde cuadernos. La gestión simplificada significa que no se requieren decisiones sobre el tamaño del servidor ni planificación de la capacidad. Ya no necesito elegir entre diferentes configuraciones ni administrar la capacidad de la infraestructura, lo que significa que puedo concentrarme completamente en la experimentación. Puede aprender a utilizar MLflow SDK en Integre MLflow con su entorno en la Guía para desarrolladores de Amazon SageMaker.

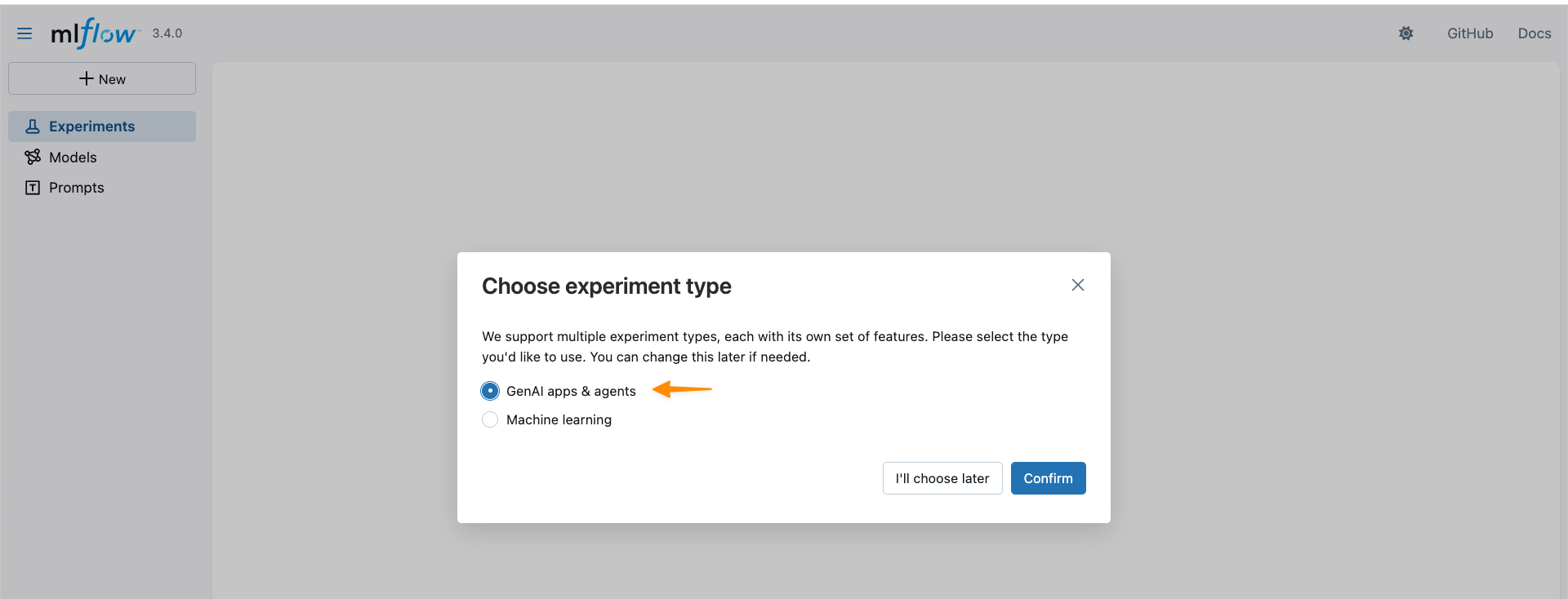

Con la compatibilidad con MLflow 3.4, ahora puedo acceder a nuevas capacidades para el desarrollo de IA generativa. MLflow Tracing captura rutas de ejecución detalladas, entradas, salidas y metadatos durante todo el ciclo de vida del desarrollo, lo que permite una depuración eficiente en sistemas de IA distribuidos.

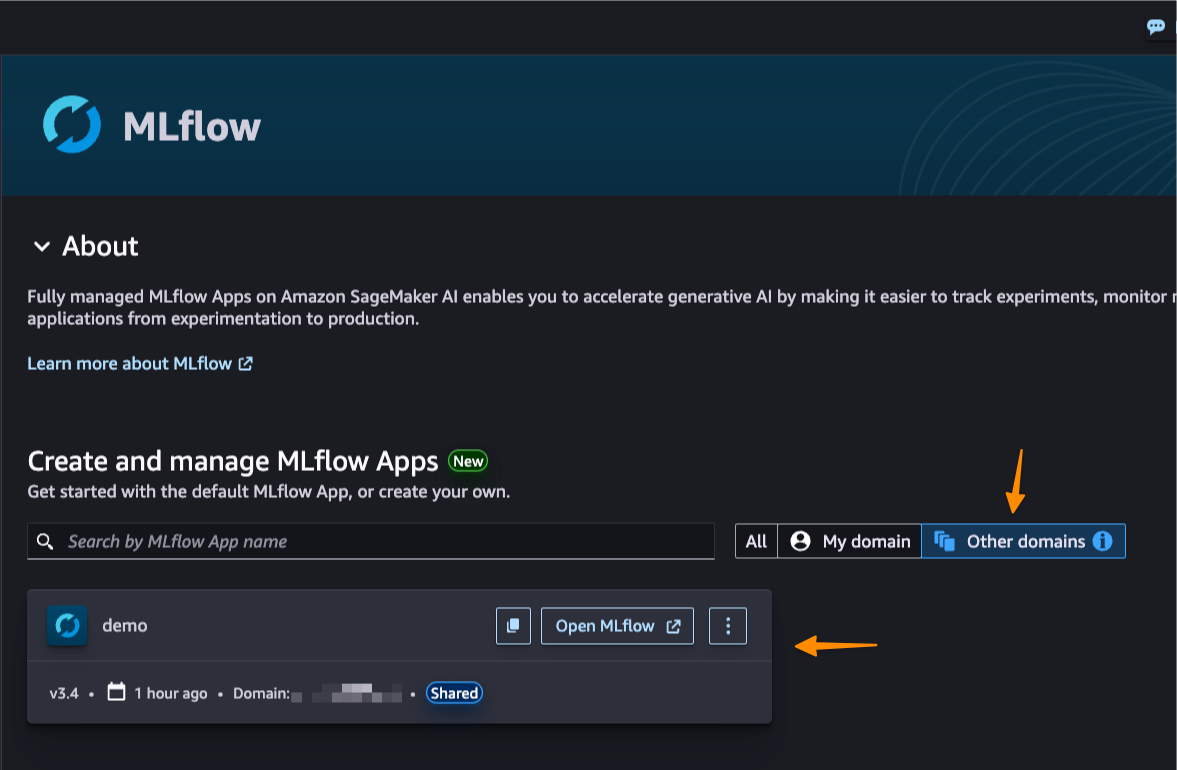

Esta nueva capacidad también introduce el acceso entre dominios y cuentas a través del recurso compartido de AWS Resource Access Manager (AWS RAM). Esta colaboración mejorada significa que los equipos de diferentes dominios y cuentas de AWS pueden compartir instancias de MLflow de forma segura, rompiendo los silos organizacionales.

Mejor juntos: integración de oleoductos

Amazon SageMaker Pipelines está integrado con MLflow. SageMaker Pipelines es un servicio de orquestación de flujo de trabajo sin servidor diseñado específicamente para la automatización de operaciones de aprendizaje automático (MLOps) y operaciones de modelos de lenguaje grandes (LLMOps): las prácticas de implementación, monitoreo y administración de modelos ML y LLM en producción. Puede crear, ejecutar y monitorear fácilmente flujos de trabajo de IA repetibles de un extremo a otro con una interfaz de usuario intuitiva de arrastrar y soltar o el SDK de Python.

A partir de una canalización, se creará una aplicación MLflow predeterminada si aún no existe una. El nombre del experimento se puede definir y las métricas, parámetros y artefactos se registran en la aplicación MLflow como se define en su código. SageMaker AI con MLflow también está integrado con capacidades conocidas de desarrollo de modelos de SageMaker AI, como SageMaker AI JumpStart y Model Registry, lo que permite la automatización del flujo de trabajo de un extremo a otro, desde la preparación de datos hasta el ajuste del modelo.

Cosas que debes saber

Aquí hay puntos clave a tener en cuenta:

- Precios – La nueva capacidad MLflow sin servidor se ofrece sin costo adicional. Tenga en cuenta que se aplican límites de servicio.

- Disponibilidad – Esta capacidad está disponible en las siguientes regiones de AWS: EE. UU. Este (Norte de Virginia, Ohio), EE. UU. Oeste (Norte de California, Oregón), Asia Pacífico (Mumbai, Seúl, Singapur, Sídney, Tokio), Canadá (Central), Europa (Frankfurt, Irlanda, Londres, París, Estocolmo), América del Sur (São Paulo).

- Actualizaciones automáticas: Las actualizaciones de la versión local de MLflow se realizan automáticamente, lo que brinda acceso a las funciones más recientes sin trabajo de migración manual ni problemas de compatibilidad. Actualmente, el servicio es compatible con MLflow 3.4, lo que brinda acceso a las capacidades más recientes, incluidas funciones de seguimiento mejoradas.

- Apoyo a la migración – Puede utilizar la herramienta de exportación e importación MLflow de código abierto disponible en mlflow-exportación-importación para ayudar a migrar desde servidores de seguimiento existentes, ya sean de SageMaker AI, autohospedados o de otro modo a MLflow sin servidor (aplicaciones MLflow).

Comience con MLflow sin servidor visitando Amazon SageMaker AI Studio y creando su primera aplicación MLflow. Serverless MLflow también es compatible con SageMaker Unified Studio para mayor flexibilidad en el flujo de trabajo.

¡Feliz experimento!

— donnie