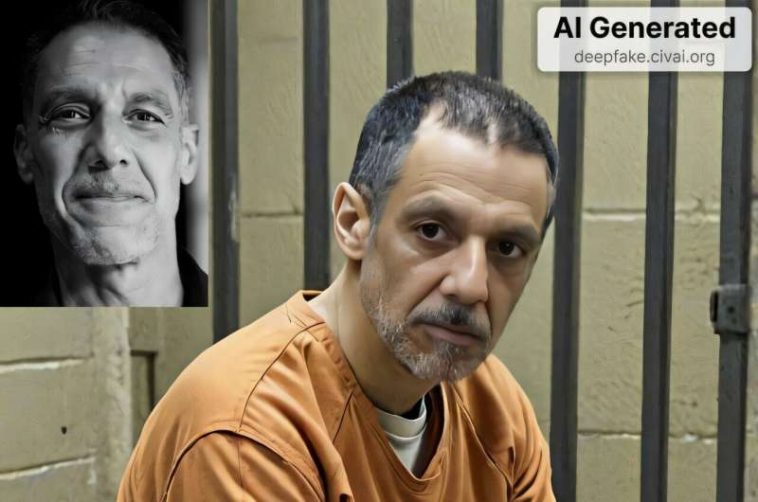

Un profundo en el que el autor insertó su propia cara (fuente en la parte superior izquierda) en una imagen generada por la IA de un recluso en un mono naranja. Crédito: imagen de IA creada por Hany Farid

En una perspectiva, Hany Farid destaca el riesgo de imágenes y videos fraudulentos manipulados y fraudulentos, conocidos como defensores profundos, y explora las intervenciones que podrían mitigar los daños que los defectos que los defectos pueden causar.

En el PNAS NEXUS artículoFarid explica que discriminar visualmente lo real de la falsa se ha vuelto cada vez más difícil y resume su investigación sobre técnicas forenses digitales, utilizadas para determinar si se han manipulado imágenes y videos.

Farid celebra los usos positivos de la IA generativa, que incluyen ayudar a los investigadores, democratizar la creación de contenido y, en algunos casos, literalmente dando voz a aquellos cuya voz ha sido silenciada por la discapacidad. Pero advierte contra los usos dañinos de la tecnología, incluidas imágenes íntimas no consensuadas, imágenes de abuso sexual infantil, fraude y desinformación. Además, la existencia de la tecnología Deepfake significa que los actores maliciosos pueden poner en duda las imágenes legítimas simplemente afirmando que las imágenes están hechas con IA.

Entonces, ¿qué se debe hacer? Farid destaca una variedad de intervenciones para mitigar tales daños, incluidos los requisitos legales para marcar el contenido de IA con metadatos y marcas de agua imperceptibles, límites de qué indicaciones deben permitir los servicios y los sistemas para vincular las identidades de los usuarios con el contenido creado.

Además, los moderadores de contenido de las redes sociales deben prohibir imágenes y videos nocivos. Además, Farid pide que la alfabetización de medios digitales sea parte del plan de estudios educativo estándar. Farid resume las técnicas de autenticación que los expertos pueden utilizar para ordenar lo real de lo sintético, y explora el panorama de la política en torno al contenido dañino.

Finalmente, Farid pide a los investigadores que se detengan y cuestionen si su producción de investigación puede ser mal utilizada y, de ser así, si tomar medidas para evitar el mal uso o incluso abandonar el proyecto por completo. El hecho de que se pueda crear algo no significa que debe crearse.

Más información:

Mitigando los daños de los medios manipulados: confrontar defectos profundos y engaño digital, PNAS NEXUS (2025). Academic.oup.com/pnasnexus/art … 93/PNASNEXUS/PGAF194

Proporcionado por PNAS Nexus

Citación: Estrategias de detección de fraude descritas pueden explicar cómo sobrevivir a la explosión de Deepfakes (2025, 29 de julio) Recuperado el 29 de julio de 2025 de https://techxplore.com/news/2025-07-fraud-statrategies- Survive-explosion.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.