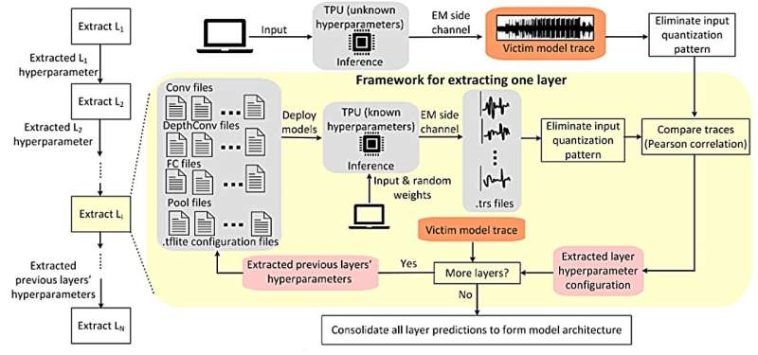

Marco integral de extracción de hiperparámetros propuesto. Crédito: Transacciones IACR sobre hardware criptográfico y sistemas integrados (2024). DOI: 10.46586/tches.v2025.i1.78-103

Los investigadores han demostrado la capacidad de robar un modelo de inteligencia artificial (IA) sin piratear el dispositivo donde se ejecutaba el modelo. La técnica es novedosa porque funciona incluso cuando el ladrón no tiene conocimiento previo del software o la arquitectura que respalda la IA.

«Los modelos de IA son valiosos, no queremos que la gente los robe», afirma Aydin Aysu, coautor de un artículo sobre el trabajo y profesor asociado de ingeniería eléctrica e informática en la Universidad Estatal de Carolina del Norte.

«Construir un modelo es costoso y requiere importantes recursos informáticos. Pero lo que es igualmente importante, cuando un modelo se filtra o es robado, también se vuelve más vulnerable a los ataques, porque terceros pueden estudiar el modelo e identificar cualquier debilidad».

«Como señalamos en el artículo, los ataques de robo de modelos a dispositivos de inteligencia artificial y aprendizaje automático socavan los derechos de propiedad intelectual, comprometen la ventaja competitiva de los desarrolladores del modelo y pueden exponer datos confidenciales integrados en el comportamiento del modelo», dice Ashley Kurian, primera autora de el artículo y un doctorado. estudiante en NC State.

El artículo, «TPUXtract: un marco exhaustivo de extracción de hiperparámetros», es publicado en línea en el Transacciones IACR sobre hardware criptográfico y sistemas integrados. En este trabajo, los investigadores robaron los hiperparámetros de un modelo de IA que se ejecutaba en una Unidad de procesamiento tensorial (TPU) Edge de Google.

«En términos prácticos, eso significa que pudimos determinar la arquitectura y las características específicas (conocidas como detalles de capa) que necesitaríamos para hacer una copia del modelo de IA», dice Kurian.

«Como robamos la arquitectura y los detalles de las capas, pudimos recrear las características de alto nivel de la IA», dice Aysu. «Luego utilizamos esa información para recrear el modelo funcional de IA, o un sustituto muy cercano de ese modelo».

Los investigadores utilizaron Google Edge TPU para esta demostración porque es un chip disponible comercialmente que se usa ampliamente para ejecutar modelos de IA en dispositivos de borde, es decir, dispositivos utilizados por usuarios finales en el campo, a diferencia de los sistemas de IA que se usan para aplicaciones de bases de datos. .

«Esta técnica podría usarse para robar modelos de IA que se ejecutan en muchos dispositivos diferentes», afirma Kurian. «Mientras el atacante conozca el dispositivo desde el que quiere robar, pueda acceder al dispositivo mientras ejecuta un modelo de IA y tenga acceso a otro dispositivo con las mismas especificaciones, esta técnica debería funcionar».

La técnica utilizada en esta demostración se basa en el monitoreo de señales electromagnéticas. En concreto, los investigadores colocaron una sonda electromagnética encima de un chip de TPU. La sonda proporciona datos en tiempo real sobre los cambios en el campo electromagnético del TPU durante el procesamiento de la IA.

«Los datos electromagnéticos del sensor esencialmente nos dan una ‘firma’ del comportamiento de procesamiento de la IA», dice Kurian. «Esa es la parte fácil».

Para determinar la arquitectura y los detalles de las capas del modelo de IA, los investigadores comparan la firma electromagnética del modelo con una base de datos de otras firmas de modelos de IA realizadas en un dispositivo idéntico, es decir, otro Google Edge TPU, en este caso.

¿Cómo pueden los investigadores «robar» un modelo de IA para el que aún no tienen una firma? Ahí es donde las cosas se ponen complicadas.

Los investigadores cuentan con una técnica que les permite estimar la cantidad de capas en el modelo de IA objetivo. Las capas son una serie de operaciones secuenciales que realiza el modelo de IA, y el resultado de cada operación informa la siguiente operación. La mayoría de los modelos de IA tienen entre 50 y 242 capas.

«En lugar de intentar recrear toda la firma electromagnética de un modelo, lo que sería computacionalmente abrumador, lo descomponemos por capas», dice Kurian. «Ya tenemos una colección de 5.000 firmas de primera capa de otros modelos de IA. Así que comparamos la firma de primera capa robada con las firmas de primera capa en nuestra base de datos para ver cuál coincide más.

«Una vez que hemos realizado ingeniería inversa en la primera capa, eso informa qué 5.000 firmas seleccionamos para comparar con la segunda capa», dice Kurian. «Y este proceso continúa hasta que hayamos realizado ingeniería inversa en todas las capas y hayamos hecho efectivamente una copia del modelo de IA».

En su demostración, los investigadores demostraron que esta técnica era capaz de recrear un modelo de IA robado con una precisión del 99,91%.

«Ahora que hemos definido y demostrado esta vulnerabilidad, el siguiente paso es desarrollar e implementar contramedidas para protegernos contra ella», afirma Aysu.

Más información:

Ashley Kurian et al, TPUXtract: un marco exhaustivo de extracción de hiperparámetros, Transacciones IACR sobre hardware criptográfico y sistemas integrados (2024). DOI: 10.46586/tches.v2025.i1.78-103

Citación: Robar modelos de IA: una nueva técnica permite el robo sin piratear un dispositivo (2024, 12 de diciembre) recuperado el 12 de diciembre de 2024 de https://techxplore.com/news/2024-12-ai-technique-enables-theft-hacking.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.

GIPHY App Key not set. Please check settings