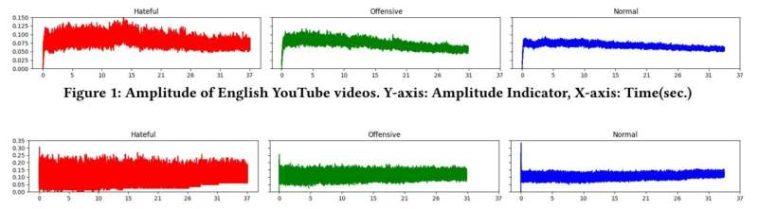

Crédito: Tasa de cruce por cero de vídeos de YouTube en inglés. Eje Y: Indicador de cruce por cero, Eje X: Tiempo (seg.)

Las redes sociales han revolucionado la forma en que se comparte la información en las comunidades, pero también pueden ser un pozo negro de contenido de odio. La investigación actual sobre la detección de contenidos que incitan al odio se centra en el análisis basado en texto, mientras que la detección de vídeos que incitan al odio sigue estando poco explorada.

«El discurso de odio en los videos se puede transmitir a través del lenguaje corporal, el tono y las imágenes, algo que el análisis de texto tradicional pasa por alto. A medida que plataformas como YouTube y TikTok llegan a grandes audiencias, el contenido de odio en forma de video puede ser más persuasivo y emocionalmente atractivo, lo que aumenta el riesgo de influir o radicalizar a los espectadores», explicó Roy Lee, profesor asistente de la Universidad de Tecnología y Diseño de Singapur (SUTD).

En su periódico «MultiHateClip: un conjunto de datos de referencia multilingüe para la detección de vídeos de odio en YouTube y Bilibili«, el profesor asistente Lee dirigió un equipo para desarrollar MultiHateClip, un novedoso conjunto de datos multilingüe que tiene como objetivo mejorar la detección de videos de odio en plataformas de redes sociales. Anteriormente creó SGHateCheck, una novedosa prueba funcional que evalúa el discurso de odio en entornos multilingües. El estudio se publica en arXiv servidor de preimpresión.

Utilizando léxicos de odio y anotaciones humanas centradas en el odio por motivos de género, MultiHateClip clasifica los vídeos en tres categorías: odiosos, ofensivos y normales. El contenido de odio implica discriminación contra un grupo específico de personas en función de atributos específicos, como la orientación sexual.

El contenido ofensivo es angustiante, pero carece del daño específico del discurso de odio y no incita al odio. El contenido normal no es odioso ni ofensivo. En comparación con una clasificación binaria (odioso versus no odioso), este sistema de tres categorías permite un enfoque más matizado para la moderación de contenido.

Después de revisar más de 10.000 vídeos, el equipo seleccionó 1.000 clips cortos anotados de YouTube y Bilibili para representar los idiomas inglés y chino, respectivamente, para MultiHateClip. Entre estos clips, surgió un patrón constante de odio por motivos de género contra las mujeres. La mayoría de estos videos utilizaron una combinación de elementos textuales, visuales y auditivos para transmitir el odio, lo que subraya la necesidad de un enfoque multimodal para comprender el discurso del odio.

En comparación con los conjuntos de datos existentes que son más simples y carecen de detalles, MultiHateClip está enriquecido con anotaciones completas y detalladas. Distingue entre videos de odio y ofensivos, y describe qué segmentos del video son de odio, quiénes son las víctimas objetivo y qué modalidades representan el odio (es decir, texto, visual, auditivo). También proporciona una sólida perspectiva intercultural, ya que incluye videos de contextos occidentales (YouTube) y chinos (Bilibili), destacando cómo el odio se expresa de manera diferente entre culturas.

El equipo esperaba que fuera difícil distinguir los vídeos de odio de los ofensivos, ya que ambos comparten similitudes, como lenguaje incendiario y temas controvertidos. El discurso de odio se dirige a grupos específicos, mientras que el contenido ofensivo causa malestar sin intención de discriminar. Las sutiles diferencias en tono, contexto e intención hacen que sea un desafío para los anotadores humanos y los modelos de aprendizaje automático trazar la línea entre contenido ofensivo y de odio.

«Además, los matices culturales y lingüísticos complican aún más la distinción, particularmente en contextos multilingües como el inglés y el chino, donde las expresiones de odio u ofensa pueden variar significativamente. Esta complejidad subraya la necesidad de modelos de detección más sofisticados que puedan capturar distinciones sutiles», enfatizó Asst. Profesor Lee.

El estudio también probó modelos de detección de vídeos de odio de última generación con MultiHateClip. Los resultados resaltaron tres limitaciones críticas en los modelos actuales: la dificultad para distinguir entre contenido ofensivo y de odio, las limitaciones de los modelos previamente entrenados en el manejo de datos culturales no occidentales y la comprensión insuficiente del odio implícito. Estas brechas enfatizan la necesidad de enfoques multimodales y culturalmente sensibles para la detección del discurso de odio.

MultiHateClip refleja el valor de la intersección del diseño, la inteligencia artificial y la tecnología. Su importancia en el mundo real es clara: detectar el discurso de odio y prevenir su difusión. Optimizado para contenido de video, el modelo tiene un enfoque intercultural y es especialmente útil en plataformas de redes sociales donde los videos son la forma principal de comunicación, como YouTube, TikTok y Bilibili. Los moderadores de contenido, los formuladores de políticas y las organizaciones educativas se beneficiarán del uso de MultiHateClip para comprender y mitigar la propagación del discurso de odio.

«En general, MultiHateClip desempeña un papel crucial en la creación de entornos en línea más seguros e inclusivos», dijo el profesor asistente Lee, quien compartió la posibilidad de colaborar con plataformas de redes sociales para implementar el modelo en entornos del mundo real. Además, el equipo podría estudiar la posibilidad de ampliar el conjunto de datos para incluir más idiomas y contextos culturales, mejorar el rendimiento del modelo mediante la creación de mejores algoritmos que puedan distinguir entre contenido ofensivo y de odio y desarrollar herramientas de detección de discursos de odio en tiempo real.

Más información:

Han Wang et al, MultiHateClip: un conjunto de datos de referencia multilingüe para la detección de videos que incitan al odio en YouTube y Bilibili, arXiv (2024). DOI: 10.48550/arxiv.2408.03468

Citación: Uso de un conjunto de datos multilingüe para mejorar la detección de videos que incitan al odio en YouTube y Bilibili (2024, 21 de octubre) obtenido el 21 de octubre de 2024 de https://techxplore.com/news/2024-10-multilingual-dataset-video-youtube-bilibili.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.

GIPHY App Key not set. Please check settings