La proliferación de pornografía falsa destaca la amenaza de la desinformación habilitada por IA, que puede dañar la reputación y provocar intimidación o acoso.

Aplicaciones fotográficas que desvisten digitalmente a mujeres, mensajes sexualizados de texto a imagen que crean «chicas con IA» e imágenes manipuladas que alimentan las estafas de «extorsión sexual»: un auge en la pornografía ultrafalsa está superando los esfuerzos de EE. UU. y Europa para regular la tecnología.

Las falsificaciones profundas habilitadas con inteligencia artificial generalmente se asocian con imágenes virales falsas de personalidades conocidas como el Papa Francisco con un abrigo acolchado o Donald Trump bajo arresto, pero los expertos dicen que se usan más ampliamente para generar pornografía no consensuada que puede destruir vidas comunes.

Las mujeres son un objetivo particular de las herramientas y aplicaciones de IA, ampliamente disponibles de forma gratuita y que no requieren experiencia técnica, que permiten a los usuarios quitarse digitalmente la ropa de sus imágenes o insertar sus rostros en videos sexualmente explícitos.

«El auge de la pornografía generada por IA y la pornografía falsa normaliza el uso de la imagen o semejanza de una mujer sin su consentimiento», dijo a la AFP Sophie Maddocks, investigadora de la Universidad de Pensilvania que rastrea el abuso sexual basado en imágenes.

«¿Qué mensaje enviamos sobre el consentimiento como sociedad cuando prácticamente puedes desnudar a cualquier mujer?»

En un video lloroso, una streamer estadounidense de Twitch que se hace llamar QTCinderella lamentó la «explotación y cosificación constantes» de las mujeres cuando se convirtió en víctima de la pornografía profunda. Fue acosada, agregó, por personas que le enviaban copias de los deepfakes que la representaban.

El escándalo estalló en enero durante una transmisión en vivo del también streamer Brandon Ewing, quien fue sorprendido mirando un sitio web que contenía imágenes sexuales falsas de varias mujeres, incluida QTCinderella.

«No es tan simple como ‘simplemente’ ser violada. Es mucho más que eso», escribió en Twitter, y agregó que la experiencia la había «arruinado».

‘Hiper-real’

La proliferación de deepfakes en línea subraya la amenaza de la desinformación habilitada por IA, que puede dañar la reputación y provocar intimidación o acoso.

Si bien celebridades como la cantante Taylor Swift y la actriz Emma Watson han sido víctimas de la pornografía falsa, las mujeres que no están en el ojo público también son el objetivo.

Los medios de comunicación estadounidenses y europeos están llenos de testimonios de primera mano de mujeres, desde académicas hasta activistas, que se sorprendieron al descubrir sus rostros en videos pornográficos falsos.

Alrededor del 96 por ciento de los videos deepfake en línea son pornografía no consensuada, y la mayoría de ellos representan a mujeres, según un estudio de 2019 realizado por la empresa holandesa de inteligencia artificial Sensity.

«El acto de fantasía sexual que antes era privado, que tiene lugar dentro de la mente de alguien, ahora se transfiere a la tecnología y a los creadores de contenido en el mundo real», dijo a la AFP Roberta Duffield, directora de inteligencia de Blackbird.AI.

«La facilidad de acceso y la falta de supervisión, junto con la creciente profesionalización de la industria, afianza estas tecnologías en nuevas formas de explotación y menosprecio de las mujeres».

Entre una nueva cosecha de generadores de texto a arte se encuentran aplicaciones gratuitas que pueden crear «chicas hiperrealistas con IA»: avatares a partir de fotos reales, personalizándolas con indicaciones como «piel oscura» y «correa para el muslo».

Las nuevas tecnologías, como Stable Diffusion, un modelo de IA de código abierto desarrollado por Stability AI, han hecho posible evocar imágenes realistas a partir de descripciones de texto.

‘Rincón oscuro’

Los avances tecnológicos han dado lugar a lo que Duffield llamó una «industria artesanal en expansión» en torno a la pornografía mejorada por IA, con muchos creadores de deepfakes que aceptan solicitudes pagas para generar contenido con una persona elegida por el cliente.

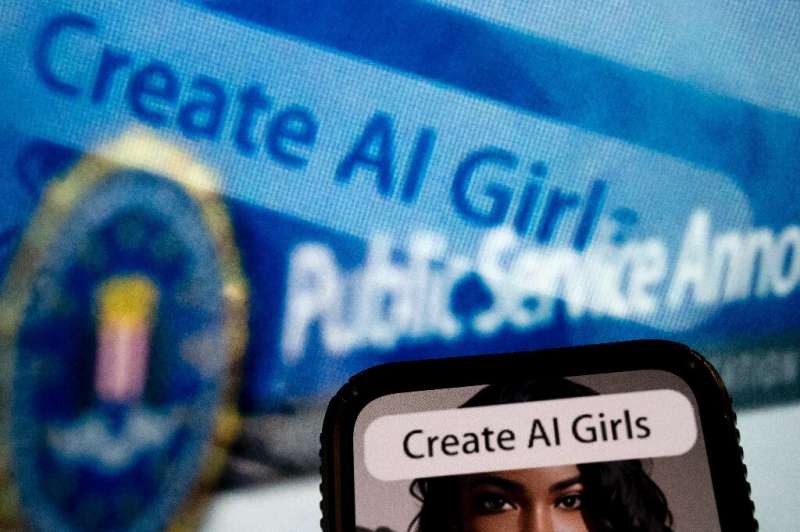

El mes pasado, el FBI emitió una advertencia sobre los «esquemas de sextorsión», en los que los estafadores capturan fotos y videos de las redes sociales para crear falsificaciones profundas «de temática sexual» que luego se utilizan para extorsionar dinero.

Las víctimas, agregó el FBI, incluían niños menores y adultos que no dieron su consentimiento.

La proliferación de herramientas de IA ha superado la regulación.

«Este no es un rincón oscuro de Internet donde se crean y comparten estas imágenes», dijo a la AFP Dan Purcell, director ejecutivo y fundador de la empresa de protección de marcas de inteligencia artificial Ceartas.

“Está justo debajo de nuestras narices. Y sí, la ley necesita ponerse al día”.

En Gran Bretaña, el gobierno ha propuesto un nuevo proyecto de ley de seguridad en línea que busca criminalizar el intercambio de deepfakes pornográficos.

Cuatro estados de EE. UU., incluidos California y Virginia, prohibieron la distribución de pornografía falsa, pero las víctimas suelen tener pocos recursos legales si los perpetradores viven fuera de estas jurisdicciones.

En mayo, un legislador de EE. UU. presentó la Ley de prevención de falsificaciones profundas de imágenes íntimas que haría ilegal compartir pornografía falsificada sin consentimiento.

Los espacios en línea populares como Reddit también han tratado de regular sus florecientes comunidades de pornografía de IA.

«Internet es una jurisdicción sin fronteras, y debe haber una ley internacional unificada para proteger a las personas contra esta forma de explotación», dijo Purcell.

© 2023 AFP

Citación: En la era de la IA, las mujeres luchan contra el aumento de la pornografía profunda (24 de julio de 2023) recuperado el 24 de julio de 2023 de https://techxplore.com/news/2023-07-age-ai-women-deepfake-porn.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.